El coche autónomo de Google, cuyos neumáticos ya acumulan cientos de kilómetros.

¿Comprarías un coche capaz de sacrificar tu vida para salvar otras?

Un estudio demuestra que los ciudadanos no están a favor de una regulación que obligue a los vehículos sin conductor a salvar el mayor número posible de vidas, y no necesariamente la de su dueño, ante la inminencia de un accidente inevitable.

23 junio, 2016 19:00Noticias relacionadas

No parece estar muy lejos el día en que los coches autónomos tomen nuestras calles. De hecho, las últimas estimaciones al respecto vaticinan que, para 2035, se habrán vendido 76 millones de vehículos inteligentes que ya circularán por las carreteras de medio mundo. Pese a todas las ventajas que trae consigo, como suele ocurrir con la llegada de una nueva tecnología, surgen nuevos dilemas que nos hacen dudar de la viabilidad de este tipo de proyectos.

El caso de los vehículos autónomos no iba a ser una excepción. Si bien la mayoría de los expertos coinciden en señalar que el número de accidentes a nivel global se reducirá hasta en un 90 % cuando la mayoría de los coches en circulación no estén pilotados por humanos, surge la duda de qué ocurrirá cuando esta máquina tenga que decidir a quién salvar la vida ante un accidente inevitable.

Un reciente estudio publicado en la revista Science, obra de los investigadores Jean-François Bonnefon, Azim Shariff y Iyad Rahwan, ha vuelto a poner sobre la mesa el dilema moral que se plantea cuando un algoritmo es quien se encarga de tomar la complicada decisión: ¿quién sobrevive y quién muere?

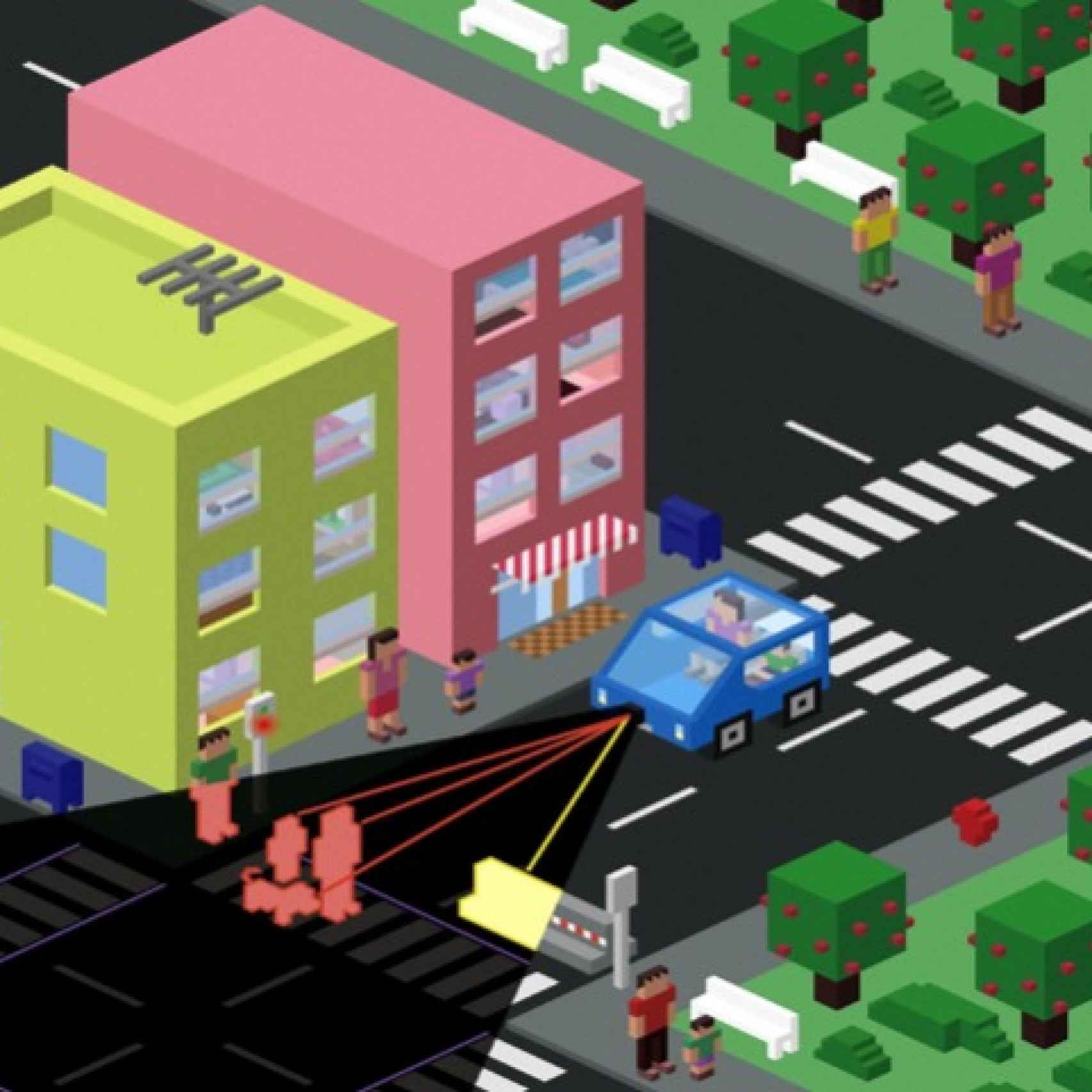

"Imagina que un vehículo autónomo se enfrenta a una situación en la que el accidente es inevitable. Puede evitar atropellar a un peatón, pero para ello tiene que chocarse contra un muro o caerse a un río o alguna otra acción que amenaza la vida de sus pasajeros, la gente que compró el coche. ¿Cuál es la acción más apropiada en ese caso?", se preguntaba Bonnefon en una charla con los medios. "¿Elegir hacer daño a los menos posibles o proteger a los pasajeros a toda costa?".

The social dilemma of self-driving cars

Para conocer lo que piensan al respecto quienes pronto podrán verse en una situación así, realizaron entre junio y noviembre de 2015 un total de seis encuestas a través de internet, en las que tomaron parte 1.928 ciudadanos residentes en Estados Unidos. En cada una de ellas planteaban a los encuestados distintos escenarios relativos a la ética del coche sin piloto.

Una de las principales conclusiones que se extraen de este estudio es que la mayoría coinciden al señalar que sería más correcto moralmente que el coche autónomo sacrificase la vida de sus pasajeros si con ello se salvasen más vidas. El número de víctimas parece ser un factor clave. En ese sentido, los encuestados no aprobaban que el vehículo pusiera en peligro la vida de sus tripulantes para salvar a un solo peatón.

¿Qué sería lo correcto? ¿Cuántas menos víctimas mejor o proteger a los pasajeros a toda costa? |

Si bien es cierto que, a tenor de la encuesta, no son muchos los estadounidenses dispuestos a adquirir un vehículo autónomo, sí que parecen más propensos a comprar estos vehículos si no llevan grabada en su programación la idea de salvar a otras personas a costa de la vida de su dueño. De ahí que otra de las cuestiones que los autores se plantearon fuera la necesidad o no de establecer regulaciones que obligasen a estos robots de cuatro ruedas a tomar una determinada decisión, en un sentido u otro.

¿Por qué no hacer que el gobierno lo regule?”, se preguntaba Rahwan en la conferencia de prensa. “En nuestra encuesta preguntamos a la gente si estaría a favor de una regulación que fuerce a todos los coches autónomos a estar programados de una forma que priorice la seguridad general, incluso si a veces significa sacrificar al pasajero, y la sorpresa fue que la gente tiene unos índices de aprobación muy bajos ante esta idea de regulación. Están sustancialmente menos dispuestos a comprar coches sin conductor si están regulados de esa forma”, comentaba este investigador.