Elliptic Labs presenta su tecnología de gestos con ultrasonidos: controla tu Android con gestos en el aire

Elliptic Labs presenta su tecnología de gestos con ultrasonidos: controla tu Android con gestos en el aire

Unos cuantos fabricantes han tratado de incorporar los gestos sin tocar la pantalla en sus diferentes dispositivos móviles: Samsung ha incorporado una tecnología con ese objetivo basado en infrarrojos en el Galaxy S4, la muerta Sony-Ericsson lo intentó con el Yari… y no hace falta irnos a dispositivos móviles, Kinect de Microsoft o Leap Motion nos proporcionan esa tecnología en consolas u sistemas de escritorio, respectivamente.

El problema es que siempre esta interacción ha estado muy limitada respecto a libertad de movimientos y distancia al sensor correspondiente, algo que se acentúa mas aún cuando tratamos de incorporar la tecnología a dispositivos móviles. Pero por suerte Elliptic Labs parecer tener una solución para este problema, dándonos una forma diferente de controlar nuestro dispositivo y sin tener tantas limitaciones como tienen sus rivales.

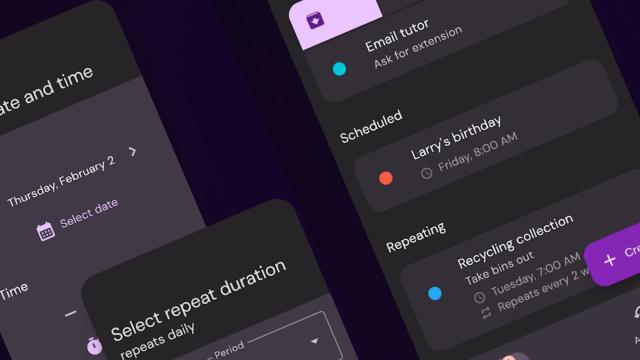

Para ponernos en situación, Elliptic Labs es una startup que empezó a dar sus primeros pasos allá por el 2006, desarrollando una tecnología basada en los ultrasonidos capaz de detectar gestos y habilitar una interfaz en la que todo se base en gestos sin necesidad de tocar la pantalla. El motivo por el que hoy son noticia es que han presentado una demo del sistema funcionando en una Tablet en CEATEC Japan 2013 y han hecho diferentes anuncios que nos interesan bastante a nosotros, los usuarios de Android y de dispositivos móviles en general.

El primero de estos anuncios es que esta tecnología esta preparada para funcionar en cualquier dispositivo basado en ARM según el CEO de la compañía, Haakon Bryhni. Pero no contentos con eso, también han anunciado que están trabajando con tres fabricantes de Android (que no han desvelado, siendo dos de Smartphones y uno de Tablets) para llevar sus sensores a diferentes dispositivos móviles. Ahora mismo esos prototipos están en una fase avanzada de pruebas, y esperan que entren en el mercado en la segunda mitad del año 2014.

Y hablando del SDK, este permitirá que los desarrolladores y OEMs jueguen con la tecnología y la apliquen a sus productos utilizando todo el potencial nativo. Pero además, junto al SDK también han anunciado que están desarrollando un método para introducir los gestos en aplicaciones que no dispongan de soporte nativo para ellos: gesture injection. Por poner un ejemplo, esto nos permitiría jugar a Fruit Ninja con gestos en el aire sin necesidad de esperar a que la aplicación se actualice con ese fin.

En todo caso, Bryhni tiene su propia visión de cómo esta tecnología puede tener más éxito: el potencial está en gestos que controlen la interfaz de usuario (para acciones como cambiar entre aplicaciones, abrir menús, navegar, visualizar imágenes…), en aplicaciones personalizadas como juegos o mapas, o incluso a la hora de recoger información sobre el lenguaje corporal del usuario (fijándose en los gestos y el lenguaje corporal).

En cualquier caso esta tecnología tiene muchísimo potencial, y esperemos que tanto las OEMs como los desarrolladores sepan sacar todo ese potencial a la hora de lanzar su software. Mientras tanto, estaremos atentos a cualquier noticia vinculada al lanzamiento de estos dispositivos o el SDK, para que seáis los primeros en enteraros ;)

Fuente | TechCrunch

Más información | Elliptic Labs