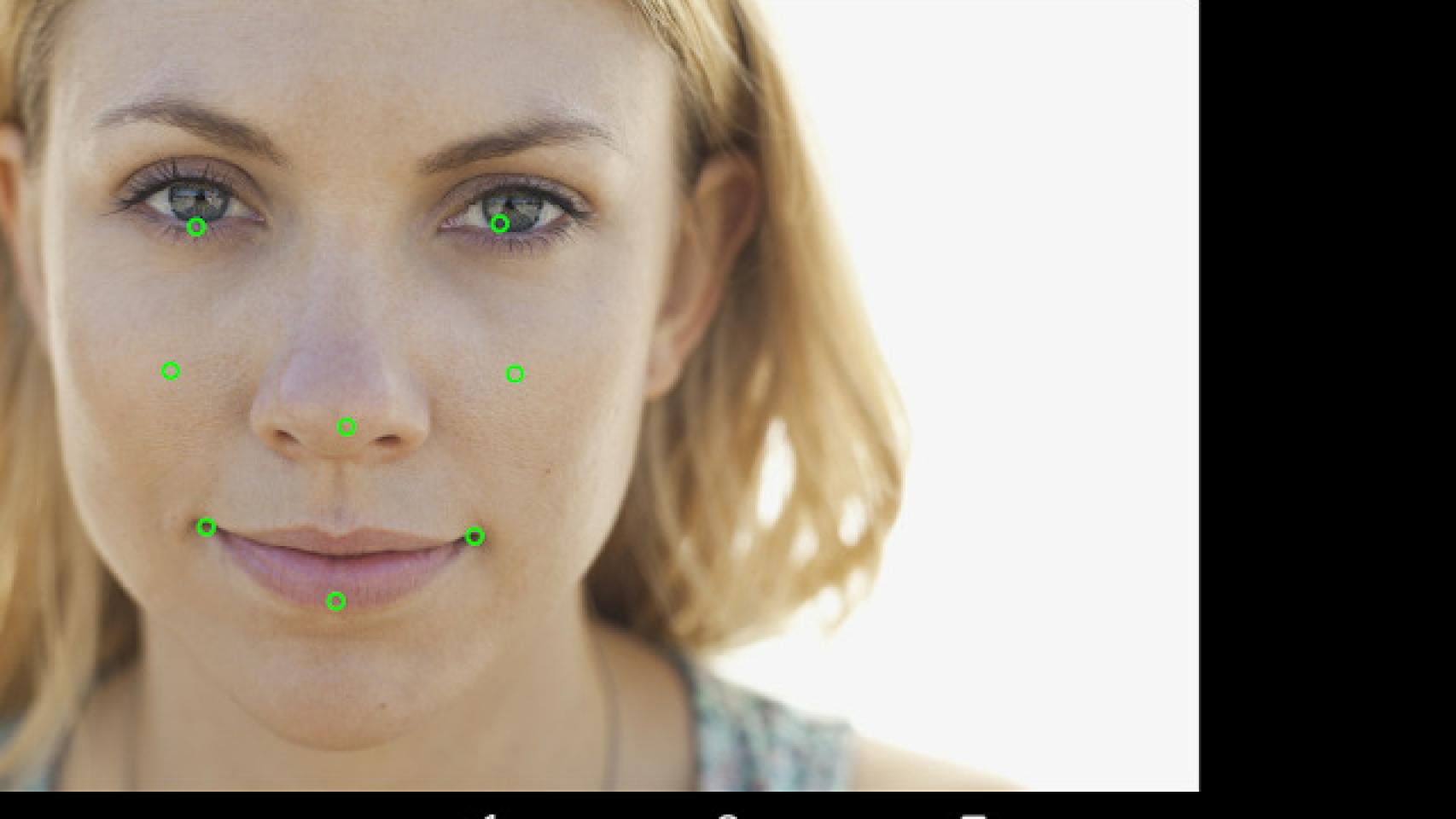

Google Play Services 7.8 se presentó hace unas semanas. Hoy Google aprovecha para mostrarnos más información de las nuevas API que podremos utilizar para crear aplicaciones que respondan mejor ante la persona que el móvil tiene delante. En esta última actualización de los Google Play Services se incluye la nueva Face API que permite detectar el rostro que está delante y sus expresiones faciales.

Con la API de detección de rostro podremos crear aplicaciones que respondan ante determinados gestos, como sonreír o cerrar los ojos. Para que os hagáis una idea, con esta API se podría crear un launcher que al cerrar los ojos fuera a la pantalla principal o un juego de mascotas en el que si sonreímos al móvil la criatura se pone contenta. Las posibilidades son enormes y la interacción entre usuario y aplicación aumentan.

Face Detection

La nueva API no reconoce el rostro, simplemente lo detecta. Es una pequeña diferencia pero clave para proteger la privacidad de los usuarios. Esta Face Detection API sustituye la antigua Android FaceDetector.Face API. Ha sido diseñada para detectar los rostros incluso en diferentes orientaciones, si por ejemplo la persona gira la cabeza.

Con este nivel de precisión podemos crear aplicaciones que tengan en cuenta perfectamente la situación del rostro y dibujar un bigote, hacer marcas en la piel o poner un sombrero en la cabeza. La idea no es nueva, pero con la nueva API los resultados son mucho más precisos.

Esta posibilidad de detectar un rostro a pesar de la orientación es importante cuando los datos que recibe la app son limitados. Imaginad que la cámara delantera no funciona bien, que la persona no se sitúa bien o tiene algún elemento extraño, con esta API nuestra app podrá ofrecer buenos resultados a pesar que el rostro sea difícil de detectar y ubicar.

Detectar códigos

Otra utilidad que tenemos en Google Play Services 7.8 es una API para detectar códigos de barras. Diréis, pero si esto ya lo tenemos desde hace años. Efectivamente, pero la nueva API es mucho más potente, de nuevo permite reconocer códigos independientemente de la orientación, nos permite detectarlos en tiempo real y también permite varios a la vez.

¿Es cómodo utilizar el reconocimiento de usuarios?

La idea es perfecta. Las posibilidades enormes. Imaginar una aplicación de fotos que hace la foto automáticamente cuando todos sonríen, o cuando todos se tocan la oreja izquierda. Imaginad poder enviar emojis de beso si damos un beso enfrente del móvil. La inteligencia del reconocimiento de personas permite poder interactuar con el móvil de una manera mucho más potente que simplemente apretando botones.

Estas son todas las partes que permite la nueva API reconocer: Parte inferior de la boca, mejilla izquierda, oreja izquierda, la punta de la oreja izquierda, ojo izquierdo, la boca la izquierda, la base de la nariz, la mejilla derecha, la oreja derecha, la punta de la oreja derecha, el ojo derecho o la boca derecha. A partir de estos puntos pueden reconocer decenas de gestos.

La pregunta que lanzamos. ¿Hasta qué punto debemos forzar los gestos para que funcione? ¿De verdad esta API es suficiente potente como para crear una experiencia fluida? En el vídeo de los Google Play Services vemos a un siempre genial Magnus Hyttsten forzando demasiado para la demostración. Espero que una app no me haga hacer esas caras estrafalarias para que funcione. Por todo lo demás, pinta genial. ¿Qué os parece?

Más información Android Developers