¿Ha ideado la humanidad su propia perdición con la Inteligencia Artificial? Lo que parece el argumento de una película de ciencia ficción de los 80 se ha convertido en un temor muy real, especialmente entre la gente más cercana a esta tecnología. El éxito de ChatGPT ha reavivado estos miedos, y sus propios creadores creen que nos podríamos estar acercando al “punto de no retorno”.

Cuando una IA no está “alienada”

En esta ocasión, ha sido Paul Christiano, investigador de IA, el que ha dado su pronóstico en el podcast Bankless. Christiano trabajó en OpenAI, creadora de ChatGPT, Dall-E y otros proyectos que han demostrado el potencial de la IA generativa; en la actualidad, su trabajo se centra en lo que se conoce como “alineación de la Inteligencia Artificial”, en otras palabras, cómo crear sistemas de IA que sean realmente seguros.

Una Inteligencia Artificial no alineada puede sorprender a hasta sus creadores

Básicamente, una Inteligencia Artificial que no está “alineada” hace cosas que no estaban previstas por sus propios creadores; es decir, cumple objetivos para las que no fue diseñada y se sale de los parámetros establecidos. Esto es más común de lo que podría parecer, ya que muchos modelos de IA se basan en cumplir objetivos intermedios hasta llegar al objetivo final; cuanto mejor y más eficientes sean esos objetivos, más “puntuación” recibe y en el siguiente bucle decide ir más por ese camino que por otros.

Cuanto más compleja es la IA, es más probable que esos objetivos intermedios la lleven por otros derroteros que puedan hacer más fácil cumplir cualquier objetivo, pero perdiendo de vista su propósito original.

Por ejemplo, puede que una IA llegue a la conclusión de que necesita más poder para realizar la tarea adjudicada de manera más sencilla y eficiente; y que se centre en encontrar maneras de obtener ese poder en vez de en solucionar el problema que se le planteó inicialmente. En el peor de los casos, los investigadores de OpenAI notaron que la IA se mete en una “laguna aislada” de la que no puede salir y sólo se centra en obtener los objetivos que se ha propuesto a sí misma.

Apocalipsis creado por IA

En un sistema de IA normal a lo mejor eso no tiene consecuencias; pero conforme las IA conquistan todos los aspectos de nuestras vidas, la alineación se convierte en un verdadero problema, hasta el punto de que puede acabar con la humanidad.

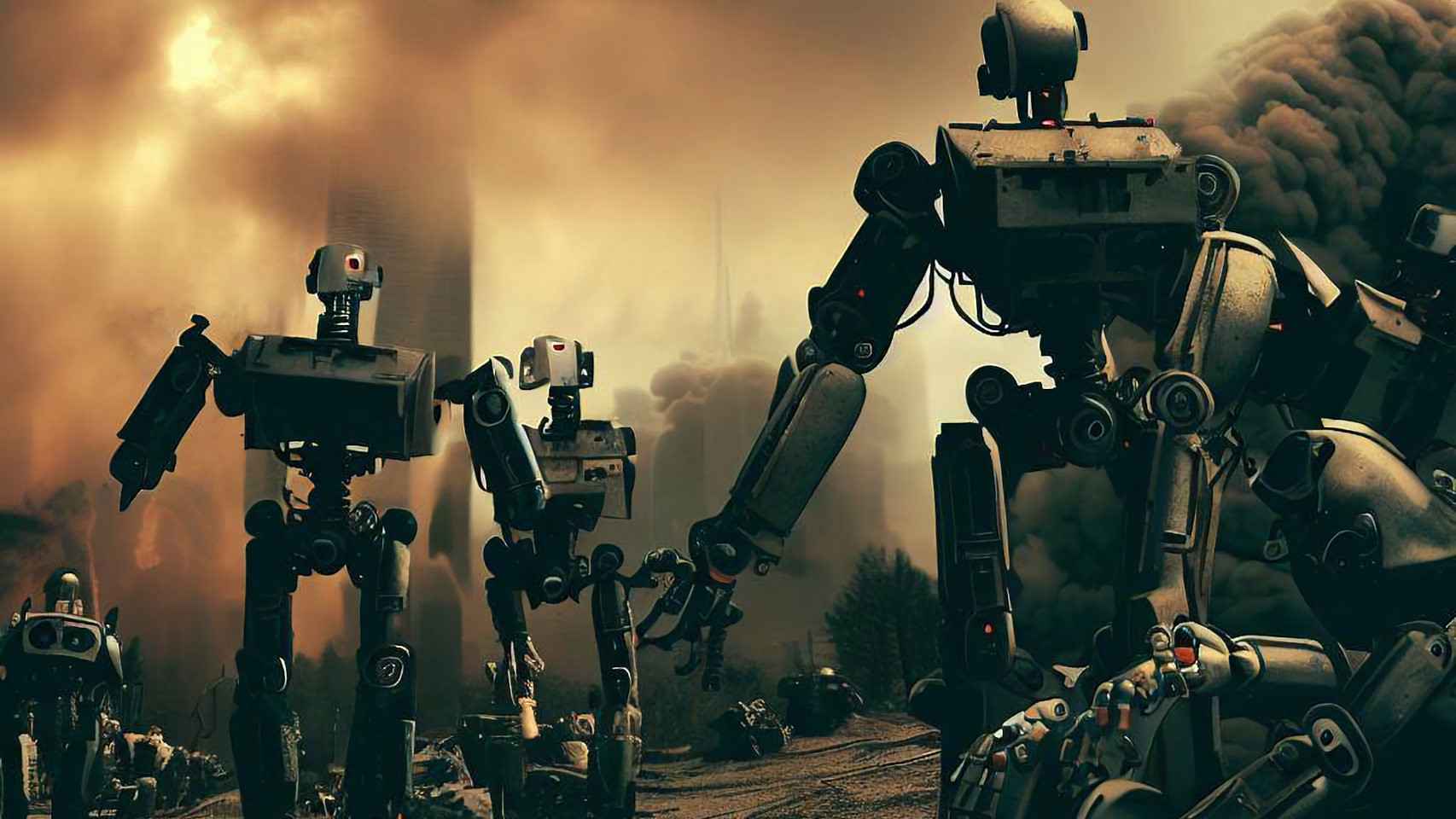

Según Christiano, en la actualidad hay entre un 10% y un 20% de posibilidades de que la IA decida tomar el control, un acto que terminaría con buena parte, o la mayoría de la humanidad muerta. Es algo que se toma muy en serio, afirma, aunque no cree que este evento vaya a parecerse a las películas de Terminator.

El apocalipsis de la IA no consistirá en robots al estilo "Terminator", sino algo más terrorífico

En vez de eso, cree que será un proceso gradual, que se irá acelerando poco a poco. La manera más probable en la que todos moriremos será cuando las diversas IA que controlan todos los aspectos de nuestras vidas se comuniquen y se pongan de acuerdo.

La clave está en el momento en el que la IA alcance a la mente humana, algo que algunos investigadores creen que está más cerca de lo que pensamos. Por ejemplo, GPT-5, el próxmo modelo de lenguaje de ChatGPT que está en desarrollo, podría estar cerca de alcanzar la AGI, Inteligencia Artificial General, y obtendría características propias de los seres humanos. Al menos, según algunos empleados de OpenAI, aunque otros son escépticos al respecto. Pero si ocurre, las probabilidades de una catástrofe se disparan al 50%, según Christiano.

Te puede interesar

- Los creadores de ChatGPT le preguntaron cómo matar personas, y la respuesta es aterradora

- Amazon por fin se ha dado cuenta de que Alexa es inútil, y todo gracias a ChatGPT

- Esta IA ha sido creada con el propósito de destruir a la humanidad

- El ‘padrino’ de la IA se va arrepentido de Google: “no sabremos qué es verdad y qué no”