La generación de imágenes por IA en el caso 'Almendralejo' iStock El Androide libre

La IA detrás del caso 'Almendralejo': así son las apps que pueden crear vídeos sexuales en segundos

Los avisos de varias familias de Almendralejo con montajes fotográficos con sus hijas adolescentes son solo una muestra del uso indebido de la IA.

18 septiembre, 2023 17:40Si la IA puede ser usada para generar imágenes bien creativas, como el nuevo generador Ideogram, también puede utilizarse malintencionadamente para perpetrar acciones de soborno como las vividas por las hijas adolescentes de varias familias de Almendralejo en España. El fácil acceso a estos generadores desde una misma app para el móvil permite que cualquiera pueda retocar una foto para convertirla casi en real.

El caso en Almendralejo es una simple muestra del uso indebido de una tecnología que ha irrumpido este año para lo bueno y lo malo; en lo malo por el momento de infierno por el que han pasado las 20 niñas. Y es que decenas de menores de Extremadura han denunciado que circulan fotos de falsos desnudos creados por inteligencia artificial. La policía ya está investigando los casos de varias familias que se encontraron de un día a otro con estas fotos circulando por WhatsApp. Entre las afectadas está la hija de Miriam Al Adib; la conocida ginecóloga reveló a través de un vídeo en redes sociales que su hija le había enseñado una de estas creaciones con Inteligencia Artificial.

El uso de la inteligencia artificial ha traído consigo todo tipo de noticias positivas relacionadas con ChatGPT y Bard, dedicados al uso del lenguaje, y su utilización para la generación de imágenes con Midjourney, Stable Diffusion y Adobe Firefly. El uso básico de estos generadores se limita a la introducción de ciertas palabras (denominado como 'prompt) para que la inteligencia artificial genere una imagen. Este es el uso más simple y básico actual, pero hay decenas de aplicaciones para móviles que usan este tipo de IA.

Imagen viral retocada por IA del Papa Francisco El Androide libre

El gran problema detrás de la generación de imágenes por IA es que se borra totalmente la línea que ha separado siempre lo que es una fotografía real de la que es irreal. Un ejemplo es la imagen viral sobre el Papa Francisco de hace unos meses y cabe recordar todos esos mágicos filtros que mismamente ofrece TikTok para así rejuvenecer el rostro o simplemente parezca que sea ya una persona entrada en edad. Es decir, que existe un variopinto repertorio de generadores y retocadores de imágenes con los que se pueden crear imágenes como las que han sido compartidas en el caso 'Almendralejo'.

De momento, se desconoce el programa usado para el retoque de esas fotografías, ya que está siendo investigado por la policía, aunque hay una pista que ha aparecido gracias a la marca de agua en una de las fotografías de las muchachas. Es el logotipo de una mosca e indica que se ha usado una app para retocarlas.

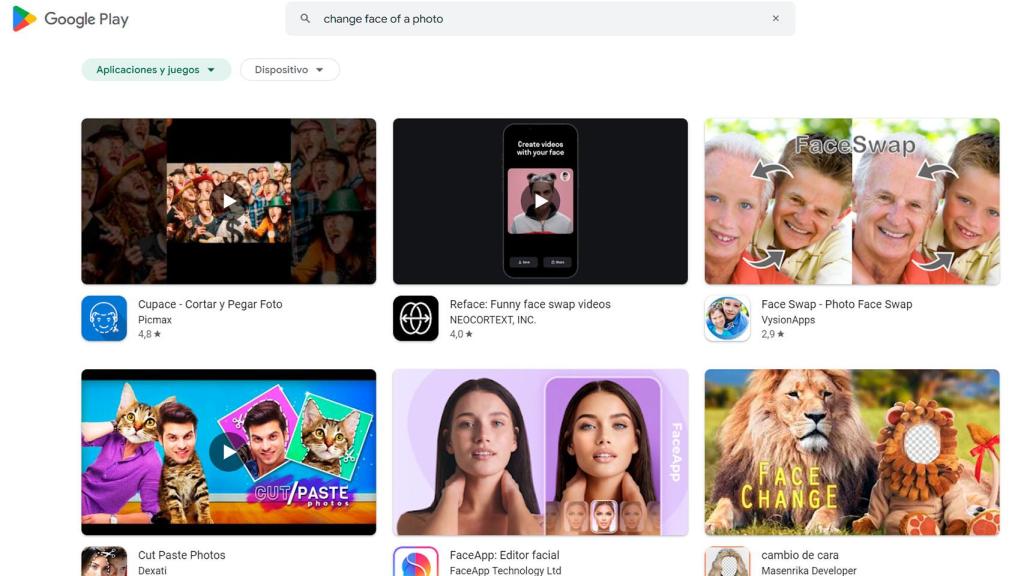

Apps de retoque en la Google Play Store El Androide libre

En las tiendas para móviles, tanto en la App Store de Apple como en la Play Store de Google, existe un buen repertorio de aplicaciones que se encargan de realizar este tipo de retoques. Hay algunas dedicadas a cambiar el rostro de cualquier foto, así que todo se reduce a unos simples clics o toques y ahí estará la imagen retocada. Lo mismo sucede con el vídeo.

Por lo que parece los perpetradores de esta acción habrían usado algo similar. Se sube la foto y la app se encarga de hacer el resto. Y conseguir las fotos de cualquier persona a través de las redes sociales es una tarea sencilla, así que el camino a realizar una acción es bien simple. Herramientas gratuitas en los móviles y el contenido personal en redes sociales, lo que agiliza que cualquiera pueda usarlas en combinación para lograr resultados impensables hace unos años.

El problema de estas apps para móviles es que no analizan las imágenes que se suben para retocarlas, lo que impediría que las que contienen desnudos se usasen. Estas apps no retocan la imagen desde el mismo móvil, sino que se sube la imagen seleccionada para que desde sus servidores se encarguen de generarla. El proceso se hace en la 'nube'. Una vez que esté lista la imagen, el proceso puede llevar desde los 15 segundos al minuto (según la carga que soporten), el usuario ya la puede descargar a su móvil. Con analizar las fotos que se suben a estas apps y así identificar desnudos, se bloquearía una vía sencilla, gratuita y disponible para todo el mundo.