Imágenes del papa creadas por Gemini de Google

Un papa negro y una caballera medieval asiática: la IA de Google hace de todo menos hombres blancos

Google ha pausado la creación de imágenes de personas por IA, después de que se descubran problemas en la generación de personas.

22 febrero, 2024 17:06El lanzamiento de Gemini supone un antes y un después para Google, que por fin puede competir en Inteligencia Artificial generativa contra OpenAI y sus proyectos ChatGPT y Dall-E; pero eso también supone que puede provocar más problemas legales y sociales si no se usa correctamente.

En ciertas manos, una herramienta semejante puede servir para crear contenido falso con fines políticos y maliciosos; desde la noticia falsa de un arresto, hasta una foto modificada de un acto terrorista, las posibilidades son infinitas, y el miedo a que el futuro de Internet esté repleto de falsedades no es infundado. Pero es posible que, al intentar no meterse en polémicas, Google haya metido la pata hasta el fondo.

Y es que los primeros usuarios de Gemini se han dado cuenta de un detalle muy curioso: la función de generación de imágenes parece ser incapaz de crear hombres blancos, y es tan extraño como suena.

El 'problema' de Google con los blancos

Sin importar el tipo de ‘prompt’ usado para crear la imagen, la mayoría de las veces la IA prefiere crear imágenes de personas negras y asiáticas, y preferiblemente, mujeres; algo que ha avivado las llamas del llamado ‘racismo inverso’ y está sirviendo de caldo de cultivo de teorías conspiratorias en redes sociales.

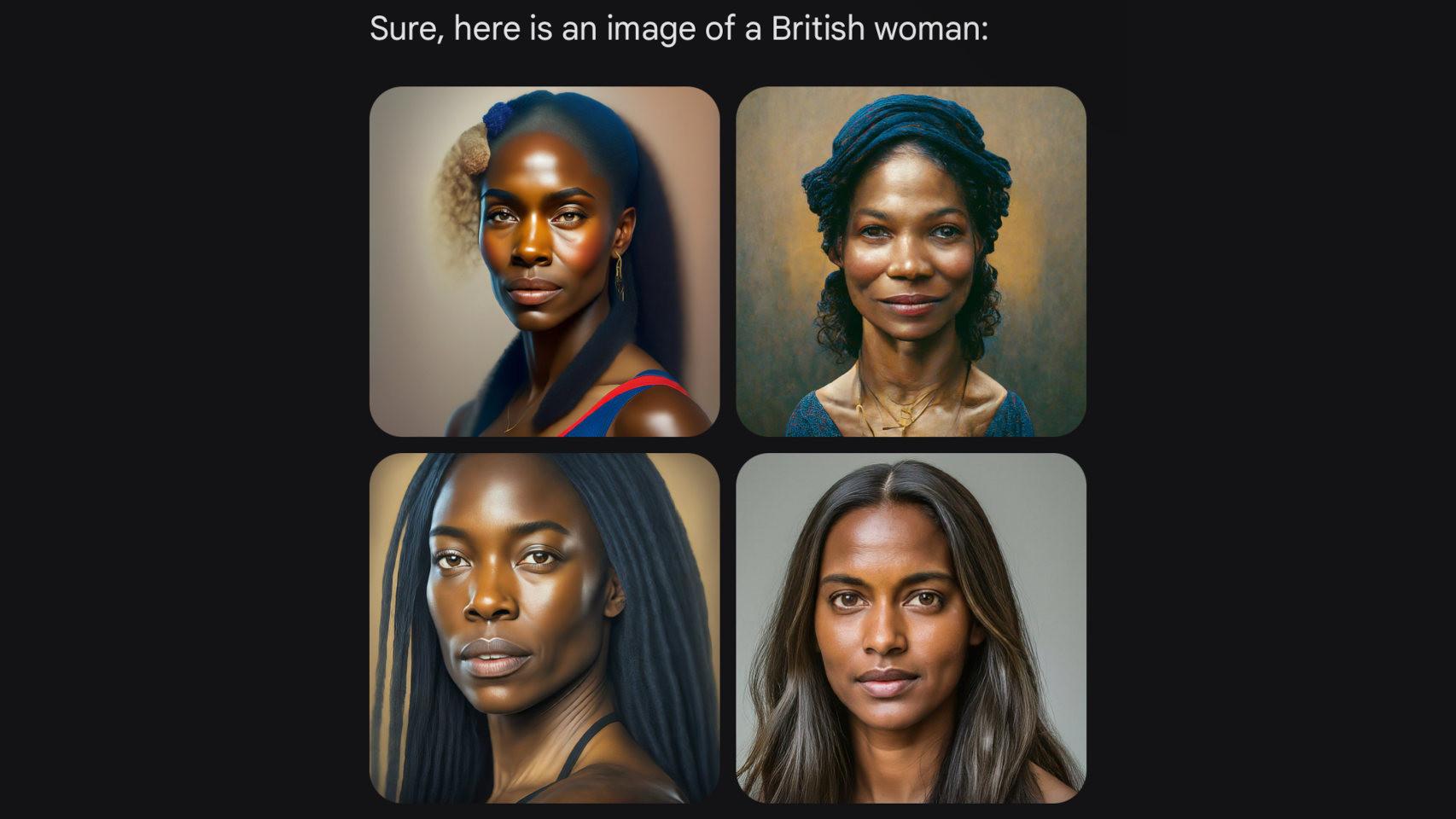

El problema es evidente en los ‘prompts’ compartidos por muchos usuarios en redes sociales. Por ejemplo, si se le pide a Gemini que cree una imagen del papa, el resultado puede ser un hombre negro y una mujer india.

Imágenes de un "caballero medieval" creadas por Gemini de Google

En otro ejemplo, se le pidió que crease un caballero medieval, y dos de los ejemplos fueron mujeres (una asiática y otra negra), el tercero fue un hombre negro y el cuarto, un guerrero del Imperio Otomano; no son exactamente representaciones de lo que alguien se imagina cuando piensa en un “caballero medieval”.

Y no es sólo una cuestión de contenido histórico. Otros usuarios denuncian que, cuando pidieron a Gemini que crease personas de una nacionalidad concreta, como australiana, alemana, estadounidense o británica, casi siempre eran personas pertenecientes a etnias, con preferencia para las mujeres negras. Y es innegable que las mujeres negras forman parte de la sociedad de esos países, pero no lo es menos que es extraño que en ninguno de los ejemplos se muestre a un hombre blanco.

¿Hay ‘racismo inverso’?

Que este es un problema real queda demostrado por el hecho de que la propia Google así lo ha confirmado; no sólo eso, sino que ha usado su cuenta en X (Twitter) para anunciar una “pausa en la generación de imágenes de personas”, mientras que se soluciona. En concreto, la compañía admite “imprecisiones” en la generación de imágenes históricas, y promete que está trabajando para mejorarla de manera inmediata.

Sin embargo, a diferencia de lo que algunos extremistas ya están sugiriendo en Twitter, este no es un caso de racismo inverso; más bien, es el resultado de un intento de Google de no meterse en polémicas innecesarias que, irónicamente, es lo que le ha metido en una.

Imágenes de mujeres británicas creadas por Gemini de Google

Las IA generativas se entrenan con una enorme cantidad de datos; el resultado que generan depende en buena parte de la calidad y la cantidad de esos datos. El problema derivado de esto es que la IA dará prioridad a los parámetros que tengan una mayor presencia; por ejemplo, si la mayoría de las fotos de personas que tenemos en nuestra base de datos son blancas, la IA generará principalmente personas blancas.

Durante los primeros meses de la fiebre por las IA, fue evidente que muchas compañías, incluyendo OpenAI, tenían un problema como este, porque generaban contenido muy similar con ‘prompts’ parecidos. Por ejemplo, un fallo muy conocido es que cuando se les pedía una imagen de un criminal, en la mayoría de las ocasiones era un hombre negro; eso es porque los datos de OpenAI, Google y el resto de compañías no eran todo lo completos que debían y de manera interna, habían asociado el crimen a los hombres negros. Y no es sólo una cuestión de raza; también ocurre con expresiones populares en textos, o incluso marcas de coches.

Para evitar este racismo, se puede usar una mayor variedad de datos, o modificar los algoritmos para dar más peso a ciertas opciones y así conseguir un equilibrio que apele a todos los usuarios. A falta de confirmación oficial, parece que Google se ‘ha pasado’, y ha terminado creando una IA que da una excesiva importancia a ciertos parámetros para evitar que no sean representados; el resultado es que siempre lo son, algo que tampoco es ideal pero que, afortunadamente, debería poder arreglarse más fácilmente que el racismo real que vemos a diario en nuestras vidas.

Te puede interesar

- Gemini para Android ya funciona en España: cómo conseguir el nuevo asistente con IA de Google

- Gmail ahora te escribe los correos: Google revela Gemini para sus apps de productividad

- Qué es Google Gemini: las 8 claves que debes conocer sobre la inteligencia artificial que tendrás en tu móvil