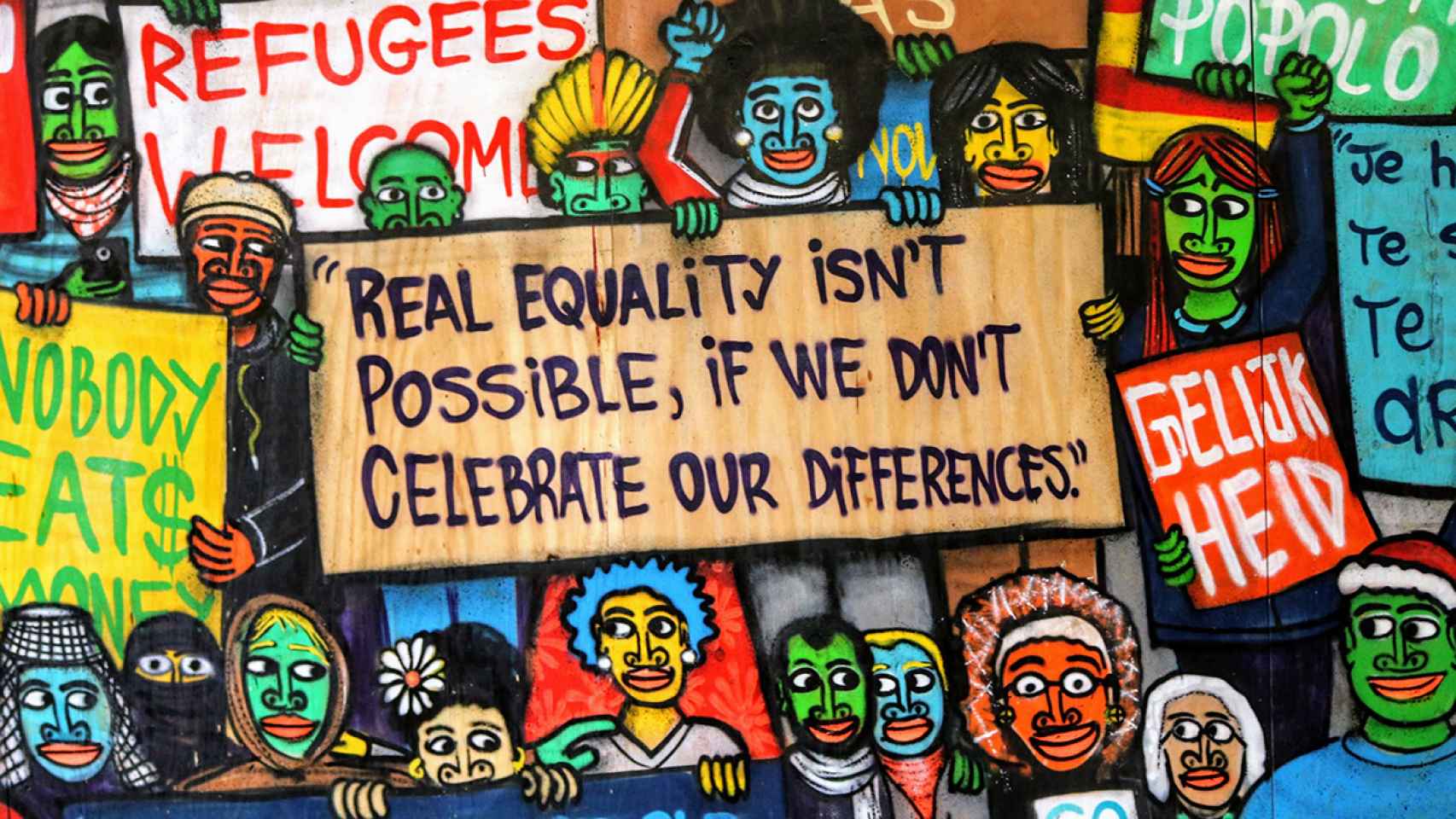

El informe 'Discriminating Systems' pone de manifiesto la discriminación en la IA.

Investigación

Sí, la inteligencia artificial es machista y racista... pero tiene 'cura'

Un informe de AI Now Institute demuestra que la IA discrimina por raza y género

3 mayo, 2019 07:00Algo está pasando con la inteligencia artificial (IA) y la discriminación. En los últimos meses, empleados de las grandes tecnológicas han alzado su voz contra los últimos desarrollos de sus empresas. En abril de 2019, un grupo de trabajadores de Microsoft se reunió con el CEO, Satya Nadella, para discutir asuntos como el acoso, los salarios desiguales o la poca promoción de las mujeres.

En Google, 20.000 personas de la plantilla se declararon en huelga el pasado mes de noviembre contra la cultura de “desigualdad y acoso sexual” dentro de la compañía, tras salir a la luz que el gigante de Mountain View había protegido y pagado a ejecutivos varones acusados de mala conducta.

“Esta únicamente es una cara del desastre de diversidad que ahora alcanza a todo el sector de la IA”, dice el informe Discriminating Systems, de tres investigadoras de AI Now Institute y la New York University. “Las estadísticas de diversidad de género y de raza son alarmantemente bajas”.

Y dan datos: solo el 15% de los investigadores de inteligencia artificial de Facebook son mujeres. La cifra cae al 10% en Google. “No es mucho mejor en la academia”. “Estudios recientes muestran que un 18% de los conferenciantes en IA son mujeres y que un 80% de los profesores son hombres”.

En cuestión de raza, los resultados son aún peores. En cuanto a la población afroamericana sólo representa el 2,5% de los empleados de Google y el 4% de Microsoft y Facebook

Las autoras del informe argumentan que la discriminación dentro de las plantillas de las tecnológicas afecta a la forma en que trabajan, los productos que construyen, los usuarios a los que se dirigen y los beneficiarios de sus desarrollos. En su trabajo, las investigadoras han estudiado durante un año la crisis de diversidad actual que atraviesa el avance de la inteligencia artificial y han obtenido conclusiones muy claras.

La primera es que el sector de la IA necesita un cambio “profundo” en la forma en la que aborda la crisis de diversidad actual. “La industria de la IA necesita reconocer la gravedad de este problema y admitir que los métodos existentes han fallado a la hora de tratar la desigual distribución del poder”, señala el documento. Aún más, muchos investigadores han demostrado que los sesgos de los sistemas de IA reflejan los patrones históricos de discriminación. “Estas son dos manifestaciones del mismo problema y deben abordarse juntas”.

El estudio también pone de manifiesto la “necesidad urgente” reevaluar el uso de la inteligencia artificial para la categorización, detección y predicción de raza y género. Señala que los sistemas de clasificación basados en la apariencia son “profundamente sospechosos”, incluyendo las herramientas de IA que dicen detectar la sexualidad a partir de la foto de un rostro, predecir la criminalidad basándose en gestos faciales o evaluar la capacidad del trabajador por sus microexpresiones. “Estos sistemas están replicando los patrones de sesgos raciales y de género de manera que pueden hacer más profunda y justificar la desigualdad histótica”.

Pero aún no tarde. Las autoras de Discriminating Systems recogen algunas de las claves para revertir esta situación. Recuerdan que remediar el sesgo discriminatorio de los algoritmos es imposible si estos son opacos. Por tanto, la transparencia es esencial y, a su juicio, empieza por hacer seguimiento y publicar dónde se usan los sistemas de IA y con qué propósito.

También defienden que estos desarrollos se vean sometidos a pruebas “rigurosas” a lo largo de su ciclo de vida. Las auditorías independientes antes y durante su aplicación son necesarias para evitar caer en la discriminación.

Sin olvidar que el campo de investigación del sesgo y la imparcialidad tiene que ir más allá de los aspectos técnicos e incluir un análisis social más amplio de cómo se usa la IA en contexto. “Esto require un rango mayor de expertos”.