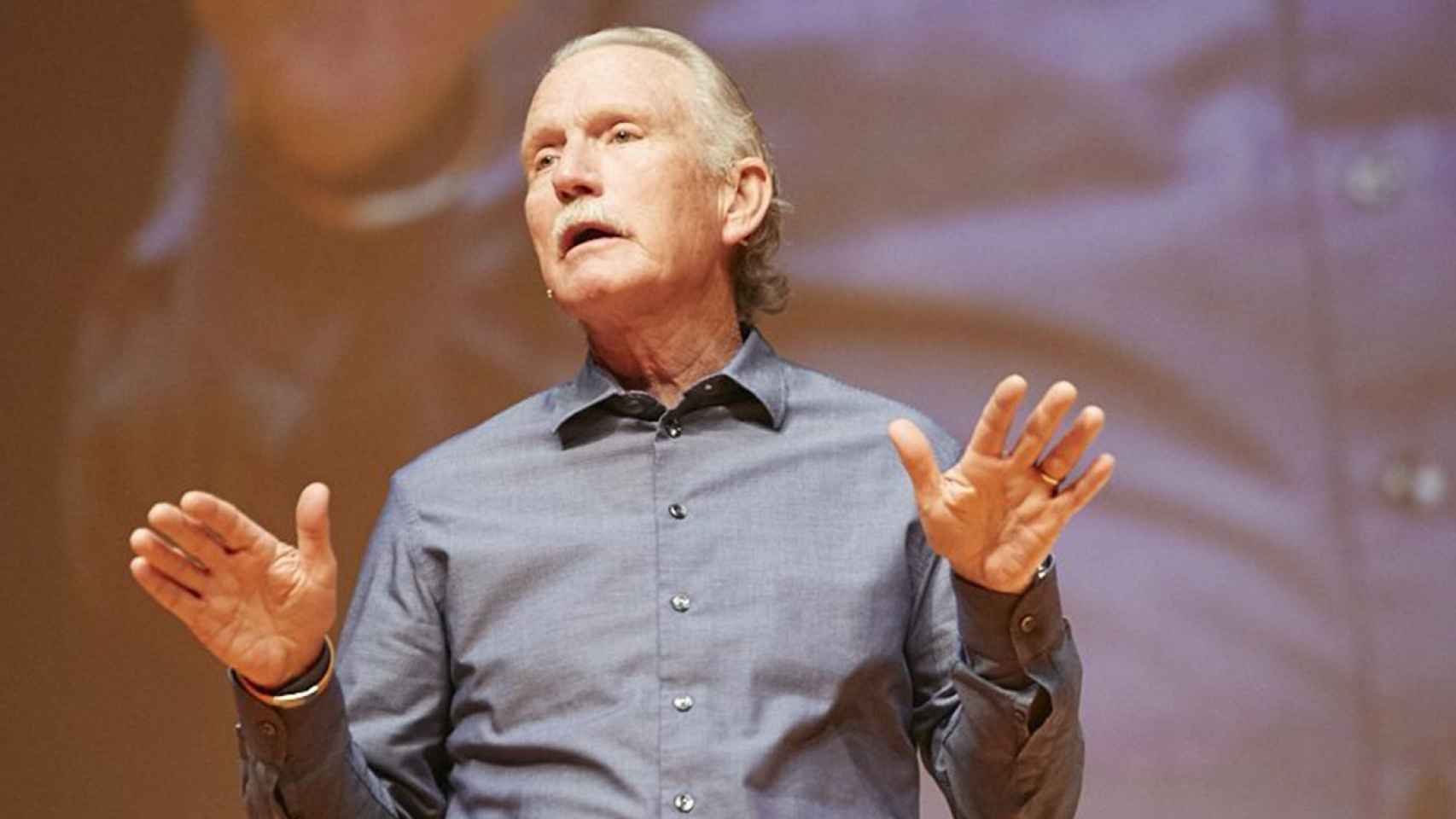

Victor Lund, presidente y consejero delegado de Teradata en el evento Teradata Universe 2018 en Londres.

Tecnológicas

La analítica de datos 4D se sube a la nube

La nube y los modelos al uso convivirán en la analítica de datos, según Teradata

29 abril, 2018 09:00La era del big data como comienzo y final de todo, como ese paradigma por defecto que todos debíamos vanagloriar, parece que ha pasado a mejor vida. De la obsesión por acumular el mayor volumen de información posible y los retos de almacenamiento que surgían alrededor de esta manía, ahora hemos pasado a un paradigma un poco más evolucionado, en el que lo que importa es el uso que hacemos de esos datos. Mejor dicho, el análisis que hacemos de ellos.

No en vano, la analítica de datos (o ciencia de datos, según la preferencia particular de cada cual) es uno de los temas de moda en la industria. Un reciente estudio de Forbes no hacía sino alentar a ello: aquellas empresas que utilizaron analítica avanzada aumentaron sus ingresos y sus márgenes operativos en un 15% o más. Las dudas no están tanto en la necesidad o no de abordar este reto, sino en las fórmulas óptimas para hacerlo.

En el marco del Teradata Universe 2018, celebrado esta semana en Londres, esta compañía de software analítico ha presentado una renovada apuesta por la nube como modelo de entrega complementario, que no por defecto, con sendos acuerdos con AWS y Azure para extender allí su plataforma de analítica. De Google Cloud y otros servicios, fuentes de la multinacional aseguran que habrá novedades en los próximos meses pero sin desvelar nombres concretos.

"El cloud que vemos todavía no es cloud: cada servicio de nube pública es completamente distinto, con diferentes posibilidades técnicas y latencias, etc. La clave para muchos de los clientes son los modelos híbridos que, además, les permitan probar en entornos de nube para luego volver a sus centros de datos si así lo estiman oportuno", explica Victor 'Vic' Lund, presidente y CEO de Teradata a INNOVADORES.

"La nube sin duda beneficia a las pequeñas empresas al poder acceder a recursos que antes no podían, pero no está muy claro que salga rentable a las grandes corporaciones si nos atenemos al presupuesto, sí en cuestión de agilidad y flexibilidad. Pero en cualquier caso, creo que al final se impondrán los despliegues en la nube conforme vayan solventándose las complicaciones que ahora presentan estos modelos de entrega y se vaya mejorando el coste por escalar grandes cargas analíticas en el cloud".

En la misma línea se pronuncia Oliver Ratzesberger, el número dos de la compañía y COO. Recién incorporado a este nuevo puesto en Teradata, este ejecutivo confiesa que «no creo que la nube sea el mejor modelo para las empresas que necesitan hacer analítica 24x7; en esos casos es más eficaz hacer un despliegue dentro de nuestro centro de datos. Pero eso seguramente evolucionará en los próximos 10 años y los servicios cloud se harán más eficientes de lo que son hoy en día. Lo relevante es que, aunque los CIO arriesguen en su decisión, no se queden atrapados en un despliegue o en otro».

Un informe de la propia compañía presentado en el mismo evento revela que el 83% de las organizaciones considera la nube como el mejor lugar para llevar a cabo analíticas de información avanzadas. Cuestionados los ejecutivos ante esta disonancia, su respuesta es la más políticamente correcta: ellos se limitan a ofrecer todas las alternativas disponibles para que sea cada cliente, con su casuística particular, el que escoja el modo de entrega que le ofrezca mayor rendimiento, menor coste y más agilidad.

Por otro lado, Teradata también ha profundizado en el concepto de analítica 4D, un concepto que -a medias entre el marketing y la tecnología- versa sobre la importancia de la geolocalización y el marco temporal para la gestión de los datos y la consiguiente extracción de valor de toda esa información.

A ello hemos de unir otras áreas de creciente interés para Teradata como son la inteligencia artificial ("inherente a la plataforma analítica por definición", explica Ratzesberger) o el gemelo digital ("vamos hacia una sociedad que cada vez más modelará sus capacidades, productos y clientes a través de los gemelos digitales. Y hay una gran cantidad de posibilidades que creo que podemos llevar a la mesa para hacer que sea más fácil, ya sea en el control virtual de un equipo digital y cómo está cambiando hasta la decisión de tomas de decisiones autónoma en base a las simulaciones hechas con este digital twin", añade el ejecutivo).

Consolidación de datos

Pero antes de llegar a cualquiera de estos retos analíticos, existe otro tema a solventar primero, justo el que dio vida a Teradata: el almacenamiento y la gestión de todos los datos de la empresa que conforma su particular big data corporativo. Un ámbito que, lejos de lo que pudiera pensarse, sigue planteando grandes retos, principalmente debido a la necesidad de consolidación de los silos de información que pueblan la infraestructura TIC de una empresa al uso.

"Todas las industrias pasan por ciclos de centralización, descentralización, vuelta a la consolidación y, de nuevo, se descentralizan. Ahora mismo, estamos asistiendo a un proceso de consolidación de toda la amalgama técnica que teníamos acumulada", comenta Ratzesberger. "Sirva como ejemplo que uno de los principales bancos de EEUU nos contó que, tan sólo en su departamento de riesgo y fraude, tenían 800 sistemas de información distintos. El departamento TIC de esta entidad tenía como reto ahorrar 1.000 millones de dólares en costes operativos en tres años y vieron que era completamente imposible hacerlo teniendo semejante cantidad de silos de datos".

Los datos parecen darle la razón a este directivo: un reciente estudio de Gartner analizó más de 14.000 empresas y detectó que, de media, cada una de ellas contaba con unas 700 bases de datos. "El precio a pagar por esta heterogeneidad es enorme: al coste de las licencias y el mantenimiento hay que sumar el de no poderse mover de manera ágil, ya que esta variedad de sistemas supone un ancla para el crecimiento de las empresas o la integración de nuevas tecnologías", sentencia Oliver.