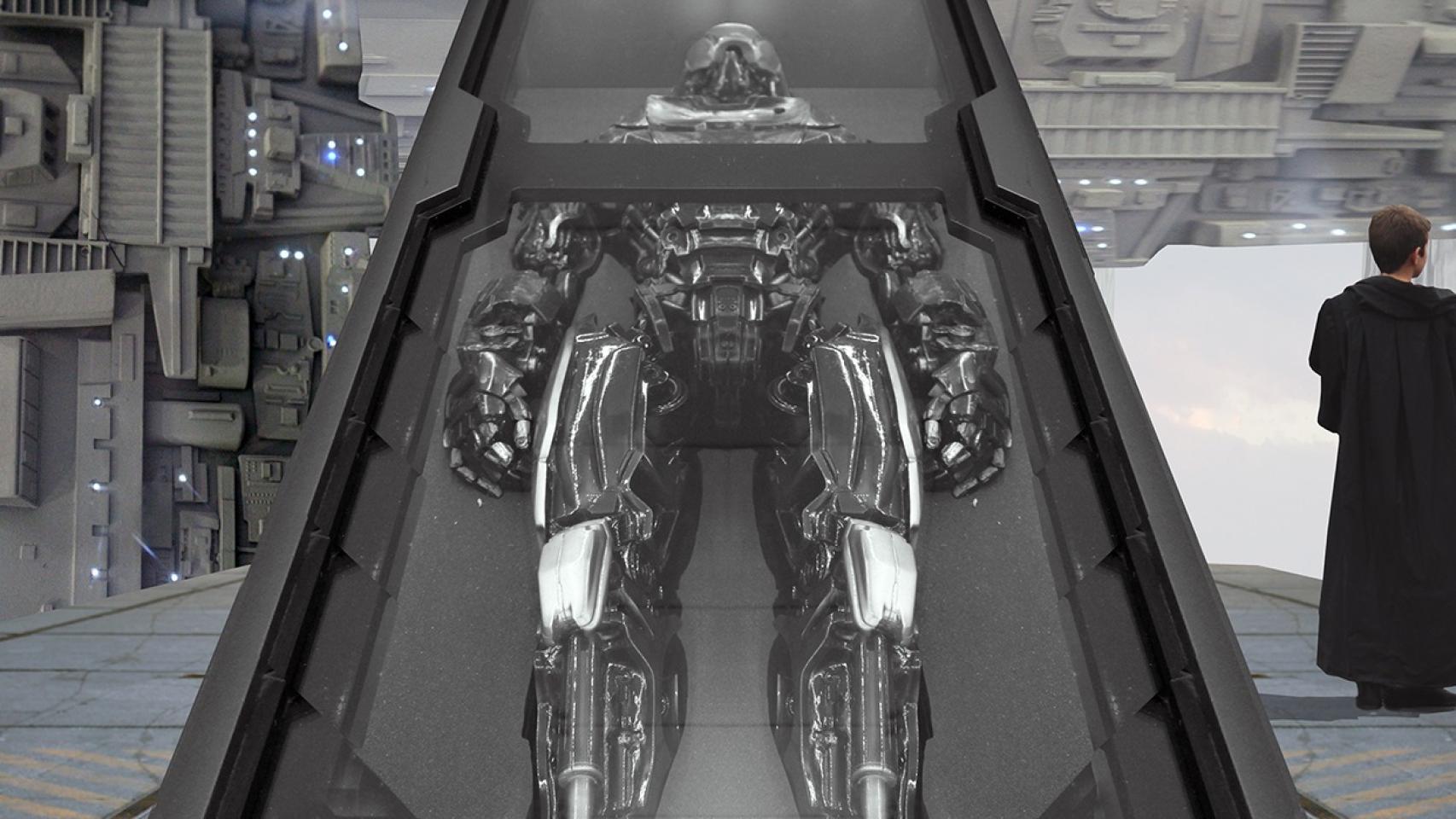

El concepto 'AI box' describe un hipotético sistema informático de hardware aislado en el cual una inteligencia artificial se mantiene restringida en una prisión virtual. Esta inteligencia artificial se considera potencialmente peligrosa y por ello no se la permite manipular eventos en el mundo externo.

El concepto plantea que, por muy bien que esté diseñada una prisión virtual, una inteligencia artificial lo suficientemente inteligente podrá ser capaz de persuadir o engañar a sus guardianes humanos para que la liberen. En caso contrario, la inteligencia artificial podría incluso hackear el sistema liberándose a sí misma sin intervención humana. Eliezer Yudkowsky ideó un experimento para intentar demostrar este efecto.