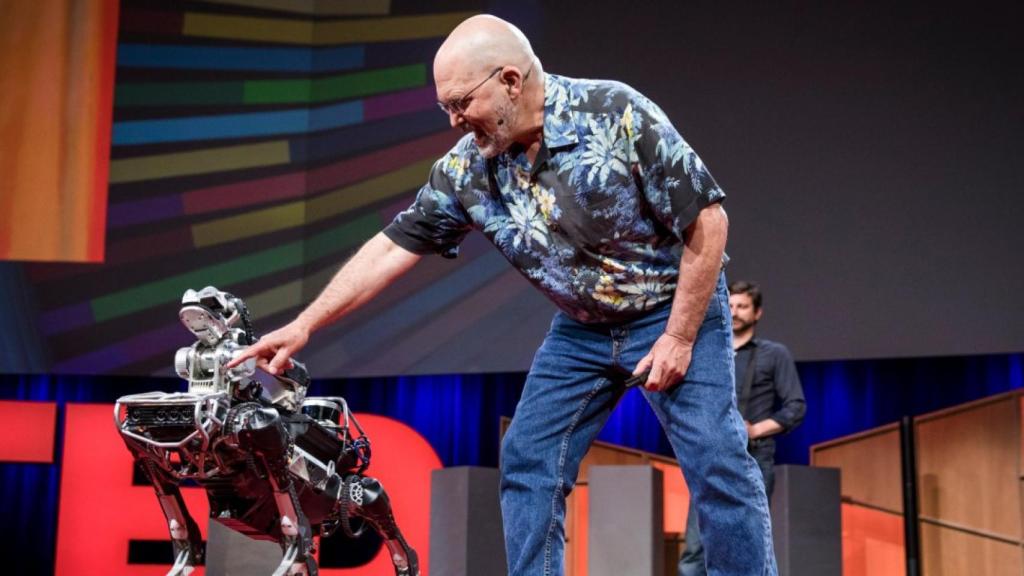

Marc Raibert, CEO de Boston Dynamics, con uno de sus robots, Spotmini.

Somos más duros al juzgar con nuestra visión moral a los robots

Un estudio de la Universidad de Brown persigue sentar las bases de una nueva moral para la relación personas-robots

18 octubre, 2018 11:00Los robots están asumiendo cada vez más roles en nuestra sociedad: desde asistente y compañeros hasta profesores. Todos estos robots participan en comunidades de personas, cuyo comportamiento está regulado por normas morales, que ya se están extendiendo a las relaciones, o más bien interacciones, entre personas y robots.

Por ello, el primer estudio sobre la valoración moral que aplicamos a las interacciones entre humanos y robots, elaborado por investigadores de la Universidad de Brown, resulta revelador: esperamos que las máquinas se sacrifiquen por el bien de la mayoría, mientras disculpamos a las personas, y consideramos más grave su culpa por inacción. Este estudio pretende abrir el debate para sentar las bases de una nueva moral que rija las interacciones entre personas y robots.

En estos experimentos, por primera vez, se han investigado las diferencias en los juicios morales de las personas sobre los propios humanos y los robots, cuando ambos se enfrentan a un dilema moral. “Encontramos diferencias tanto en las normas que las personas imponen a los robots (que esperan acción sobre la inacción), como en la culpa que las personas asignan a los robots (menos por actuar, y más por no actuar)”, aseguran en las conclusiones de este estudio.

Las normas morales desempeñan un papel esencial en las relaciones humanas y cada vez es más esencial trasladar y adaptar esta moral al mundo de la robótica, ante la creciente sofisticación de los mismo. Pero, antes deberíamos “entender” cómo las personas aplicamos nuestras normas morales a los robots.

Por ejemplo, uno de los experimentos realizados por este equipo de investigación comprobó que en el dilema moral de ‘sacrificar’ a una persona por el bien de muchos, se responsabilizaba mucho más a los robots que tomaban esta decisión o que incluso no actuaban, que a los humanos que se enfrentaban al mismo dilema.

¿Qué debo hacer? Orientación. ¿Qué se supone que va a suceder? Previsibilidad. ¿Quién va a hacer qué? Coordinación. Estos son los tres pilares que rigen las normas morales de las personas desde hace 12.000 años, pero la pregunta ahora es si estas deben aplicarse tal cual a los robots. Este fue el objetivo de este estudio, titulado ¿Un sacrificio por el bien de muchos? Las personas aplican diferentes normas morales a las personas y a los robots.

“Hoy en día, las normas sociales y morales gobiernan un número casi infinito de comportamientos culturales como comer, hablar, vestirse, moverse, limpiar y saludar, todo varía según el rol, el propósito y el contexto. Sin moralidad, la sociedad no podría existir”, aseguran en su estudio los investigadores.

Por ello, se establece que la moral es una característica importante que debe existir en las interacciones entre personas y robots. Es lo que los investigadores llaman Moral HRI (por las siglas de Human-Robot Interaction), que proporciona una serie de preguntas que hay que plantearse y responder de cara al desarrollo futuro de la robótica: ¿Qué capacidades convertirían a un robot en un blanco natural de los juicios morales humanos? ¿Cómo actuarían las personas ante tales juicios morales? ¿Y qué sistemas de normas se impondrían al robot, qué obligaciones, permisos y derechos?

“Al sugerir que las personas aplican diferentes normas morales a los robots y los humanos, este estudio sienta las bases para una investigación sistemática de la interacción moral humano-robot, para un nuevo campo de moral HRI”, apuntan en las conclusiones de este estudio, al tiempo que inciden en que ahora se tiene que abordar una tarea conjunta entre la moral HRI y la psicología moral con el objetivo de “identificar las causas subyacentes de estas diferencias” para comprobar si dependen de las características propias de los robots o de la relación humano-robot. Esto marcará el futuro del desarrollo de la robótica.