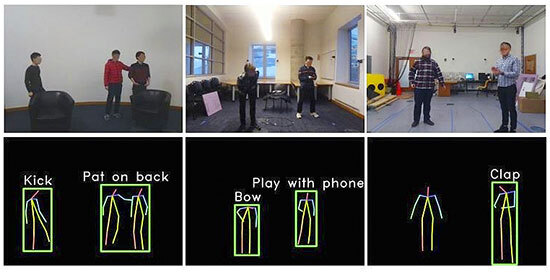

Imagen del proyecto Wireless smart-home system del MIT.

La visión artificial ya puede ‘ver’ en la oscuridad

Hay noticias que parecen consecuencia de esa frase premonitoria de ese gigante que fue Arthur C. Clarke, a quien tanto me gusta citar por sus sabios, bellos y afilados pensamientos: “Cualquier tecnología lo suficientemente avanzada es indistinguible de la magia”. Algunas de las aplicaciones de la inteligencia artificial recientes ilustran perfectamente las ideas de esa frase. Un campo de ellas es el de la visión artificial, un campo bastante discreto, pero que siguió trabajando incansable, incluso en el periodo del ‘invierno de la inteligencia artificial’ que duró casi dos décadas, sin desanimarse ante los inmensos retos a los que se enfrentaba.

Hoy en esta nueva explosión de la IA, que lo está cambiando casi todo, se le pide a esa disciplina que redoble sus esfuerzos y, además, se le exigen resultados y cuanto antes, con mucha urgencia. Por ejemplo, el coche autónomo y los robots, que van a mezclarse con los humanos por todas partes, necesitan de modo imprescindible una poderosa visión artificial.

Casi todo lo poco que sé sobre el campo de la visión artificial lo he ido aprendiendo del gran científico español del MIT CSAIL Antonio Torralba, que hoy dirige, tanto la gigantesca iniciativa de la ‘Búsqueda de Inteligencia del MIT’ (MIT Quest for Intelligence), como el ambicioso laboratorio MIT-IBM Watson AI Lab que ambas entidades poseen conjuntamente. Fue el profesor Torralba el que me explicó en el diálogo que tuvimos para mi libro con MIT Press sobre la decisiva importancia de la visión artificial para el avance de la robótica, para que se despliegue también en el mundo real y no solo en el interior de las fábricas, sino a lo largo y ancho de todo el mundo real que es donde vamos a necesitar su ayuda.

Imagen del proyecto Wireless smart-home system del MIT. Foto: MIT CSAIL

La inteligencia artificial no padece de antropocentrismo

Los humanos tendemos a pensar que cualquier artefacto artificial funciona con un esquema similar en algo a la condición humana. Es lógico. Esa es nuestra zona de confort intelectual y estamos más cómodos dentro de ella. Si pensamos en un robot, lo más fácil para imaginarlo es que pensemos en una máquina con aspecto exterior, movimientos y dimensiones como un humanoide metálico. Así han pensado los guionistas de la ciencia ficción desde hace más de un siglo (cuyas creaciones se remiten a la citada zona de confort intelectual donde el cine y la literatura suponen que también van a estar más cómodos los espectadores y lectores, y desde donde tendrán se supone mayor comprensión incluso hacia lo desconocido).

En cambio, la realidad del avance de la inteligencia artificial nos muestra que esta disciplina no comparte ese antropocentrismo tan visible en el cine o las novelas, por ejemplo, (salvo algunos de los tipos de visión japonesa de la robótica como la del Hiroshi Ishiguro lab con su geminoids. Pero en general ni los robots de los almacenes de Amazon tiene un aspecto y funcionamiento humanoide, ni como dice el Argumento de la Habitación China, la computación funciona como el cerebro humano. Los miles de robots de soldadura de las fábricas de automóviles no se parecen nada a un artefacto o robot ‘humanoide’, por más que en películas como Yo Robot o Steven Spielberg en Inteligencia Artificial se insista en que los robos deben tener un exterior que recuerda al de los humanos. Pero aseguro al lector que el aspecto de la inteligencia artificial que tiene, por ejemplo, el increíblemente poderoso HF Trading (Negociación de Alta Frecuencia ) -que por cierto según Ramón López de Mántaras, director del IIIIA del CSIC, debería estar prohibido en las Bolsas-, no tiene en absoluto aspecto ‘humanoide’. Aunque, curioso, el propio López de Mántaras para hablar de ello ilustró su presentación en la pantalla con un robot humanoide.

Pero no, el software de la HF Trading, capaz de realizar 2.000 operaciones por segundo de compra y venta de acciones en la Bolsa, tiene el aspecto de un software puro y duro, como tal se visualiza en la pantalla. Se ve como enormes columnas verticales de texto con código alfanumérico, e igual pasa con Siri la asistente virtual de nuestro iPhone, que así se ve al abrir su ‘interior’, por más que le pongan en los anuncios, la voz adecuada para que nos la imaginemos con el cuerpo de la divina Scarlett Johansson. Pero no, no tiene curvas. Solo miles y miles de líneas de código alfanumérico bajando de arriba a abajo. Eso sí, con bonitos y vivos colores en sus caracteres.

Cuando Antonio Torralba me dijo: “Necesitamos que los robots vean y comprendan el mundo”, reconozco que pensé enseguida que ‘verán y comprenderán’ el mundo como lo hacemos nosotros, los hombres y mujeres. Craso error. La visión artificial de las máquinas no funciona como la nuestra. Ni siquiera cuando decimos ‘máquinas’, al hablar de machine learning (que traducimos aprendizaje de máquinas); o del deep learning (aprendizaje profundo) de la inteligencia artificial, debemos pensar en ‘máquinas metálicas’ con engranajes etc., porque estaremos pensando en algo que no es así en la realidad.

Estamos hablando de algoritmos muy complejos, que al final son inmateriales y que solo podremos ver, de nuevo, en la pantalla en forma de multitud inmensa de columnas y enormes ‘párrafos’ de líneas de código. Así que debemos aplicar al imaginar ese mismo marco de pensamiento cuando hablamos sobre cómo ‘ven’ las máquinas impulsadas por la inteligencia artificial y tener claro que son puro código inmaterial y alfanumérico. Esas máquinas no ven como los humanos, lo cual no tiene porque ser negativo. Al contrario, porque, en realidad, ‘ven’ mucho más que los humanos. En términos técnicos se podría decir que tienen una visión mucho más aumentada que la visión humana, ya que usan un espectro de visión mucho más grande que el humano visible y ahora se combina con frecuencias de radio, machine learning e inteligencia artificial.

Un ejemplo de eso, como se acaban de mostrar en su último paso, es el de una nueva tecnología desarrollada en el MIT. Gracias a ella, la inteligencia artificial es capaz de ‘ver’, no solo en la oscuridad, sino también a través de las paredes sólidas. ¿Cómo es eso posible?... pues es posible, tal como describen su invención en un paper que se llama Haciendo visible lo invisible: Reconocimiento de acciones a través de paredes y obstáculos, un proyecto de un equipo liderado por la profesora Dina Katabi -por cierto del mismo MIT CSAIL, el centro de investigación del MIT de Antonio Torralba-. Describe que su sistema Wireless smart-home system ‘ve’ de una forma claramente no humanoide (otro significado a revisar: el del verbo ver).

Así, han seguido avanzando e innovando en ello y el investigador del CSAIL, Tianhong Li de ese equipo, relataba hace pocos días a la prestigiosa MIT Tech Review, cómo han conseguido que sus algoritmos de inteligencia artificial consigan ‘ver’ en la oscuridad, de la siguiente manera: “Introducimos, para un modelo de red neuronal que puede detectar las acciones humanas a través de paredes y obstáculos, y en condiciones de iluminación deficientes o sin ella”. Resulta que estos investigadores han conseguido encontrar la manera de ‘enseñar’ a un sistema de visión por radio a reconocer las acciones de la gente entrenándolo con imágenes de luz visible.

Y explica: “Nuestro modelo (de software de visión artificial) puede aprender de los conjuntos de datos basados tanto en la visión (normal), como en radiofrecuencia, y permitir que las dos tareas se ayuden mutuamente”.

De esta manera, su sistema aprende a reconocer las acciones bajo la luz visible (a la visión humana) y luego a reconocer las mismas acciones que tienen lugar, en la oscuridad o detrás de las paredes, utilizando ondas de radio. “Demostramos -explica- que nuestro modelo logra una precisión comparable a la de los sistemas de reconocimiento de acciones basados en la visión en escenarios visibles, pero sigue funcionando con precisión en ellos cuando para las personas no son visibles”.

Nada que ver si lo comparamos sobre cómo aprendemos a ver los humanos. Y es que el sistema ve como las cámaras que funcionan de forma equivalente a la vista humana, pero, además, ‘ve’ usando ondas de radio y frecuencias no visibles a la vista y al cerebro humano que interpreta las señales que le lleguen de nuestros ojos.

Así que la inteligencia artificial no ‘ve’ como los humanos y por eso consigue lo que nosotros no podemos hacer. Por ejemplo: ver en la oscuridad. Y eso no se puede explicar en términos de condición humana. Nosotros y la vida humana o animal no podríamos vivir en un planeta sin luz. Pero, tal vez, la inteligencia artificial sí. Y espero, con esta afirmación, no haber caído yo mismo, de nuevo, en el antropocentrismo.