Algoritmos que discriminan en procesos de contratación laboral, que recortan recursos a los más vulnerables o les aumentan las primas de los seguros, que impiden de forma injusta el acceso a una hipoteca o que excluyen a estudiantes pobres. Los sistemas automatizados sesgados campan por doquier, a menudo sin ser detectados hasta que alguien descubre el pastel.

Los sesgos algorítmicos presentes en tecnologías de inteligencia artificial y en otros sistemas informáticos menos ‘inteligentes’ son uno de los principales quebraderos de cabeza para las empresas que los desarrollan y para las organizaciones que los emplean. Han conducido a un continuo debate sobre cómo diseñar e implementar tecnologías éticas y al florecimiento de guías y códigos éticos por doquier.

Pero una cosa es la teoría y otra la práctica, y la realidad muestra que aterrizar dichos principios no resulta fácil. Con frecuencia, acaban guardados en un cajón o colgados en una pared como cuadro de desiderátums.

Los ejercicios de lavado de cara ético son obvios entre los gigantes tecnológicos como Google o Facebook, que mientras crean comités para (supuestamente) garantizar la ética de sus algoritmos siguen violando, en la práctica, sus propios principios.

Son algunos de los dilemas de la tecnología ética: si Google velase por la privacidad de los usuarios tendría que renunciar a su modelo de anuncios hiperpersonalizados; si a Facebook le preocupase el bienestar de las personas tendría que dinamitar su sistema de ingresos publicitarios basado en maximizar el tiempo que estas pasan en su plataforma.

El bienestar de los usuarios, clientes y demás públicos de interés no está entre los principales objetivos de estas compañías. “Son empresas de vigilancia con un modelo de negocio basado en la publicidad. Su objetivo es aumentar su valor en bolsa y a eso responden su comportamiento y sus métricas”, afirma Nathan Kinch, fundador de Greater than X, empresa australiana de ética y privacidad por diseño.

De la teoría a la práctica: primeros pasos

El primer y más básico paso para desarrollar productos y servicios éticos es, por tanto, alinear las metas e incentivos corporativos con los de los usuarios. “Las empresas más valientes y con un análisis moral más robusto se darán cuenta de que probablemente tengan que cambiar su modelo de negocio, su proceso de toma de decisiones, su estructura de gobernanza o renunciar a su presencia en bolsa”, dice Kinch. “Van a tener que tomar decisiones realmente difíciles si quieren realmente ser éticas”, añade.

La experiencia de Kinch asegura que esto está lejos de suceder y que hay muy contadas organizaciones haciendo algo que solo se acerca a un buen trabajo. De entre los gigantes tecnológicos, pone como ejemplo a Microsoft. El gigante de Seattle tiene iniciativas muy prometedoras para dar a la gente más control sobre sus datos pero tan solo representan una mínima parte de su negocio. La ecuación neta ética sale en números rojos. “Cuando tus unidades de acción perjudicial exceden tus unidades de acción apropiada tienes aún un largo camino de cambio”, apunta Kinch.

'Canvas' de Greater Than X.

Un buen comienzo para el cambio podría ser añadir métricas de bienestar. Estas medidas deben tomarse desde arriba, en lo más alto de la empresa. Es una cuestión de gobernanza.

Paralelamente, Kinch cree que estas empresas deberían invertir en un proyecto dedicado al completo a tomarse la ética en serio: analizar críticamente los procesos de trabajo y los obstáculos para la implementación de los principios éticos en la práctica.

“Entendiendo mejor cómo funcionan los flujos de trabajo diarios puedes encontrar puntos de intersección y control donde añadir las tomas de decisiones éticas”, propone el fundador de Greater than X. “Ir haciendo pequeñas cosas, pero siempre con una visión y estrategia de hacia dónde se quiere ir para determinar si estás progresando”, añade.

Dificultades conceptuales

Incluso para empresas cuyos objetivos y modelo de negocio están alineados con los de la sociedad, lograr un balance ético en el diseño, desarrollo e implementación de sus productos y servicios es una tarea compleja y no exenta de contrapartidas.

Koa Health es una startup que desarrolla terapias digitales y de bienestar con foco en hacer la salud mental accesible, personalizada y eficaz. Quieren hacerlo de forma ética, preservando la privacidad de los usuarios y evitando posibles sesgos en sus algoritmos y en el diseño de sus aplicaciones.

En el camino han identificado tres tipos de problemas: conceptuales, organizacionales y de estándares.

“Desde la perspectiva conceptual, tus principios pueden chocar entre sí”, comenta Oliver Smith, director de Estrategia y responsable de Ética en Koa. Por ejemplo, el objetivo de intentar proteger la privacidad puede colisionar con el de evitar sesgos, ya que para entender si una aplicación está sesgada es necesario saber el género, etnia y algunos otros datos personales de los usuarios.

¿Qué hacer entonces? “No hay una respuesta generalizada, cada organización debe encontrar la suya, pero siempre hay estas fuentes de tensión”, dice Smith.

El directivo explica que con una de sus aplicaciones -Foundations- han decidido que es más importante la privacidad y que pueden abordar el sesgo mediante investigaciones indirectas o más específicas.

Por ejemplo, en lugar de recopilar datos personales de todos los usuarios, creen que podría ser útil conducir investigaciones con un subgrupo representativo de usuarios del cual sí obtengan datos personales que puedan extrapolar para saber si su app está sesgada de alguna forma.

App 'Foundations', de KoaHealth.

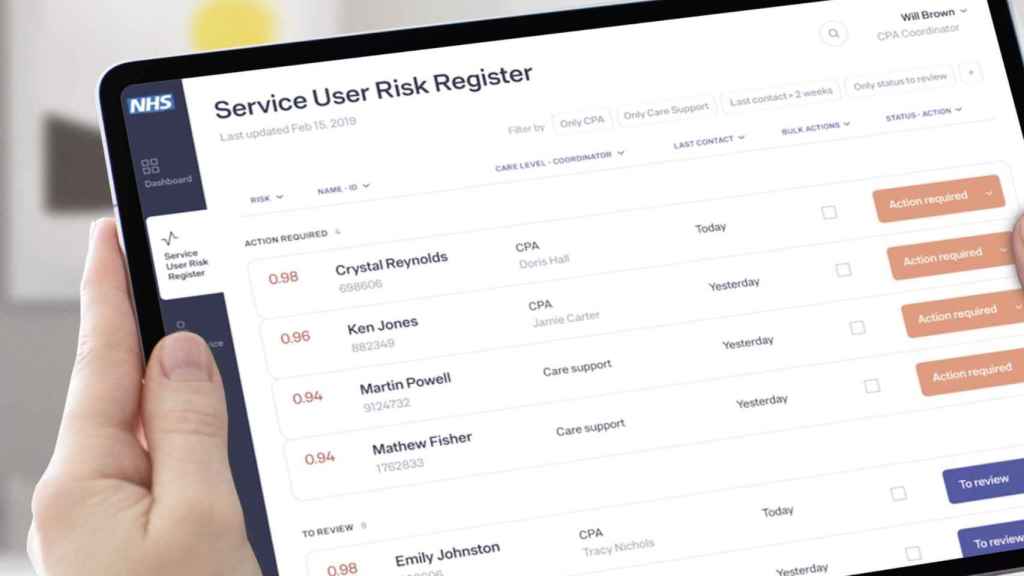

Sin embargo, con productos de diagnóstico o tratamiento no está tan claro. Por su trabajo con el Sistema de Salud británico (el NHS), Smith cree que en herramientas para predecir crisis de salud mental necesitarán recopilar datos personales para que el sistema funcione de forma adecuada. Por todo ello trabajan con Eticas Research & Consulting, con la que exploran posibles formas de usar datos personales sin que la Koa tenga acceso a ellos.

Otra de las colisiones conceptuales frecuentes en el uso de algoritmos es la de la potencia y la precisión versus la explicabilidad. En Koa trabajaban con algunos algoritmos avanzados de inteligencia artificial que en la práctica eran cajas negras: no se podía saber cómo habían obtenido cada resultado.

Para el NHS esto no era aceptable: conocer el proceso de toma de decisiones del algoritmo era clave para la aceptación de los profesionales sanitarios y, por tanto, para el uso de su aplicación. “Queríamos un algoritmo lo más preciso posible pero también explicable y confiable”, dice Smith. Al final decidieron excluir algunos métodos de desarrollo más opacos pero consiguieron desarrollar un algoritmo igualmente eficaz, a la vez que comprensible.

Dificultades organizativas

A nivel organizacional, Smith sostiene que introducir un proceso ético separado de todo lo demás se volverá un ejercicio de 'marcar casillas' que no será muy efectivo. “Hay que integrarlo en los procesos existentes del negocio. Los empleados apoyan nuestra posición ética, pero cada cual en su día a día está ocupado tratando de hacer su trabajo”, dice.

El reto es saber cómo incorporar las consideraciones éticas de forma proporcional, de modo que el personal no sienta que es algo que va a dificultar su trabajo y que no va a ayudar a mejorar el producto para el usuario final.

Por ejemplo, cuando tienen una idea para un producto recurren a una agencia para realizar un testeo previo con un número muy reducido de personas (de forma que es la agencia, y no Koa, quien recopila sus datos). El problema es que ese grupo reducido no es representativo de cada tipo de identidad, lo cual sería necesario para evitar sesgos a la de hora representar una idea o característica y que no sea percibido, por ejemplo, como algo destinado a mujeres o a hombres o a un tipo de persona específico.

Este sesgo no solo puede estar en el algoritmo sino en el lenguaje, las imágenes, iconos y en todos los elementos visuales de la app. Para evitarlo se necesita investigar con grupos representativos más amplios pero para ser ágiles hay que empezar con grupos reducidos. “El reto es moverse de forma iterativa: en lugar de tener una sola fase donde marcas ciertas casillas y te olvidas, hay que integrarlo en cada fase”.

'Foresight', algoritmo para predecir crisis de salud mental de Koa Health.

El equipo de diseño en Koa tiene una caja de herramientas que debe usar siempre al crear contenido, hacer pruebas con usuarios y demás pasos, de forma que a lo largo de todo el proceso del diseño siempre tengan en mente cómo evitar posibles sesgos. Para este trabajo cuentan con la ayuda de empresas como Greater than X.

La tarea trasciende, sin embargo, al equipo de diseño. Esa visión debe estar presente de forma consistente en cada parte del negocio. “Esto es lo difícil y lo que hace imposible aplicar la ética de forma instantánea. Necesitas pasar tiempo con cada equipo para hacerlo de manera apropiada, y eso es otro reto porque los recursos (dinero, tiempo) son finitos. Debes priorizar y trabajar con diferentes equipos en momentos diferentes”, explica Smith.

Falta de referencias

El tercer tipo de problema en el abordaje ético es la ausencia de estándares y buenas prácticas. Saber qué es bueno es difícil porque no hay muchas evidencias ni ejemplos de buenas prácticas para el desarrollo de algoritmos éticos.

“Hay algunas herramientas que ayudan en cosas específicas como plantillas para evaluar la aplicabilidad de tus algoritmos o para ayudarte a pensar sobre cómo mejorar la comprensibilidad de tus términos y condiciones”, comenta Smith.

Aquí el problema es que no se sabe hasta qué punto son útiles o si va a funcionar o no, lo que obliga a una evaluación constante. “Por otra parte tampoco hay regulación sobre equidad algorítmica o explicabilidad, no hay unos estándares ni nada hacia donde podamos apuntar como diana. Tenemos un objetivo cambiante de lo que es bueno y tratamos de usar las herramientas a nuestra disposición para alcanzarlo”, señala el experto.

Smith espera que su trabajo y el de otras empresas y organizaciones en el campo ayude a crear esas buenas prácticas y guías. Para evitar que sea el sector privado quien lo defina de forma unidireccional, los gobiernos y el tercer sector deben estar también implicados y asegurar la rendición de cuentas mutua.

Considera también que uno de los compromisos que las compañías deberían adquirir es el de tener que publicar su trabajo, así como sus evaluaciones o auditorías. “Permitir que otros lo vean, que te reten y evalúen y proporcionen comentarios sobre cómo mejorar, de forma que todos podamos avanzar juntos”, señala. En su caso, ya han hecho públicos tanto sus principios y compromisos éticos como su primera auditoría.

Cómo auditar algoritmos

El campo de la auditoría ética algorítmica es un terreno casi inexplorado. Entre las firmas pioneras está la española Eticas Research Consulting, liderada por Gemma Galdon. Su trabajo consiste en investigar los sistemas automatizados de toma de decisiones para asegurarse de que funcionan como deben en el aspecto ético: que no tienen potencial de afectar negativamente a las personas o a la sociedad, que carecen de potenciales sesgos o que no son discriminatorios, entre otras cosas.

Estas auditorías son en sí una forma necesaria de hacer que la inteligencia artificial sea "más explicable, más transparente, más predecible y más controlable por la ciudadanía, las instituciones públicas y las empresas", dice Galdon. “Contribuyen también a mejorar los mecanismos de atribución de responsabilidad y de rendición de cuentas de los sistemas algorítmicos”, añade. Su trabajo se concreta en la 'Guía de Auditoría Algorítmica' publicada este mes.

El propósito de Eticas con la publicación de esta guía es clarificar el vínculo entre la realización de auditorías algorítmicas y la salvaguarda de los derechos fundamentales a la privacidad y a la protección de datos personales.

También busca aportar claridad “respecto al necesario marco normativo para los sistemas algorítmicos para la correcta interpretación y aplicación del Reglamento General de Protección de Datos (RGPD), y para su ampliación en los casos necesarios”.

Otro de sus fines es ofrecer directrices y orientaciones metodológicas para la realización de auditorías algorítmicas. Unas auditorías que permitan “examinar estas tecnologías para un diseño, desarrollo y uso aceptable desde el punto de vista jurídico, previsible, proporcional, deseable, sostenible y socialmente justo y responsable”.

El objetivo no parece sencillo de cumplir. En su trabajo con empresas y organizaciones de todo tipo, Galdon aprecia retos muy parecidos: poca familiaridad con las necesidades que Eticas pone sobre la mesa y muy poca conciencia del deber de abordarlas. “Es necesaria mucha formación y concienciación desde el principio. Es en la fase de producción del algoritmo cuando se pueden abordar estas cosas y no después”, explica la experta.

El equilibrio máquina-humano

Parte de la formación consiste en hacer ver a quienes desarrollan y a quienes usan estas herramientas que una parte muy importante del éxito del algoritmo está en la interacción entre el humano y la máquina, en el uso que las personas hacen de los algoritmos.

La clave es evitar una retroalimentación que potencie posibles sesgos. Por ejemplo, una persona que confía mucho en la tecnología aceptará cualquier resultado o decisión que esta tome y una muy escéptica no lo tendrá en cuenta.

Ninguno de los dos escenarios es deseable. “Hay que proporcionar al cliente o usuario información muy clara sobre qué está midiendo el algoritmo, cómo puede ayudarle o no y dónde debe complementarlo”, señala Galdon. Es fundamental -afirma- que la persona que vaya a usarlo disponga de instrucciones sobre cuál es su papel en la toma de decisiones: qué porcentaje estará determinado por el sistema y qué parte será decisión del humano.

Por último, la Agencia Española de Protección de Datos (AEPD) ha publicado también su guía sobre 'Requisitos en auditorías de tratamientos que incluyen Inteligencia Artificial'. El documento ofrece orientaciones, criterios y posibles objetivos de control y controles específicos que podrían incorporarse en estas auditorías desde una perspectiva de protección de datos.

Este trabajo recoge objetivos como inventariar el algoritmo auditado, identificar las responsabilidades y cumplir con el principio de transparencia; identificar las finalidades, analizar la proporcionalidad y necesidad del tratamiento y los límites en la conservación de los datos; asegurar la calidad de los datos y controlar posibles sesgos, entre otros.

La publicación de estas guías responde a una necesidad latente. La necesidad y la experiencia promoverán que sigan apareciendo más herramientas, referencias y buenas prácticas para facilitar el paso de la teoría a la práctica en el diseño, desarrollo y uso de algoritmos éticos.

Es un ámbito que seguirá evolucionando y creciendo. Como concluye Galdon: “Son armas imprescindibles para un nuevo mundo en el que tenemos que acostumbrarnos a trabajar con nuevas tecnologías para tomar mejores decisiones”.

*Conflicto de interés: Vínculo sentimental con una de las fuentes de este artículo (Oliver Smith, director de Estrategia y Responsable de Ética en Koa Health)