Google por fin ha encontrado la manera para hacer que no se vean las fotos panorámicas de 360 grados desencajadas.

Los imágenes panorámicas en 360º de Googlee Street (y en realidad, cualquier imagen de este tipo) está formada por una serie de fotografías. Es decir, hay una cámara con muchos objetivos que es capaz de sacar fotos desde varios ángulos y perspectivas, y así es como se consiguen estas fotografías. A día de hoy no requiere de una tecnología especialmente cara, y prácticamente cualquiera puede tener una roseta (una de estas cámaras) por casa.

Pero hay un problema: al ‘coser’ las fotografías, algunas pueden no coincidir, y por lo tanto se producen fallos más que evidentes. Y no es fácil de solucionar, pues habría que solucionar fotografía por fotografía, y no es viable. Hay que tener en cuenta que Google Street está compuesto por cientos de millones de fotografías (incluso puede que por miles de millones).

No obstante, Google ha encontrado, por fin, un método para que este fallo no vuelva a repetirse. Gracias a este, podrá volver a rehacer todas y cada una de las panorámicas que componen Google Street. También son muchísimas, por supuesto, pero el proceso será automático.

Cómo Google quiere reconstruir todas las panorámicas en 360º

Una de las variables más importantes a solucionar es el paralaje. Este es el efecto de visión de las fotografías desde distintos ángulos. Además, también interviene la variable del tiempo. No todas las cámaras disparan al mismo tiempo, por lo que no todas disparan en las mismas condiciones meteorológicas.

Según estas condiciones, una fotografía puede llegar a tardar incluso un segundo (para capturar más luz), y, si la fotografía se toma en movimiento (y también podría ocurrir si la cámara está estática y el objeto en movimiento), pueden haber unos pequeños desfases, que es lo que vemos a continuación.

fallo fotografias panoramicas 360 google street

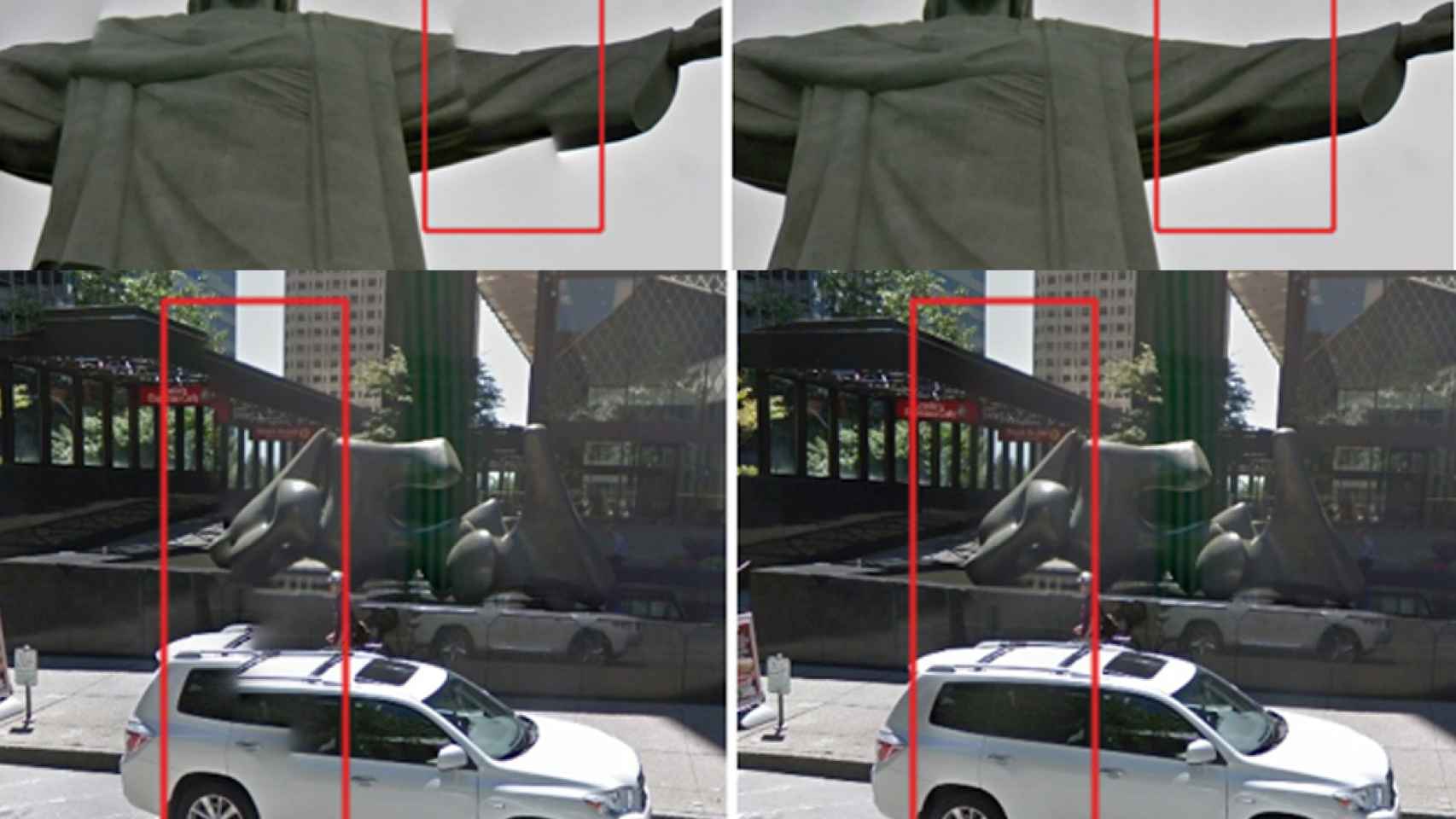

En la imagen superior tenemos las mismas fotografías, solo que en la de la izquierda se ha usado el ensamblado o cosido anterior, y en la de la derecha se ha usado el actual, con el que no se ven ese tipo de defectos.

Flujo óptico

Para que las fotografías salgan todas bien alineadas, hay que encontrar los marcos comunes. Es decir, hay que encontrar aquellas zonas donde las fotografías se unen a la perfección.

flujo optico fotografia panoramica 360 google street

Dando con los puntos compartidos, se pueden corregir los desplazamientos de alineación y se puede corregir la transición entre ambas imágenes. Vamos, que reconoce cada fragmento de la imagen para alinearlo todo correctamente.

Pero sigue habiendo un problema: al mover una foto, estás moviendo la alineación con otras, y cada foto puede estar en contacto con otras cuatro, por lo que no es tan sencillo.

Optimización global

Una vez se ha realizado el paso anterior, el siguiente paso consta en alinear las imágenes de la roseta para alinear de forma simultánea los puntos de las regiones de superposición. Es justamente lo que vemos en la imagen inferior.

Como las regiones que coinciden cubren únicamente una pequeña porción de la imagen, se convierte en una tarea complicada. En la imagen superior,de 180 grados, se ve al nuevo algoritmo de Google arreglando las costuras de las imágenes que componen la panorámica.

Noticias relacionadas

- Millones de negocios que aparecen en Google Maps no existen en realidad

- Ya puedes buscar estaciones de carga para coches eléctricos en Google Maps

- Google Maps para iOS ahora nos recomienda sitios usando aprendizaje automático

- Cambiar datos de los bancos en Google Maps, la nueva técnica de estafadores