Parece un poco raro decir esto, pero la lengua de signos es uno de los grandes desafíos a los que se enfrenta el sector tecnológico. Este método de comunicación, principalmente usado por personas sordas, tiene demasiados obstáculos como para ser implementado con facilidad en sistemas informáticos.

El principal problema está en la enorme variedad de gestos y formas que podemos realizar con las manos; para un sistema de visión inteligente, es difícil distinguir entre diferentes gestos realizados por diferentes manos.

No solo eso, sino que en muchas ocasiones las manos se tapan entre ellas para realizar ciertos gestos; en ese momento, la mayoría de sistemas pierden la posición de los dedos y la forma de la palma de la mano. Para detectar los gestos de la lengua de signos, es por lo tanto necesaria una percepción clara de lo que están haciendo las manos.

Google desvela el secreto de la lengua de signos

Ahora el laboratorio de Inteligencia Artificial de Google afirma que ha conseguido crear un sistema capaz de identificar gestos de la lengua de signos en tiempo real. Ha sido implementado en MediaPipe, un framework de código abierto que permite crear "tuberías" por las que procesar datos de diferentes modalidades, como audio o vídeo.

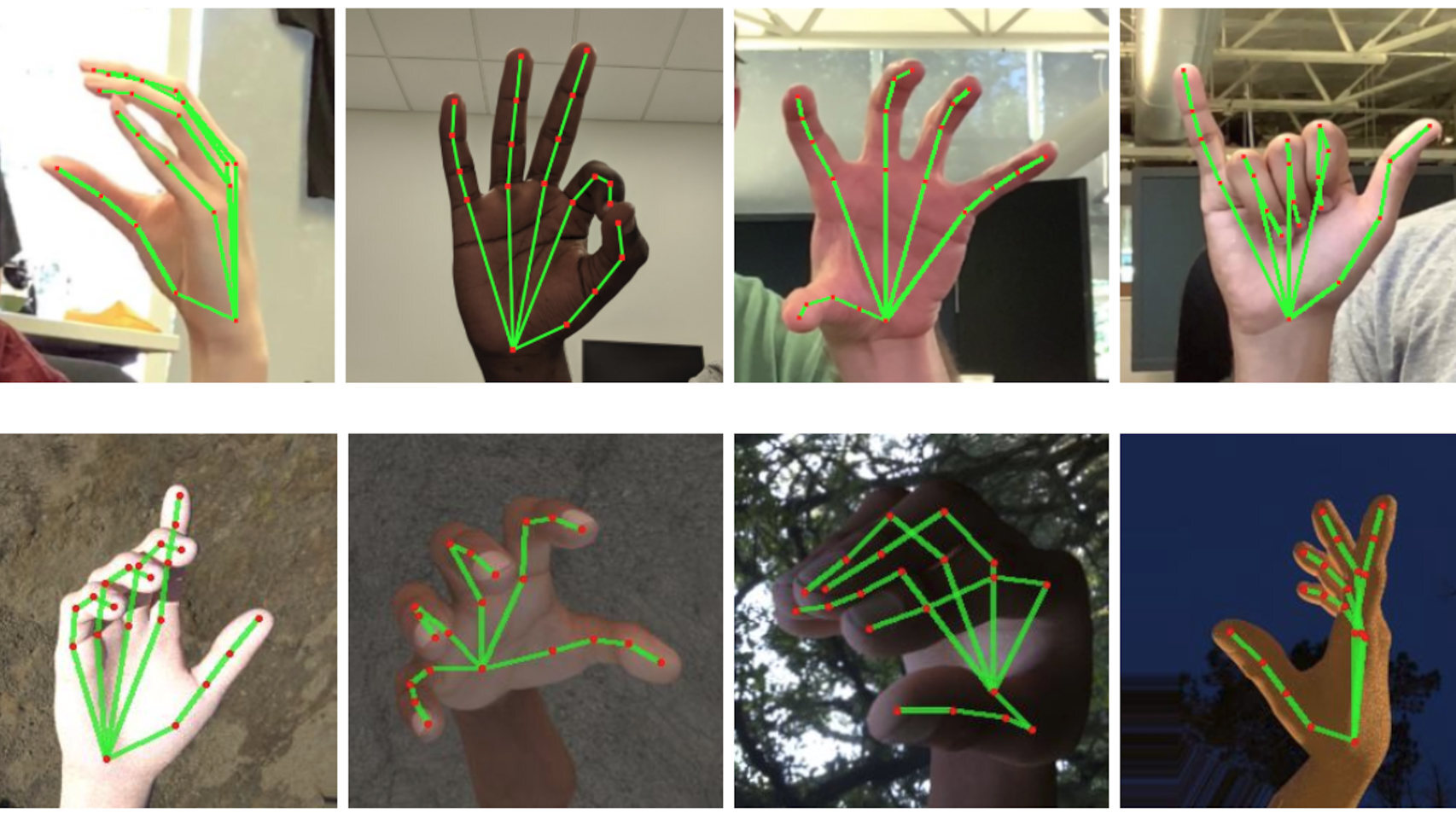

Por supuesto, este proyecto usa aprendizaje automático para detectar tanto la posición de la mano como de los dedos; lo interesante es que para conseguirlo, el sistema crea una malla de puntos tridimensional, que representa la posición de las articulaciones de la mano. El sistema de Google es entonces capaz de inferir la posición de esas articulaciones en base a un único frame (imagen) del vídeo.

Es gracias a esto que los resultados pueden analizarse en tiempo real. A partir de ahí, es una "simple" cuestión de asociar las diferentes formas de estas mallas de puntos con el significado que tienen para poder traducir gestos en tiempo real.

Prueba de lengua de signos

El anuncio de Google entra en detalle sobre el funcionamiento de esta IA, pero lo importante está en el modelo tridimensional. El sistema tuvo que aprender en base a unas 30.000 fotografías de personas hablando con el lenguaje de signos; se usó un mapa de profundidad para obtener la posición tridimensional de la mano.

El resultado da lugar al optimismo. Los ingenieros de Google han demostrado que es posible no solo para registrar lo que una persona está diciendo, sino también para algo tan banal como jugar al piedra-papel-tijera. El algoritmo es capaz de detectar la forma tridimensional de la mano con gran precisión.

El código del algoritmo se ha hecho público, para que cualquier investigador pueda usarlo para su proyecto. Por lo tanto, es muy posible que en los próximos años veamos grandes avances en el reconocimiento de esta lengua.