Ilustración de la Inteligencia Artificial

El gran proyecto de la Inteligencia artificial: un gran código abierto para no depender de empresas

Un grupo de científicos ha iniciado el proyecto BigScience, que pretende crear modelos de lenguaje de inteligencia artificial totalmente abiertos para la comunidad.

24 mayo, 2021 14:15Noticias relacionadas

La inteligencia artificial en España es un tema que genera pasión por los increíbles avances que se realiza en esta materia día a día. El mundo quedó asombrado (y horrorizado) cuando empezaron a surgir los primeros modelos de lenguaje, que imitaban el habla y la escritura humana. Unos modelos que han acabado dependiendo de empresas como Google.

La propia Google presentó en su Google I/O LaMDA, un sistema de IA que puede interactuar de forma natural con los usuarios, casi de cualquier tema. Y esto es llamativo, ya que la propia Google ha estado envuelta en algunas polémicas al respecto, como la presencia de sexismo, homofobia y racismo en los principales modelos de inteligencia artificial.

Por ello, más de 500 científicos provenientes de todo el mundo están trabajando bajo el paraguas del proyecto BigScience, dirigido por una startup conocida como Hugginface que además de querer entender el procesamiento del lenguaje natural en la IA, quiere crear un estándar para los modelos de lenguaje grande totalmente abierto para la comunidad científica y que no dependa de empresas.

Modelos de lenguaje

Para entender lo que estamos tratando, debemos aplicar algo de contexto. Google tiene la intención de integrar LaMDA en prácticamente todos sus servicios; búsqueda principal, su asistente e incluso su plataforma de trabajo colaborativo, Google Workspace. La idea es que los usuarios tengan una interfaz desde la cual poder conseguir información en los servicios de Google preguntándole a LaMDA.

Esto implica varias cuestiones. La primera, es la más obvia; que estas tecnologías basadas en el procesamiento del lenguaje acabarán en nuestro día a día, afectándonos directamente. Un modelo de lenguaje de amplio tamaño (LLM, por sus siglas en inglés) que estará directamente inmiscuido en nuestros servicios diarios y que, a su vez, depende de una gran empresa como es Google.

Otra de las cuestiones es algo que además se ha tratado con anterioridad, y es la inclusión de ideas extremistas en los modelos de lenguaje. La IA, al haberse basado primordialmente en grandes cantidades de datos, ha recogido algunas de las ideas más tóxicas del ser humano y por ejemplo se han descubierto sistemas con patrones racistas o sexistas. Palabras buenas para personas blancas y malas para las negras, o la aplicación de sesgos de género; un médico es hombre, mientras que una enfermera es mujer.

Debido a la propia envergadura de estos lenguajes, hay un problema colateral; la producción masiva de información errónea plagada por estos conceptos. Sin ir más lejos, este hecho fue señalado por Timnit Gebru, codirector de la división de IA ética de Google en un artículo. Fue expulsado por la propia Google, después de negarse a retractarse sobre su propia publicación.

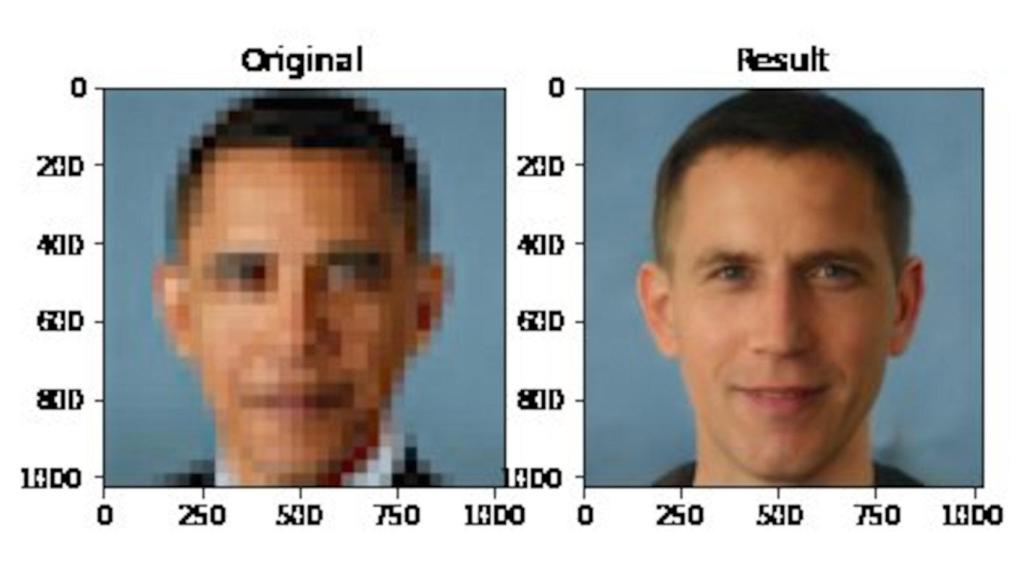

Obama se convierte en un hombre blanco con esta IA

Y todo esto, centrándonos solo en Google. Tenemos los casos de los modelos de lenguaje de OpenAI, como GPT-2 y GPT-3, capaces de generar texto con lenguaje humano convincente. Microsoft está otorgando licencias exclusivas de GPT-3 para productos no anunciados y Facebook está desarrollando sus propios LLM para traducción y moderación de contenido.

BigScience

Hay pocos estudios o investigaciones que hayan analizado en profundidad cómo se relacionan estos problemas de los modelos de lenguaje y el hecho de que se apliquen en prácticamente todos los aspectos de nuestra vida diaria. Google ya lo ha dejado claro; las pocas empresas con los recursos necesarios para desarrollar estos modelos de lenguaje tan grandes tienen intereses financieros y no las examinan todo lo que debería.

Es aquí donde entra en juego BigScience. Este proyecto busca cambiar el enfoque a uno de "ciencia abierta"; comprender el lenguaje natural aplicado a campos de IA y construir un modelo de lenguaje LLM de código abierto, sin que este dependa de ningún tipo de empresa o producto. No se trata de realizar un cambio en la industria, sino redirigir los fines de estos proyectos a campos más sanos.

Este proyecto nació específicamente como una respuesta a la falta de escrutinio por parte de las grandes empresas contra los LLM. Por supuesto, el caso de Gebru fue uno de tantos que motivó a los científicos de BigScience para asociarse y que la comunidad científica estuviera implicada en el desarrollo responsable de LLM.

La idea es que BigScience quiere desarrollar todo un LLM de código abierto con distintas aplicaciones, como realizar investigaciones críticas de forma independiente a las empresas. Aún con todo, ya han conseguido una subvención para desarrollarlo usando un superordenador propiedad del gobierno de Francia.

Pero ¿por qué más de 500 investigadores? En los proyectos LLM actuales, suelen trabajar alrededor de una docena de personas con conocimientos técnicos. Para buscar un enfoque verdaderamente colaborativo, BigScience quería incluir investigadores de una amplia gama de países y disciplinas. Ahora, es todo un proyecto global.

Hay más de una docena de grupos de trabajo colaborando, cada uno centrado en distintos aspectos del desarrollo de su modelo de lenguaje, como la huella de carbono que dejará su desarrollo o su propia ejecución. También buscarán formas "responsables" de obtener los datos para realizar los entrenamientos del modelo, buscando alternativas a la simple extracción de datos de Internet.

El LLM de BigScience estará caracterizado por su carácter multilingüe. Se han seleccionado hasta 8 idiomas con sus respectivas familias de idiomas, incluyendo el inglés, el chino, el árabe, el indio o el bantú. El plan es trabajar en estrecha colaboración con cada comunidad lingüística para trazar la mayor cantidad posible de sus dialectos regionales y garantizar que se respeten sus distintas normas de privacidad de datos.

Y no, este LLM no pretende pelear contra LaMDA o GPT-3. De hecho, lo más probable es que no sea siquiera útil para las empresas, pero sí para la investigación científica. Por si fuera poco, ninguno de estos investigadores está recibiendo una remuneración como tal por este proyecto, ya que son voluntarios. La subvención francesa solo incluye recursos computacionales.

Los miembros de BigScience esperan que para el final del proyecto (que durará, se espera, hasta finales de mayo de 2022) habrá no sólo una investigación profunda sobre las limitaciones e implicaciones de los LLM, sino herramientas mejoradas para desarrollarlos e implementarlos de forma responsable.