Proyecto de Facebook Omicrono

Facebook enseña a una IA a entender el mundo desde el punto de vista de un humano

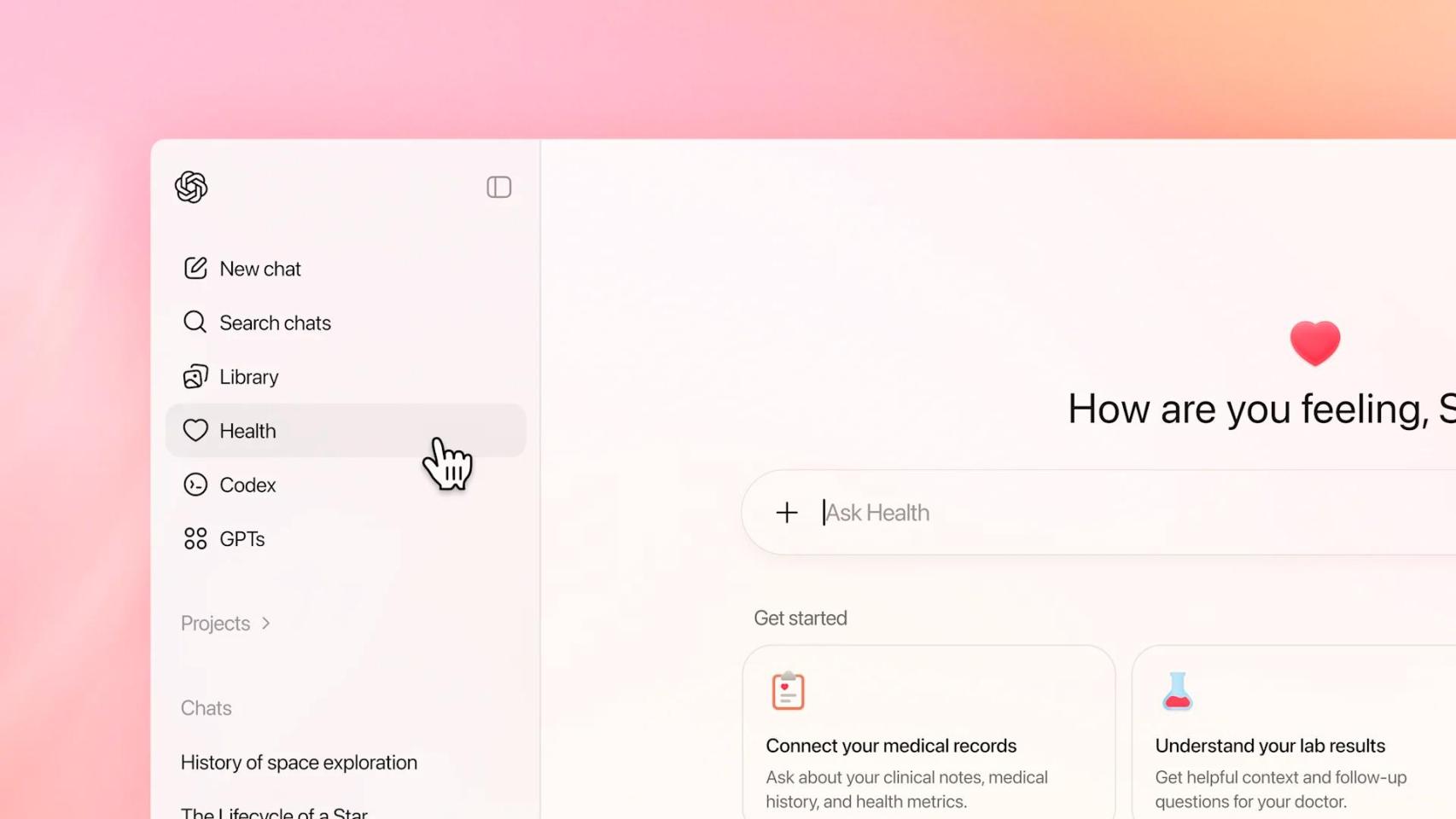

Un nuevo proyecto de inteligencia artificial de Facebook está intentando crear sistemas de IA que entiendan el mundo y cómo funciona desde la perspectiva de un ser humano.

Noticias relacionadas

Hace muy poco vimos en España como Facebook lanzaba sus primeras gafas de realidad aumentada en colaboración con Ray-Ban. No obstante, parece que la empresa tiene un enfoque adicional respecto a esta tecnología, y la prueba de ello es su nuevo proyecto de investigación para desarrollar sistemas de IA que entienden el mundo como lo haría una persona.

La idea es que esta IA pueda comprender lo que ocurre a su alrededor desde el punto de vista de un humano. Es decir, sistemas de inteligencia artificial que pueden ver, registrar y oír lo que hacemos. Incluso 'recordar' qué hemos hecho gracias a la inclusión de puntos de referencia para establecer habilidades que desarrollen estos sistemas.

Facebook ha desarrollado toda una serie de desafíos centradas en la experiencia visual en primera persona para estos sistemas de IA, que incluyen puntos de referencia que potencien a esta IA para el uso cotidiano. Algunos de estos puntos incluyen por ejemplo el pronóstico de sucesos que van a pasar, la manipulación de manos y objetos e incluso interacción social.

Un nuevo proyecto de IA

Punto de vista del proyecto. Omicrono

Este proyecto de investigación ha sido dirigido por el equipo de inteligencia artificial de Facebook y estos 5 desafíos han sido desarrollado junto a un consorcio de hasta 13 universidades y laboratorios que han recopilado más de 2.200 horas de vídeo en primera persona junto a 700 participantes que registran datos sobre su vida cotidiana. También participan los Facebook Reality Labs en estos 5 puntos de referencia:

- Memoria episódica: ¿Qué pasó cuando? (Ejemplo: "¿dónde dejé mis llaves?")

- Pronóstico o estadística: ¿Qué es probable que haga a continuación? (Ejemplo: "Espera, ya le has agregado sal a esta receta")

- Manipulación de manos y objetos: ¿Qué estoy haciendo? (Ejemplo: "Enséñame a tocar la batería")

- Diarios audiovisuales: ¿Quién dijo qué y cuándo? (Ejemplo: "¿Cuál fue el temario principal de la clase?")

- Interacción social: ¿Quién interactúa con quién? (Ejemplo: "Ayúdame a escuchar mejor a la persona que me habla en ese restaurante").

Estos puntos, según Facebook, servirán para catalizar la investigación sobre los componentes básicos necesarios para desarrollar asistentes de IA más inteligentes que puedan, además de comprender e interactuar con el mundo, también lo puedan hacer con el metaverso.

Una de las habilidades de la IA Omicrono

Con estos puntos de referencia, los sistemas desarrollados por Facebook podrían analizar nuestra vida comprendiendo qué es lo que ven, que es lo que hacen y oír qué es lo que ocurre para ayudarnos a realizar diversas tareas de nuestro día a día. Todo ello usando de referencia contenido en primera persona.

Y no son puntos al azar; estos son los 5 puntos más débiles de la IA, ya que ningún sistema puede realizarlos de manera fiable actualmente. El proyecto que buscará llevarlos a la IA es Ego4D, y además de los puntos de referencia, esta investigación también usará un conjunto de datos en abierto basados en vídeos de primera persona.

Muchos participantes en el proyecto. Omicrono

Este, según Facebook, es el conjunto de datos de su tipo más grande jamás creado. Las universidades se encargaron de recopilar los metrajes, y los participantes en la investigación usaron cámaras GoPro y gafas de realidad virtual para grabar vídeos de actividades cotidianas, sin guión.

Esto incluye jugar con mascotas, socializar, trabajar, etcétera. Todos los datos personales de los vídeos fueron eliminados (las caras y los datos personales fueron difuminados). De hecho, como referencia, el proyecto comparable más cercano tiene 100 horas de metraje, casi todas recogidas en cocinas, según Facebook.

Aplicaciones en el mundo real

Transcripción de audio Omicrono

Aunque Facebook ya deja claro que este no es un desarrollo comercial sino una investigación, la empresa ya habla de aplicaciones en el campo de la realidad aumentada y en la computación asociada a ella. Según asegura Kristen Garauman, científica en el grupo de investigación de IA de Facebook, "pensando en la realidad aumentada y en lo que nos gustaría poder hacer con ella, hay posibilidades en el futuro de aprovechar este tipo de investigación".

Aún con todo, Ego4D tiene la intención de convertirse en un estándar incluso dentro de los sistemas de inteligencia artificial que pretende desarrollar. Sobre todo, también espera que tenga efectos importantes en el terreno de la RA (realidad aumentada). De hecho, la compañía llega a afirmar que algún día estos sistemas podrían usarse en cámaras de ordenadores, sino en robots asistentes, como el que vimos recientemente de la mano de Amazon.

Problemas de privacidad

Punto de vista del proyecto. Omicrono

No obstante, el hecho de que estos sistemas de IA puedan ver, oír e incluso recordar lo que hacemos tiene una serie de implicaciones en la privacidad de los usuarios. Especialmente teniendo en cuenta el complicado historial que tiene la red social con el asunto de la privacidad, ya que acumula brechas de seguridad e incluso multas de organismos internacionales tanto en Estados Unidos como en Europa.

Y es que una de las grandes preocupaciones sobre Ego4D es que aunque la investigación presenta aplicaciones y escenarios tremendamente prácticos y positivos, se hace poca incisión en las cuestiones de privacidad de los usuarios. Por ejemplo, no toca los escenarios en los que, por ejemplo, la transcripción del audio se puede almacenar y por ende grabar.

La única respuesta la ha dado un portavoz de Facebook al medio The Verge, que aseguró que en un futuro estas medidas de seguridad se implementarían. "Esperamos que, en la medida en que las empresas utilicen este conjunto de datos y este punto de referencia para desarrollar aplicaciones comerciales, desarrollarán sistemas de seguridad para dichas aplicaciones".