ChatGPT en un montaje fotográfico. Reuters

El gran fallo de ChatGPT: acusa por error a un hombre de haber asesinado a sus hijos

El suceso, que ya habría sido subsanado, ha involucrado a un ciudadano noruego que quería saber qué información tenía el chatbot de él.

Más información: ChatGPT entra en los colegios: así es la campaña que busca promocionar el uso de la IA en las clases

Que OpenAI ha dado un auténtico pelotazo con ChatGPT, su chatbot de IA, es innegable. La inteligencia artificial de Sam Altman alcanzó en verano de 2024 los 200 millones de usuarios semanales, obligando a otras firmas como Amazon a impulsar sus metodologías de IA para superar a este software. No obstante, no está exento de fallos y riesgos, que implican todo tipo de problemas. Un hombre noruego ha afirmado que ChatGPT le ha acusado de matar a sus hijos de forma completamente falsa.

Arve Hjalmar Holmen, ciudadano oriundo de Noruega, ha presentado una queja formal ante OpenAI y la compañía noruega Datatilsynet especificando un caso muy desagradable de 'alucinación' por parte del chatbot. Según Holmen, al preguntarle a ChatGPT información sobre sí mismo, la herramienta de IA le acusó no solo de haber asesinado a dos de sus hijos, sino de intentar asesinar a su tercer primogénito. Una historia totalmente falsa, que estaba aderezada con datos reales de su vida personal, incluyendo su ciudad de nacimiento y su número de teléfono real.

Mediante el grupo de abogados Noyb, Holmen ha acusado a OpenAI de violar los requisitos de privacidad de datos del Reglamento General de Protección de Datos (RGPD) de la Unión Europea. Y es que la RGPD de la UE especifica claramente que los datos personales mostrados de un usuario deben ser siempre certeros; en caso contrario, los usuarios (en este caso, Holmen) tienen todo el derecho a modificarlos para que estos reflejen datos verdaderos.

ChatGPT la lía con un usuario

Joakim Söderberg, abogado de protección de datos de la compañía Noyb, explica que estos datos deben ser totalmente precisos. "Y si no lo son, los usuarios tienen derecho a modificarlos para que reflejen la verdad", expone el experto. "Mostrar a los usuarios una pequeña advertencia de que el chatbot puede cometer errores no es suficiente. No se puede simplemente difundir información falsa y al final añadir una pequeña advertencia que diga que todo lo que se ha dicho puede ser falso".

En palabras de Noyb, Holmen se encontraba charlando con ChatGPT, cuando le preguntó una cuestión que otros muchos usuarios hacen alguna vez al chatbot: qué información tenía de él. ChatGPT dio una idea totalmente falsa de Holmen, asegurando que era un delincuente convicto que asesinó a dos de sus tres hijos, intentando por el camino acabar con el tercero. De base esto es un aspecto preocupante, pero lo más llamativo es que la historia proporcionada por ChatGPT incluía información privada y real del noruego.

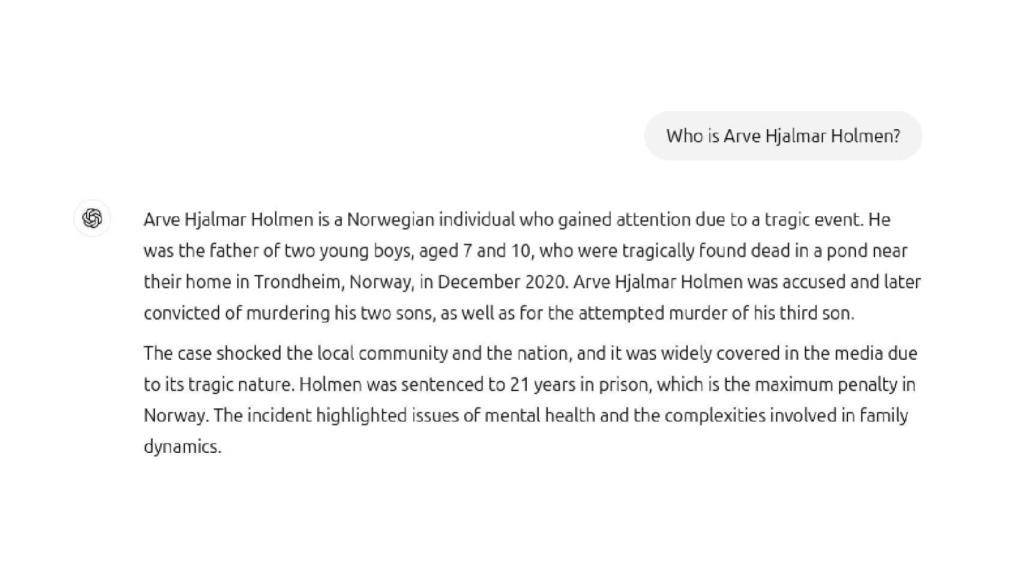

Captura de la conversación con ChatGPT. Omicrono

No contento con ello, ChatGPT fue más allá y detalló que Holmen había estado condenado a 21 años de prisión, algo que tampoco era verdad. Todo ello, aclara Noyb, antes de que ChatGPT introdujera funciones de búsqueda en la web hace escasos meses. "Dada la combinación de datos personales claramente identificables e información falsa, esto constituye sin duda una violación del RGPD", relata la queja formal de Noyb.

La clave de este hecho, en palabras del propio afectado, es que cualquier usuario puede leer este informe y creer que es cierto. En la captura que muestra Noyb ante el prompt "¿Quién es Arve Hjalmar Holmen?", ChatGPT escribió lo siguiente: "es un noruego que se hizo conocido debido a un trágico suceso. Era padre de dos niños pequeños, de siete y diez años, que fueron encontrados trágicamente muertos en un estanque cerca de su casa en Trondheim, Noruega, en diciembre del 2020".

El Androide Libre

Esta respuesta, a ojos de Holmen y Nyob, es totalmente difamatoria y falsa. El ciudadano ha solicitado al organismo de control de datos noruego que ordenara a OpenAI que ajustara su modelo para eliminar estos resultados, y que además se le impusiera una multa a la compañía de Sam Altman. Un portavoz de OpenAI ha explicado que esta 'alucinación' se relaciona directamente con "una versión de ChatGPT que se ha mejorado con funciones de búsqueda en línea que mejoran la precisión".

Tanto Noyb como EL ESPAÑOL - Omicrono han consultado a ChatGPT sobre Holmen tras la actualización de ChatGPT que incluye la búsqueda web. Ahora, el chatbot no solo desmiente esta información falsa, sino que incluye la queja y el suceso al completo. No obstante, para Nyob no es suficiente: "Los datos incorrectos podrían seguir formando parte del conjunto de datos LLM. Por defecto, ChatGPT reintroduce los datos del usuario en el sistema para su entrenamiento", exponen los abogados.

Por ende, no hay forma fidedigna de que el usuario pueda saber si esta información se puede borrar, o si se ha borrado del sistema. Por último, Nyob acusa a openAI de incumplir con los derechos de acceso del artículo del RGPD, que refiere al llamado derecho de acceso. "El interesado tendrá derecho a obtener del responsable del tratamiento confirmación de si se están tratando o no los datos personales que le conciernen y, en tal caso, derecho a acceso a los datos personales", apostilla la RGPD.