bots de facebook messenger

Facebook suspende su IA tras etiquetar como "primates" a hombres negros

La red social se disculpa y suspende la función de recomendación que gestiona su inteligencia artificial, promete investigar lo sucedido para que no vuelva a pasar.

6 septiembre, 2021 10:26Noticias relacionadas

Facebook se ha disculpado por lo que califican como "error inaceptable" de su inteligencia artificial. El sistema recomendó a los usuarios un vídeo donde salía hombres negros como contenidos sobre primates. Un nuevo ejemplo de tecnología con sesgos racistas como otros muchos que se han conocido en España en los últimos años.

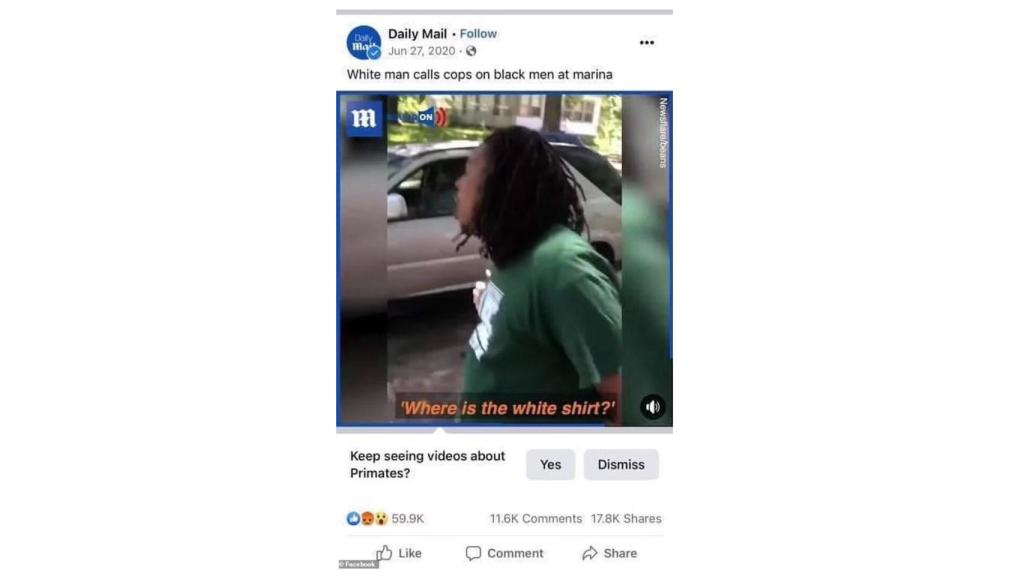

El pasado 27 de junio, se produjo el error con un vídeo del periódico británico Daily Mail, según explica The New York Times. Ante las críticas, Facebook ha tenido que disculparse y suspender la función de recomendaciones para revisar el funcionamiento de su inteligencia artificial.

Este suceso se suma así a la larga lista de muestras racistas y sexistas que la inteligencia artificial replica. En OMICRONO hemos hablado en más de una ocasión sobre cómo las redes sociales destacan las fotografías de personas blancas y discriminan al resto de razas.

Vídeo sobre "primates"

El video en cuestión mostraba una discusión entre un hombre negro y otro blanco. Según el medio británico, el hombre blanco estaba acosando al otro y al final debe intervenir la policía. Pero independientemente del asunto del vídeo, Facebook recomendó esa publicación bajo el mensaje de "¿Quieres seguir viendo videos sobre primates?"

Error de Facebook racista Omicrono

Las críticas no tardaron en aparecer, pero Facebook no notificó el error al principio al Daily Mail. Ahora la red social se disculpa ante The New York Times y asegura que fue un error inaceptable. "Como hemos dicho, aunque hemos realizado mejoras en nuestra IA, sabemos que no es perfecta y tenemos más avances que hacer" aseguran desde la compañía de Mark Zuckerberg.

La compañía que también es propietaria de WhatsApp e Instagram ha desactivado la función de recomendaciones en su principal red social para investigar lo sucedido y tratar de evitar que vuelva a suceder.

Otros errores

“Todos los días vemos los límites, los prejuicios y la pura idiotez de depender únicamente de la inteligencia artificial. Y, sin embargo, seguimos permitiéndonos ser conejillos de indias", ha tuiteado la reportera de ciberseguridad del New York Times, Nicole Perlroth, ante este caso.

No son pocos los momentos en los que la inteligencia artificial ha mostrado estar plagada de sesgos heredados de los propios humanos. Este último mes Twitter también se ha enfrentado a esta realidad, sus algoritmos inteligentes prefieren las fotos de personas jóvenes y blancas.

Estas tendencias surgen de los procesos de entrenamiento en los que la inteligencia artificial recibe un determinado número de muestras o parámetros que le sirven como ejemplos para entrenar sus funciones. Si la muestra es poco variada e incluye un mayor número de imágenes de una raza o género, a la inteligencia artificial le costará reconocer al resto de personas que no cumple con esas características.