Joe Biden habla por teléfono en la Casa Blanca en mayo de 2023. Getty Images

Adiós a las llamadas con voces clonadas por IA para evitar estafas: el primer país que las prohíbe

Casos como la clonación de Joe Biden han animado a EEUU a prohibir estas llamadas artificiales que también se usan en estafas telefónicas.

9 febrero, 2024 09:42La inteligencia artificial ha entrado en las elecciones generales de Estados Unidos. La generación de imágenes falsas de los candidatos, así como la clonación de sus voces está siendo un quebradero de cabeza para el regulador electoral en el país. Una preocupación que también se extiende a otros países democráticos como los que forman la Unión Europea, entre ellos España. Además de la intervención de los responsables de estas herramientas como OpenAI, el uso de nuevas leyes parece la solución a este riesgo en auge.

En este sentido, EEUU ha sido el primero en actuar. La Comisión Federal de Comunicaciones (FCC) ha declarado este jueves ilegales las llamadas automáticas que usan la clonación de voz generada por inteligencia artificial. Con esta medida se pretende frenar el auge de las llamadas artificiales que persiguen el fraude económico como objetivo, así como aquellas que promueven la desinformación en plenas elecciones electorales.

Descolgar el teléfono y escuchar la voz del presidente del gobierno pidiendo a sus ciudadanos que no vayan a votar a estas primarias presidenciales. Esto ha ocurrido en las últimas semanas con la voz de Joe Biden, el caso que ha hecho saltar todas las alarmas. No es el único, días antes OpenAI bloqueaba a un desarrollador por haber usado su tecnología para crear un bot que imitaba a un candidato demócrata como campaña para las primarias de New Hampshire.

La IA en elecciones

La agencia ha dicho que, a partir de esta semana, se basará en la Ley de Protección al Consumidor Telefónico (TCPA, por sus siglas en inglés) de 1991. Esta prohíbe las llamadas automáticas que utilizan mensajes de voz pregrabados y artificiales. La presidenta de la FCC, Jessica Rosenworcel, ha explicado que esta medida facilitará la labor de los fiscales para perseguir a quienes utilizan esta nueva tecnología para programas llamadas no deseadas.

El Fiscal General de New Hampshire identificó a principios de semana a un hombre de Texas y su empresa Life Corporation como los responsables de las llamadas automatizadas con la voz clonada de Joe Biden. Las autoridades creen que más de 20.000 residentes de New Hampshire recibieron las llamadas.

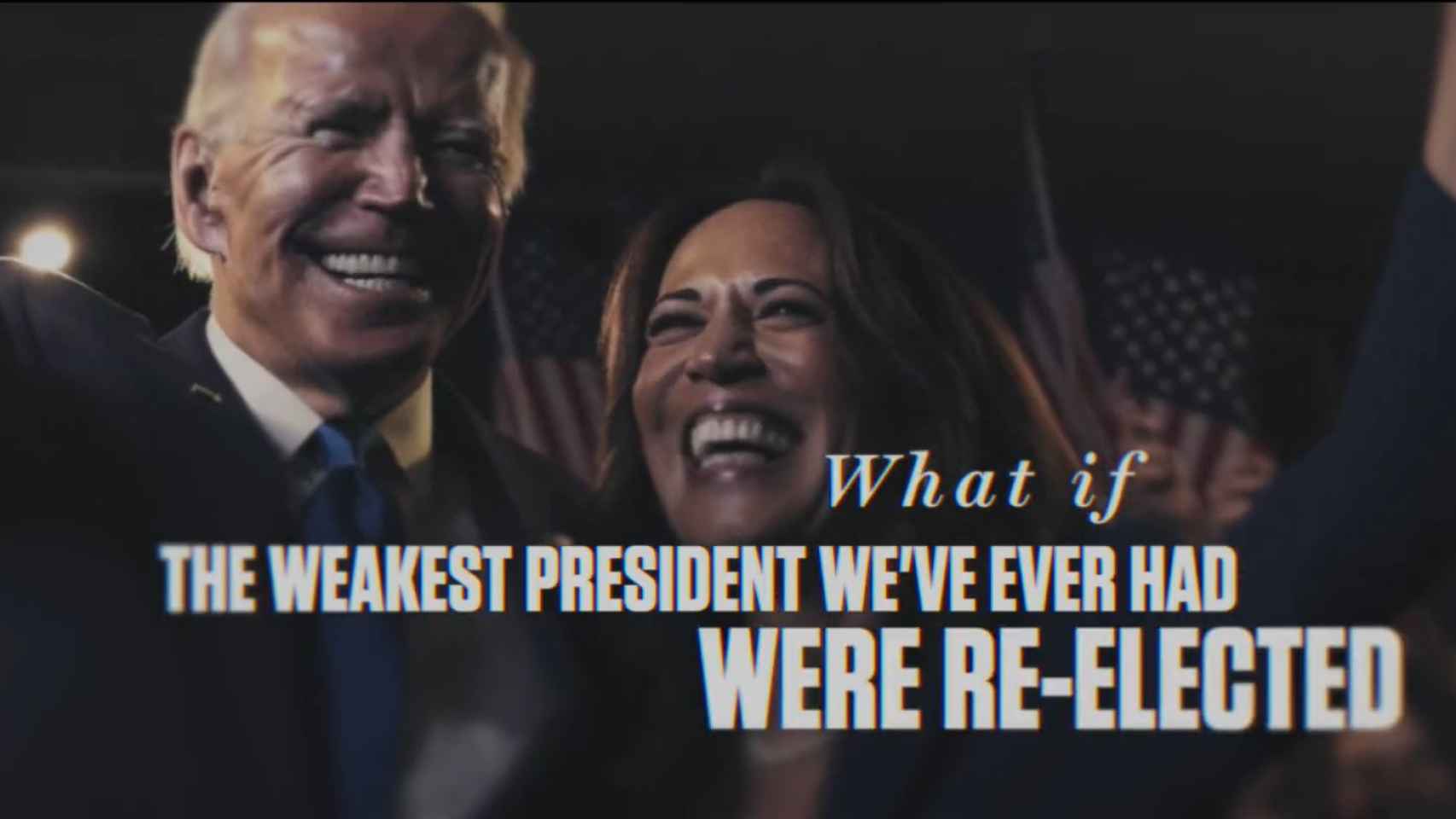

Captura de pantalla del vídeo que los republicanos han creado con inteligencia artificial para contestar a Biden.

Frente al uso de la voz, están los vídeos e imágenes falsas. Herramientas como DALL-E-3 o Midjourney son las más populares en la creación de imágenes desde cero o en la modificación de fotografías ya existentes. Algunas empresas ya habían bloqueado ciertas peticiones o nombres populares para evitar malos usos con sus IAs, pero las elecciones están obligando a reforzar las políticas de uso y Midjourney se estaría planteando prohibir las imágenes de Biden y Trump en esta temporada electoral.

En Europa se han establecido leyes contra el spam telefónico con fines comerciales. Sin embargo, en lo relativo al uso de la inteligencia artificial todavía se está trabajando en la nueva ley europea acordada a finales de 2023. En su borrador se establece que los sistemas de IA utilizados para influir en el resultado de las elecciones y el comportamiento de los votantes se clasifican como de alto riesgo.

Estafas telefónicas realistas

A favor o en contra del candidato, cualquiera puede ahora generar un mensaje con la voz clonada de otra persona y que parezca realista. Esta tecnología no solo se aplica en campaña electoral, los ciberdelincuentes también se están aprovechando de ella para estafar a las personas. Con generadores de texto crean correos destinados a campañas de phishing, mientras que con la generación de voz pueden llegar a imitar a familiares para recrear falsos secuestros o emergencias personales para pedir información o dinero.

Las estafas telefónicas ya eran populares antes de la revolución protagonizada por la inteligencia artificial generativa en el último año. Ahora se ha democratizado la posibilidad de darles un nivel de realismo mayor. Con algunos programas basta con unos pocos segundos de un audio de la persona y poco dinero para clonarla. Por ejemplo, los timadores pueden hacerse pasar por un nieto que ha perdido la cartera de viaje y necesita que sus abuelos le manden dinero urgente al móvil de un "amigo".

Los expertos en ciberseguridad aconsejan mantener la calma en estos casos y analizar la conversación para detectar fallos en la fluidez de la voz o la capacidad para responder como esa persona imitada ante preguntas inesperadas. También establecer algún tipo de código para identificarse.

También te puede interesar...

- El sencillo truco para hackear ChatGPT que revela miles de teléfonos y emails privados

- Amazon lanza Q, su rival de ChatGPT quiere revolucionar la empresa antes de saltar a Alexa

- ¿ChatGPT es de izquierdas? Desvelan las tendencias políticas de las inteligencias artificiales