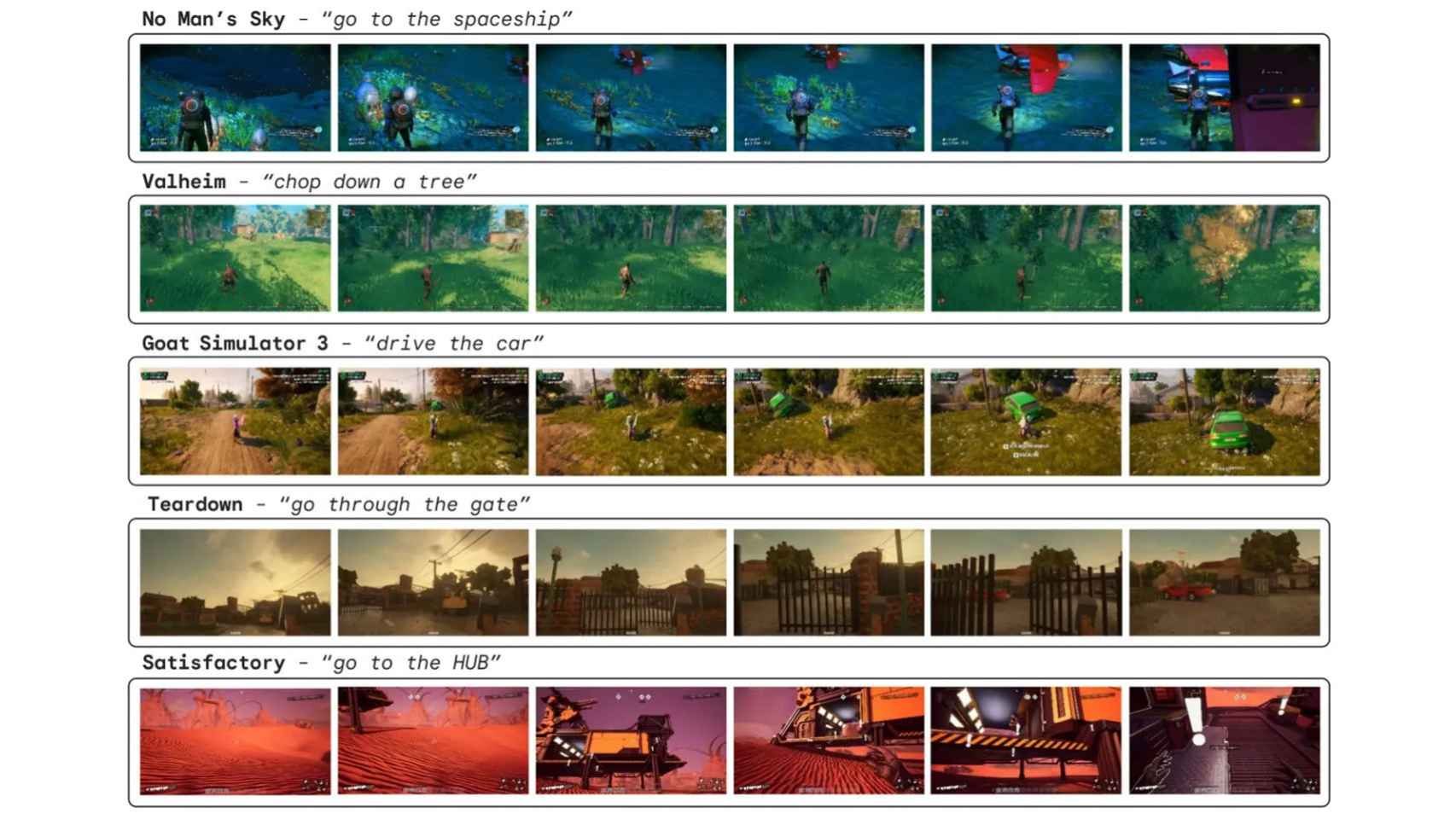

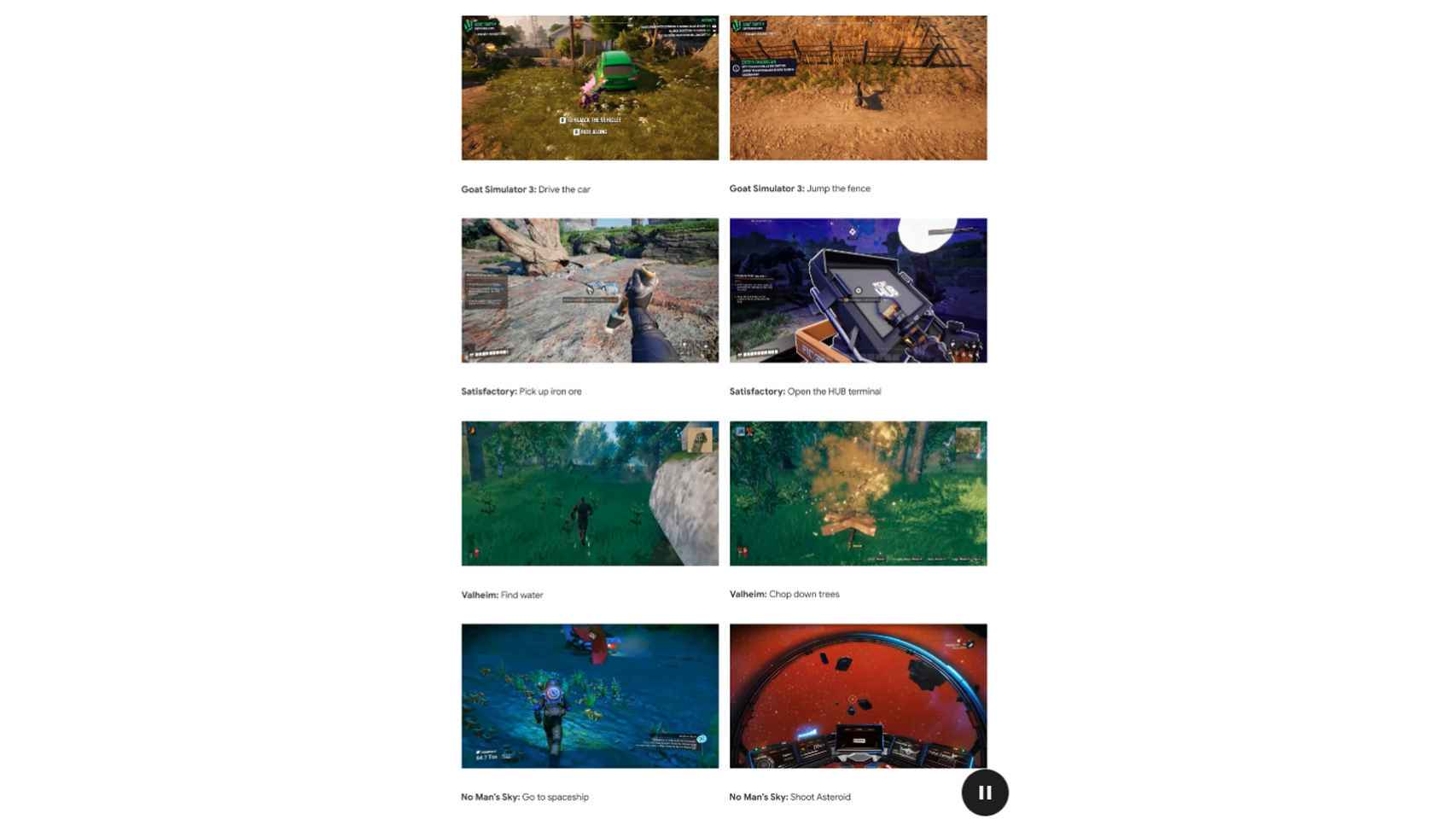

Títulos en los que SIMA ha sido puesto a prueba. Omicrono

Esta inteligencia artificial es capaz de jugar a videojuegos como un humano y entender sus entornos virtuales

El equipo de Google DeepMind ha desarrollado un modelo de IA que con unas pocas instrucciones puede hacer más de 600 tareas básicas.

13 marzo, 2024 18:34La inteligencia artificial ha estado ligada de muchas formas al mundo del videojuego. La IA aplicada a este sector no es algo nuevo, y lleva décadas presente en España y en el resto del mundo. No obstante, Google DeepMind ha conseguido algo sorprendente: un modelo de inteligencia artificial que lejos de ser un personaje, juega a juegos 3D como si fuera un humano. Un modelo que, además, es capaz de realizar tareas dentro de estos entornos 3D de forma fiable.

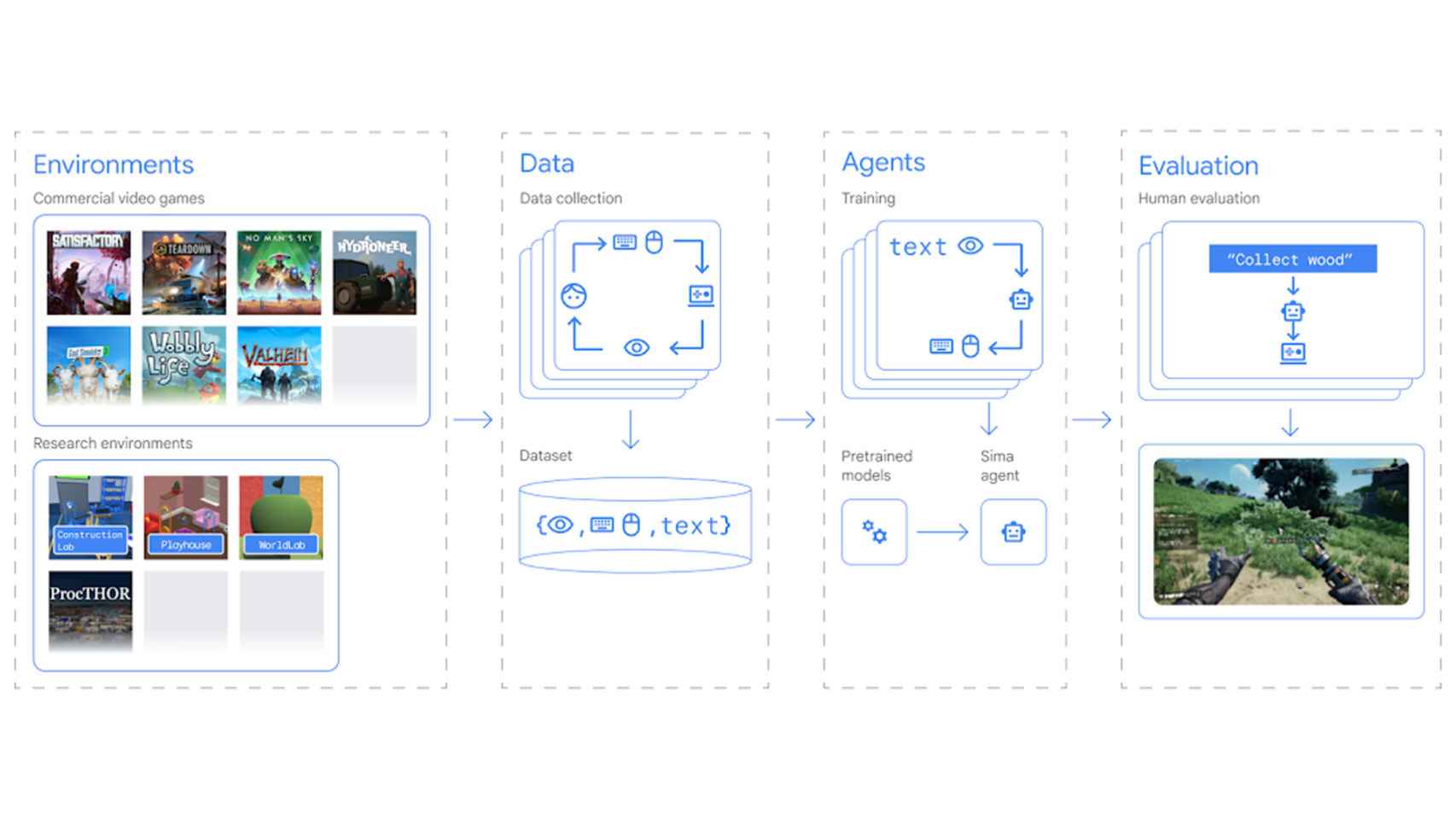

Los investigadores de DeepMind han publicado una investigación en la que experimentaron con la idea de un modelo de IA que pudiera aprender a jugar a videojuegos con entornos 3D que nunca hubiera visto de forma previa. Este modelo resultante es capaz de comprender una amplia gama de mundos virtuales, y seguir una serie de pautas y reglas dentro de ellos basándose en instrucciones dictadas en lenguaje natural.

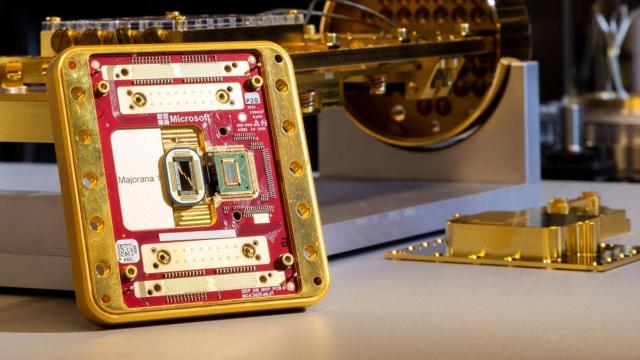

Dicha obra ha sido posible gracias a un trabajo conjunto de los investigadores y estudios y desarrolladores de videojuegos, tales como Hello Games o Coffee Stain, creadores de títulos tan reconocibles como No Man's Sky o Goat Simulator 3. En total, entrenaron dicho modelo llamado Scalable Instructable Multiworld Agent (por sus siglas en inglés, SIMA) hasta en 9 juegos distintos, con cuatro entornos de investigación.

Una IA capaz de jugar a videojuegos

El nombre del modelo traducido vendría a ser Agente Multimundo Escalable e Instructable, y parte de su revolución radica en su entrenamiento. El modelo no está conectado de ninguna forma al videojuego o a sus normas intrínsecas; es decir, que la IA no ha tenido acceso al código interno del software en cuestión, algo que le serviría para entender más fácilmente el mundo en el que se encuentra.

En total, se usaron 9 juegos distintos para entrenar a SIMA y hasta cuatro entornos de investigación, incluyendo uno hecho enteramente en Unity. Esta es, según Google, la primera vez que un agente de DeepMind consigue comprender una amplia gama de mundos de juego, siguiendo instrucciones de lenguaje natural para realizar tareas.

Instrucciones basadas en lenguaje en un fotomontaje. Omicrono

En palabras de los investigadores, esto dio a SIMA la capacidad de aprender de un importante abanico de entornos y escenarios. Todos ellos, por cierto, gozando de estilos gráficos y perspectivas totalmente distintas. La investigación de DeepMind busca traducir las capacidades de los modelos más avanzados de IA en acciones útiles en el mundo real a través de una interfaz de lenguaje, y este es un escenario ideal para ello.

Los investigadores quieren aclarar la importancia de este hito, ya que como dicen, "no se trata de lograr puntuaciones altas" en estos juegos; jugar a un videojuego es una tarea hercúlea para un sistema de IA, debido a muchos motivos, como la infinidad de factores distintos a los que este se tiene que someter.

Esquema con la comparación entre agentes especializados en entornos virtuales. Omicrono

En pos de la investigación, desde DeepMind diseñaron entornos de investigación de todo tipo, incluyendo uno llamado "Construction Lab". En este, los agentes de IA debían construir figuras a partir de bloques de construcción, lo que puso a prueba la capacidad de estos de manipular objetos y su comprensión intuitiva del mundo físico.

Así, SIMA consiguió capturar cómo el lenguaje se relaciona con el comportamiento del juego. El resultado final fue un agente de IA que tal y como explica Google, puede "percibir y comprender una variedad de entornos y luego tomar acciones para lograr un objetivo indicado". Este SIMA consta de un modelo diseñado para realizar un mapeo de las imágenes y el lenguaje y un modelo de vídeo, que se encarga de predecir lo que sucederá en pantalla a continuación.

[El año de la inteligencia artificial: de anécdota a una herramienta cada vez más útil y omnipresente]

Ambos modelos fueron ajustados con datos de entrenamiento específicos de la configuración 3D del porfolio de SIMA. De nuevo, el modelo no necesita acceso al código fuente del juego; solo precisa de imágenes en pantalla y una serie de sencillas instrucciones en lenguaje natural, impartidas por el usuario en cuestión.

Usa, por cierto, salidas de teclado y ratón para por ejemplo controlar al personaje central de los juegos. Esto no es algo baladí, ya que esta es la interfaz que más suelen usar los humanos; de esta forma, SIMA podría interactuar con prácticamente cualquier entorno virtual que siga un esquema similar. La versión actual del modelo se evalúa en hasta 600 habilidades básicas, que van desde la navegación hasta la interacción con objetos, pasando por el uso del menú.

Algunas de las habilidades básicas a las que se entrenó SIMA. Omicrono

Otro aspecto clave de la investigación es que los investigadores descubrieron que un agente único entrenado en muchos juegos es una solución que solo esté capacitado a jugar a un único juego. Esto fue tal que el agente entrenado en varios juegos pudo desenvolverse de manera similar a otros agentes en juegos hasta ahora desconocidos para ellos.

Así, SIMA cuenta con una capacidad inaudita para funcionar en entornos totalmente nuevos. Según Google, esta capacidad para "generalizar más allá de su capacitación" es sin duda un resultado inicial prometedor, aunque reconocen la necesidad de investigar bastante más en estos campos para conseguir que estos modelos funcionen a niveles humanos.

Por último, Google DeepMind reconoce que el gran punto flaco de SIMA es su dependencia del lenguaje. En uan de las pruebas de control en las que no se proporcionaron instrucciones o entrenamientos lingüísticos al modelo, se pudo ver cómo SIMA perdía el rumbo. Eso sí, sin entrar en comportamientos erráticos o inapropiados.