La tecnología tras las nuevas herramientas generativas como ChatGPT o Gemini, no solo sirven para aprender idiomas o buscar nuevos destinos para las vacaciones. Las redes neuronales y los modelos de lenguaje multimodal se están usando para facilitar a los robots un nivel de comprensión del mundo que les rodea mayor del que alcanzaban hasta ahora. Robots humanoides con agilidad y fuerza superior a los de los humanos como el nuevo Atlas de Boston Dynamics o su rival chino con una flexibilidad sorprendente.

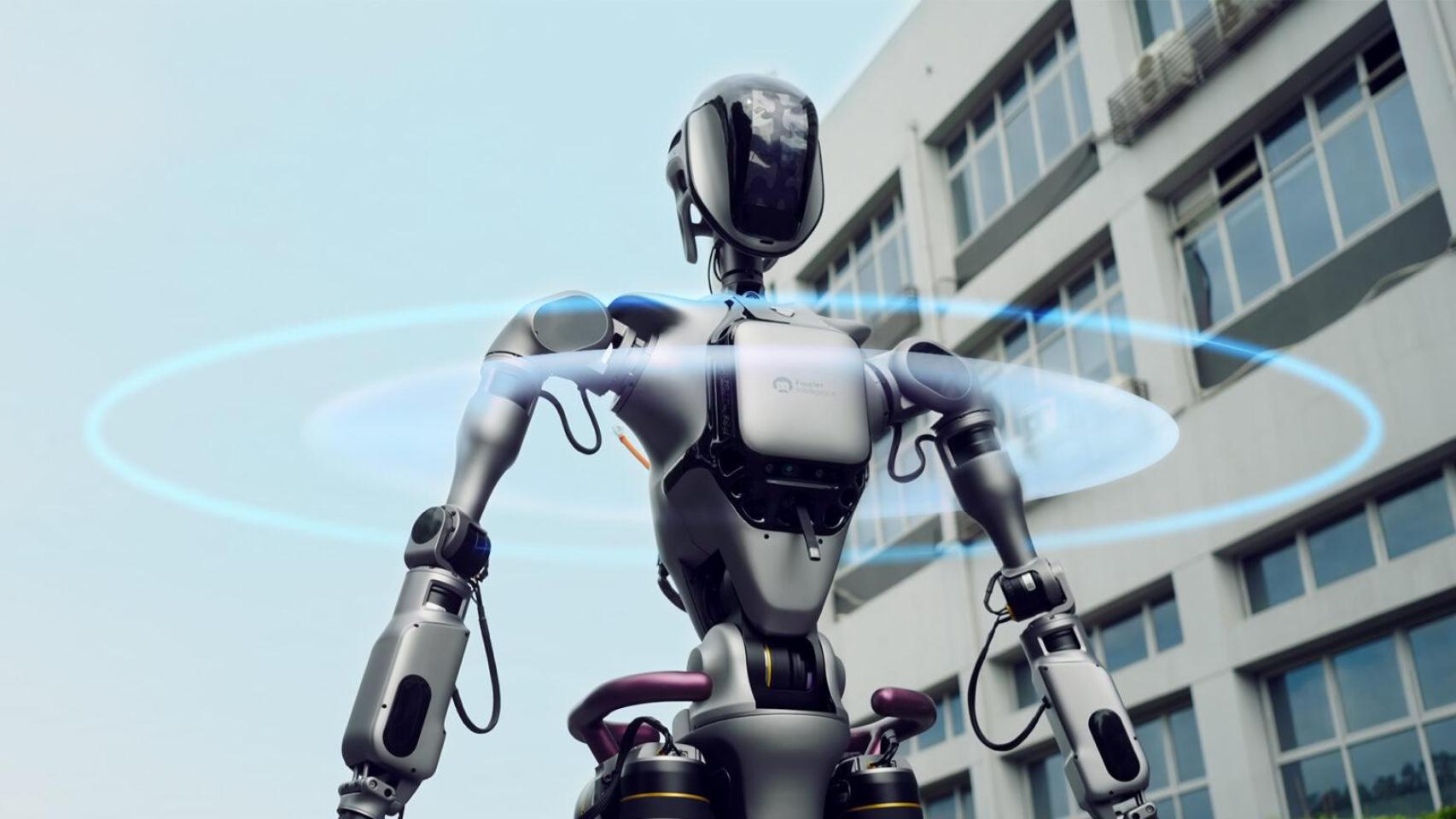

La compañía de Singapur, Fourier Intelligence, ha anunciado una importante actualización para su robot humanoide GR-1. Presentado en el último cuatrimestre del 2023, esta máquina con forma humana puede transportar hasta 50 kilogramos de peso gracias a sus dos piernas robóticas y los dos actuadores que las conectan a su cadena de 300 Nm.

La fortaleza principal estaría en la parte baja del cuerpo, pues el robot se espera que sirva como asistente en terapias de rehabilitación. Sus brazos, más ligeros, sostendrán a las personas por la cintura para ayudarlas a levantarse de las sillas de ruedas o la cama. Pero no solo deben tener habilidades físicas, sino también comprender su entorno y el mundo que les rodea.

Sistema de visión del robot GR-1

Casi un año después, el GR-1 ahora tiene ojos, los ingenieros de esta empresa han integrado en el robot seis cámaras RGB que cubren 360 grados para poder observar todo el mundo que le rodea sin tener que girarse. Esta configuración permite al robot detectar de forma integral el entorno desde todos los ángulos, incluidas las vistas frontal, lateral y trasera, y generar imágenes BEV para una identificación y un seguimiento precisos. Tras ese equipo, la inteligencia artificial ejerce de cerebro para interpretar las imágenes y tomar decisiones.

Esta nueva tecnología le permite generar un mapa utilizando los datos de las cámaras y una red neuronal que aprende con cada situación para generar y comprender las características espaciales 3D de los objetos. De esta forma, el robot no necesita sensores LIDAR para entender el relieve de las imágenes que recibe, como ocurre en otras máquinas, desde robots, hasta vehículos autónomos.

Mapeado del entorno realizado por la IA de GR-1

Además de poder ver las calles, coches y edificios entre los que camina, el robot recurre a otros elementos robóticos para crear un mapa tridimensional desde el aire. Con imágenes de vehículos aéreos no tripulados, o drones, el GR-1 es capaz de elaborar con su sistema de visión esférico una recreación del entorno a vista de pájaro, como explica la empresa en el comunicado.

"Con nuestra solución de visión pura, GR-1 está preparado para desempeñar un papel fundamental en diversas aplicaciones, como rehabilitación médica, servicios familiares, recepción y orientación, inspección de seguridad, rescate de emergencia y fabricación industrial" explica Roger Cai, director de investigación y desarrollo de aplicaciones robóticas de la compañía.

Visión 3D de GR-1

Aparte de su nueva visión, GR-1 cuenta con un par máximo de articulación de 230 N.m. y puede mover todas sus extremidades de forma parecida a la de una persona, incluso manipular objetos delicados como un vaso lleno y transportarlo sin derramar el líquido. Un algoritmo también se encarga del equilibrio.