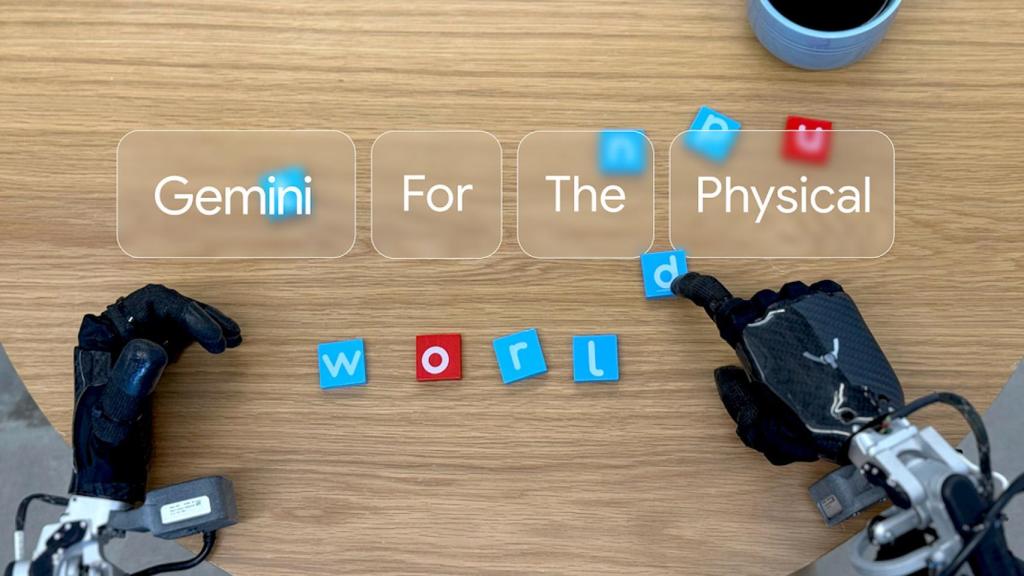

La idea es llevar a Gemini a un plano físico. Omicrono

Llega Gemini Robotics, la nueva IA de Google para controlar robots de forma directa incorporando acciones físicas

Los nuevos modelos de su división DeepMind intentan llevar la inteligencia artificial a un plano más físico, lejos de los entornos digitales.

Más información: La nueva IA de OpenAI desafía a los grandes escritores: el 'padre' de ChatGPT se sorprende de su capacidad literaria

La revolución de la inteligencia artificial, al menos respecto a Google, pasa por Gemini. Sus modelos más recientes de IA, incluyendo Gemini 2.0, rivaliza directamente con otras iniciativas; sin ir más lejos y tras el anuncio del retraso de su nueva Siri, Google actualizó su IA en el iPhone para ofrecer nuevas funciones avanzadas en España. Ahora, la gran G se fija directamente en la robótica presentando Gemini Robotics, su nuevo modelo de inteligencia artificial basado en Gemini 2.0.

Ha sido Google DeepMind, la división de investigación y desarrollo de inteligencia artificial la que ha anunciado dos nuevos modelos basados en este concepto: Gemini Robotics, destinado a incorporar acciones físicas para controlar de forma directa a los robots y Gemini Robotics-ER, un modelo con comprensión espacial avanzada, para que los expertos en este campo puedan ejecutar sus propios programas usando las capacidades de razonamiento incorporado de Gemini.

La idea, al menos sobre el papel, es sencilla: que los robots que incorporen Gemini Robotics puedan ampliar enormemente sus capacidades en diversos campos y situaciones. Mientras que el primer modelo se encarga de resolver una amplísima variedad de tareas para con los robots (tareas, de hecho, nunca vistas en los entrenamientos de estos dispositivos), el segundo permite mejorar la comprensión del mundo de Gemini con el razonamiento espacial, según Google, "mejorando considerablemente las capacidades existentes de Gemini 2.0".

Gemini Robotics, la IA para robots

Desde DeepMind explican un hecho inamovible; la IA se ha ceñido casi en su totalidad a entornos purament digitales, sobre todo en los proyectos más famosos como serían ChatGPT o DeepSeek. La cosa cambia enormemente cuando hablamos del mundo físico, donde se requiere que la IA pueda demostrar una capacidad conocida como razonamiento 'corporizado'. Esta característica se podría comparar con la capacidad humana de comprender y reaccionar a nuestro entorno y así lograr resultados; el objetivo es replicar esto en un robot convencional.

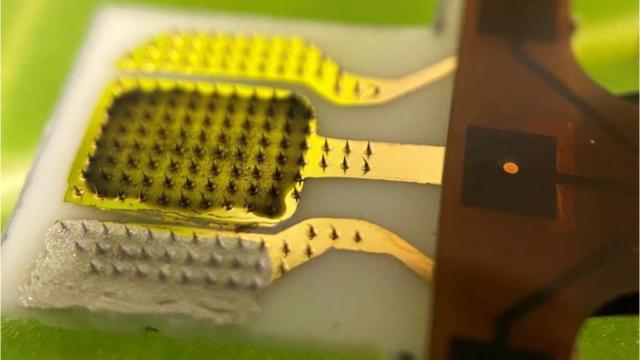

Gemini Robotics nace precisamente de esta idea. El primero de los dos modelos es un modelo avanzado de visión, lenguaje y acción (VLA) que usa Gemini 2.0 como base principal. La novedad reside en las acciones físicas como nueva modalidad de salida, lo que permite que se puedan controlar robots con esta idea. Las claves de Robotics se dividen en varias características, que van desde la interactividad hasta la destreza, pasando por la capacidad de este modelo de adaptarse a distintas situaciones.

Astribot S1 cocinando. Omicrono

Para la cuestión general, el modelo se aprovecha de la comprensión del mundo para "generalizar a situaciones novedosas" y así abarcar tareas de muchos campos distintos, incluyendo algunas que no se habían tratado antes en los entrenamientos de los robots. De hecho, Gemini Robotics también permite al robot manejar nuevos objetos, adaptarse a nuevos entornos y seguir varios rangos de instrucciones bien diferenciados. De esta forma, Google promete que Gemini Robotics duplica su rendimiento en comparación con otros modelos VAL.

Eso refiere específicamente a la capacidad de Gemini Robotics de ser general y adaptarse a estas situaciones. En el plano de la interactividad, Gemini Robotics usa sus funciones de comprensión del lenguaje para no solo comprender comandos expresados en lenguaje cotidiano, sino responder a ellos en varios idiomas. "Puede comprender y responder a un conjunto mucho más amplio de instrucciones en lenguaje natural que nuestros modelos anteriores, adaptando su comportamiento a la información recibida", expone DeepMind.

Además de ello, Robotics se encarga de monitorear constantemente el entorno, para detectar sucesivos cambios en él (o recibir nuevas instrucciones) para ajustar sus futuras acciones en consecuencia. Por ejemplo, si al robot se le escapa de las manos un objeto o alguien mueve un elemento concreto, Robotics planifica otra vez la situación y se adapta a ella.

Por último está la destreza. Es imposible equiparar la destreza humana para llevar a cabo ciertas acciones que requieren habilidades motoras muy precisas con las de los robots; en este sentido, algunas acciones muy concretas pueden ser muy difíciles o directamente imposibles para los robots. Robotics soluciona eso; Google DeepMind abre la puerta a situaciones como meter un bocata en una bolsa con un cierre en zip o doblar un papel para hacer origami.

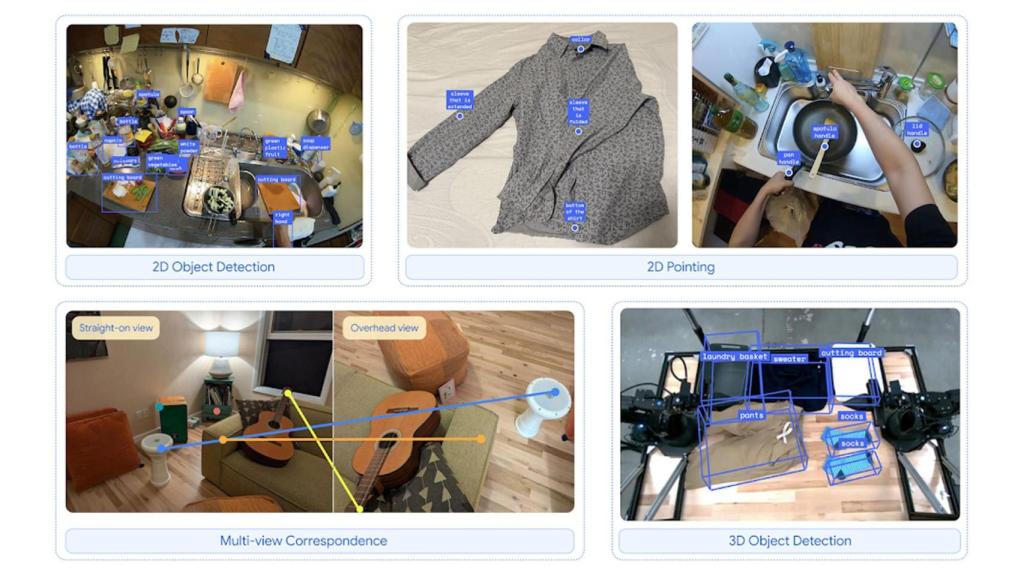

Google Robotics-ER, su segundo modelo

Junto al primer modelo DeepMind ha dado a conocer su variante Gemini Robotics-ER, cuya abreviación refiere al concepto del razonamiento incorporado. Algunas de sus virtudes incluyen importantes mejoras sobre Gemini 2.0 en áreas clave, como la detección 3D o las capacidades de apuntar de los robots. Combinando este razonamiento espacial con las capacidades de programación de Gemini, Robotics-ER abre la puerta a la implementación de funciones completamente nuevas sobre la marcha.

Capacidades de razonamiento de Gemini Robotics-ER. Omicrono

Un ejemplo de esto, puesto por la misma Google, imagina a un usuario mostrándole una taza de café a Robotics-ER. Al verlo, el modelo puede 'intuir' el agarre más adecuado para sujetar la taza, como usar dos dedos para coger el asa y definir una trayectoria segura para acercarse a ella. Una idea que para un humano sería casi automática, pero que presenta numerosísimas variables a tener en cuenta para un robot. Robotics-ER permite al robot razonar de forma espacial y permitir al robot comprender esta situación.

El propio modelo puede abarcar todos los pasos necesarios para controlar un robot de primeras; estimación de estado, percepción, comprensión espacial, planificación y generación de código. Google habla de una tasa de éxito del doble o incluso el triple respecto a Gemini 2.0 en su versión más estándar.

"Y cuando la generación de código no es suficiente, Gemini Robotics-ER puede aprovechar el potencial del aprendizaje en contexto, siguiendo los patrones de unas pocas demostraciones humanas para ofrecer una solución", expone Google.