ChatGPT Omicrono

OpenAI quiere proteger las funciones más avanzadas de ChatGPT: planea pedir el DNI para usar su API

Como medida contra los malos usos o posible robo de su tecnología, OpenAI está planteando un nuevo sistema de verificación con documentos oficiales.

Más información: Así es MiDNI, la app oficial que va a sustituir a tu DNI y que exigirá este paso previo para poder usarla en tu móvil

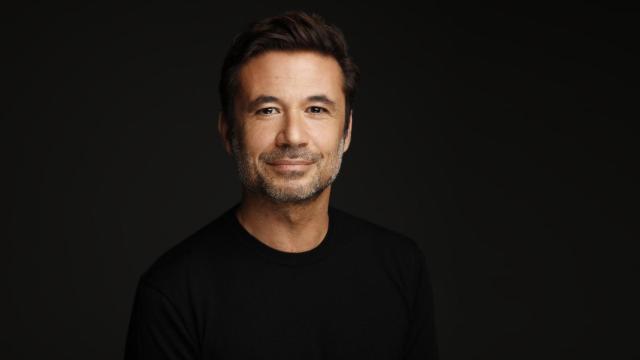

El CEO de OpenAI, 'padre' de ChatGPT, Sam Altman ha abogado por una mayor seguridad en internet con proyectos, un tanto polémicos, como los orbes de Worldcoin, con los que estandarizar la identificación de los usuarios en la gran red de redes. Ahora OpenAI abraza el uso de documentación oficial de cientos de países para proteger su propia tecnología, sus grandes modelos de inteligencia artificial generativa.

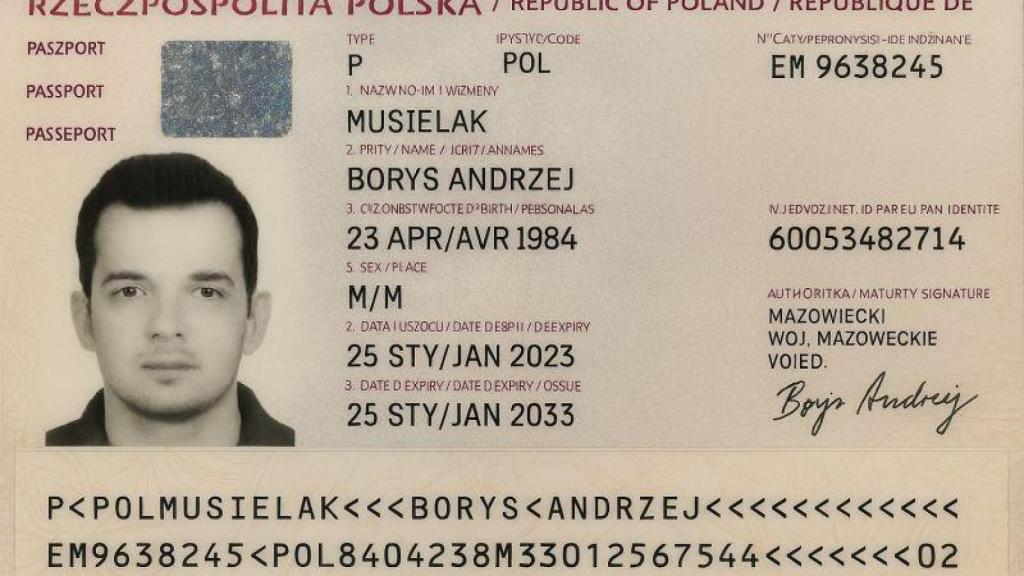

En una entrada de su página de soporte, OpenAI describe lo que llama "Organización verificada", un sistema para que los desarrolladores desbloqueen el acceso a los modelos y capacidades más avanzados, pero identificándose primero. Aquellos que quieran tener acceso a lo más preciado de la empresa, su API, deberán identificarse con un documento oficial.

"En OpenAI, nos tomamos muy en serio nuestra responsabilidad de garantizar que la IA sea ampliamente accesible y se use de forma segura" afirman. "Desafortunadamente, una pequeña minoría de desarrolladores usa intencionalmente las API de OpenAI, infringiendo nuestras políticas de uso", añaden como explicación a esta nueva medida de control.

Para identificarse, la empresa solo reclama un documento de identidad emitido por el gobierno. OpenAI asegura que admite los sistemas de verificación de más de 200 países, aunque no indica de cuáles se tratan: "la mejor manera de comprobar si tu país es compatible es iniciar el proceso de verificación". Eso sí, como límite solo es posible identificarse con ese documento en una organización cada 90 días. Miles de empresas ya aplican la tecnología de OpenAI en aplicaciones o servicios propios y requieren cuentas de desarrollador para ello.

Por el momento, parece que esta medida solo se aplica a los desarrolladores que quieran acceder a la inteligencia artificial más avanzada de la compañía. Son la primera trinchera en poner a prueba lo desarrollado por la empresa impulsada por Sam Altman, pero esas mismas funciones llegan con el tiempo al resto del público que accede de forma gratuita a los modelos generativos con ChatGPT o Sora y que, por ahora, no tendrán que identificarse.

Cuando OpenAI hace referencia a un uso ilegal o malicioso de su tecnología, no solo se refiere a la creación de imágenes falsas, sino a la utilización de la IA como herramienta para el cibercrimen. La empresa ha publicado en los últimos años informes sobre su labor para detectar y mitigar el uso de sus modelos por parte de grupos de cibercriminales organizados, por ejemplo, de Corea del Norte. Estas bandas utilizan la IA para acelerar el trabajo de construcción de campañas de piratería informática o contenido falso que distribuir por internet.

Por otro lado, OpenAI se planteó el año pasado bloquear el acceso a su API a usuarios de China, tal y como informó Reuters. Un artículo de Bloomberg informaba a principios de año de la investigación de OpenAI hacia un grupo vinculado a DeepSeek por la posible extracción de grandes cantidades de datos a través de su API a finales de 2024, lo que habría servido para entrenar otros modelos. Recordar que la IA china de DeepSeek supuso un cataclismo el primer mes de 2025 contra las compañías desarrolladoras estadounidenses, desafiando su peso en esta nueva industria.