Que la inteligencia artificial ha llegado a nuestras vidas para quedarse es ya toda una realidad. De hecho, en las últimas semanas, la sociedad ha podido ser testigo —con el ‘boom’ de ChatGPT— de cómo una simple máquina es capaz de desarrollar actividades, a priori, únicamente propias del ser humano: hacer una pizza, resolver un examen de Selectividad o incluso inventarse una historia de amor.

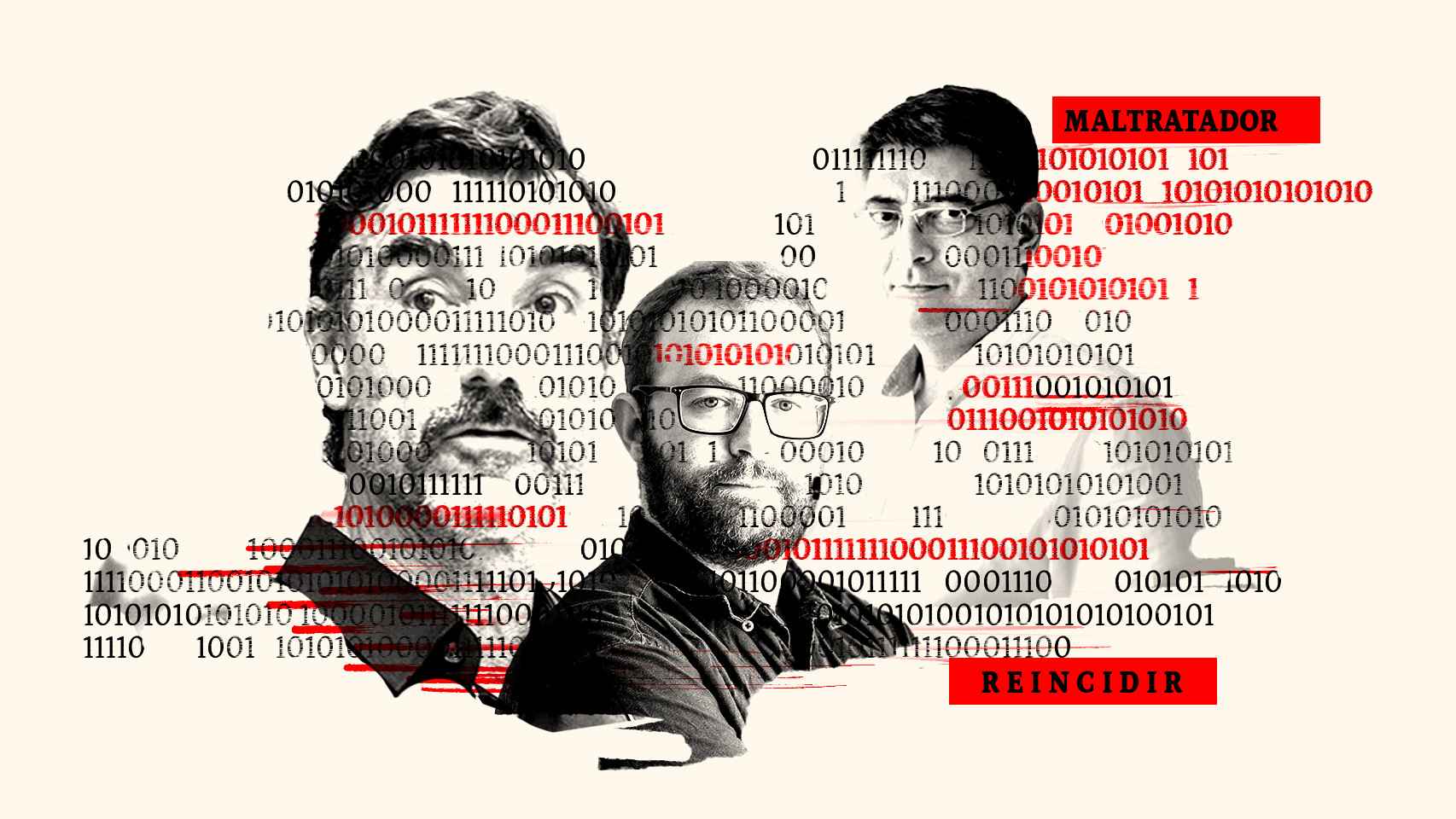

Pero la realidad es que estas combinaciones de algoritmos, que se presentan aún como grandes desconocidas para un importante sector de la población, podrían tener usos más que beneficiosos para el correcto funcionamiento de la sociedad actual. Es precisamente esa a la conclusión a la que han llegado tres investigadores españoles, en colaboración con el Ministerio de Interior, a través de su estudio ‘Métodos híbridos de aprendizaje automático para la evaluación de riesgos en delitos de género’. Ellos son Juan Carlos Nuño, profesor de la Universidad Politécnica de Madrid y Ángel González-Prieto y Antonio Brú, profesores de la Universidad Complutense de Madrid.

Y es que los resultados de su último estudio han arrojado que, gracias a un algoritmo de inteligencia artificial se podría predecir ahora el riesgo de reincidencia de un maltratador condenado por violencia de género. El estudio, que se ha llevado a cabo durante más de cuatro años, determina que esto sería posible únicamente con la utilización de datos y tecnología avanzada. De este modo, el algoritmo, llamado Nearest Centroid, podría evaluar y predecir el riesgo que tendría un agresor de volver a reincidir, basándose en la información existente sobre los casos de violencia machista recopilados en los últimos años.

El funcionamiento sería más que sencillo: el algoritmo, habiendo obtenido previamente las características y los perfiles de los agresores, establecería una serie de patrones comunes que le permitirían arrojar un dictamen sobre si el maltratador volverá a actuar o no.

Y no solo eso. El modelo propuesto por estos investigadores, según los resultados, podría mejorar hasta en un 25% la valoración de riesgo que realiza el actual sistema VioGén. Sin embargo, y a pesar de los buenos resultados, los propios investigadores inciden durante la entrevista con EL ESPAÑOL que no se trata de sustituir un sistema por otro, sino incorporarlo al actual y utilizarlo de forma complementaria para poder predecir los casos más complejos.

“No pretendemos mejorar el sistema. El sistema tiene una estructura que se le pueden enganchar diferentes métodos, algoritmos y formas de proceder para conseguir hacer una valoración de riesgo. Proponemos una herramienta alternativa que complemente, no que sustituya al que existe, y que se transite de uno a otro en función de las mejoras que se obtengan. Proponemos avanzar para mejorar, pero no significa rechazar lo que se ha hecho hasta ahora”, explica Juan Carlos Nuño, uno de los investigadores del estudio.

Para que lo entienda todo el mundo, el algoritmo simula lo que haría un ser humano a la hora de clasificar. “Un humano cuando intenta coger un caso de delincuencia e intenta ver si va a volver a ocurrir o no, mira los otros casos que conoce. Al final, decide cuáles son los casos más similares, mira qué pasó y extrapola el resultado al caso que quiere predecir. Nuestro sistema hace lo mismo, aprende patrones”, asegura Ángel.

El matemático José Ángel González-Prieto, Premio de Matemáticas Vicent Caselles 2021.

Por ello, el sistema se basa en la comparación de todos los casos de los que tiene información con el fin de determinar cuáles son más similares y distintos y, en base a ello, ofrecer una predicción. Pero eso sí, siendo capaz de llegar mucho más allá de lo que podrían analizar los mortales. “Lo interesante es que la diferencia respecto al humano es que la capacidad del humano para comparar con datos es limitada. Sin embargo, este sistema puede compararlo con todos los casos de la base de datos y así encontrar patrones escondidos para el especialista”, explican.

Pero para poder llegar a ese punto, era crucial la obtención de dichos datos. Y no fue hasta que el Ministerio no ofreció a los investigadores los recursos necesarios cuando pudo materializarse el estudio. Los datos ofrecidos tan solo corresponden a un periodo de tiempo de aproximadamente un año y medio, cifrado en 2016 y 2017, y han sido precisamente sobre ellos sobre los que se han aplicado las técnicas necesarias para poder evaluar el riesgo de reincidencia de los maltratadores.

“Es muy interesante porque es muy similar a lo que hace la Policía. La Policía lo que busca es perfilación criminal. Es decir, tener un registro de cuál es el arquetipo del delincuente que reincide: tiene estas características psicológicas, económicas, sociales. Nuestro sistema hace eso, extrae los patrones, extrae los arquetipos y cada vez que nos llega un nuevo caso mira a cuáles se parece más y a cuáles se parece menos”, afirma Ángel durante la entrevista.

Así funciona VioGén

El sistema de seguimiento integral de los casos de violencia de género (VioGén) fue creado en el año 2007 por la Secretaría de Estado de Igualdad. Desde entonces, ha recopilado información de casi 709.000 casos y ha evaluado el riesgo de más de 633.000 mujeres víctimas de violencia machista. Es desde el propio Ministerio de Interior y a través de las Fuerzas y Cuerpos de Seguridad del Estado cómo se analiza la valoración de riesgo de cada uno de los casos.

En la actualidad, cuando se interpone una denuncia por malos tratos, los agentes rellenan una ficha respondiendo 40 preguntas a través de las cuales se evalúa el posible riesgo. Con la información ya recopilada, el sistema asigna un nivel de riesgo de reincidencia y, con él, se establecerá la protección adecuada para la víctima. A la información almacenada en la base de datos de VioGén se le pueden asignar cinco posibles niveles: no apreciado, bajo, medio, alto y extremo.

El nivel de riesgo se puede modificar en aquellos casos en los que las autoridades lo consideren necesario. Sin embargo, el resultado inicial debe comunicarse al juzgado y al fiscal por medio de un informe automatizado que se incluye en el atestado policial. Pero a pesar de que, con el paso de los años, se ha demostrado que el sistema funciona, la inclusión de la inteligencia artificial a modo complementario podría servir para abordar los casos más complejos.

La comisaría principal del sistema VioGen, María Jesús Cantos Cebrián

“La idea es ofrecer un informe en minoría respecto al actual sistema VioGén. Así, lo que proponemos es montar un sistema que actúe como una voz discordante. Una opinión en minoría que en la mayoría de las veces confirma que coincide con la predicción del actual sistema VioGén. Pero podrá ocurrir que en ocasiones salte una alarma y que crea que la clasificación podría ser otra. A lo mejor es interesante para que a la gente de Policía que está comprobando este caso le salte una alarma que le diga que el sistema en minoría disiente de esa predicción y que analice el caso con más cuidado. Ahí podrá prestar atención a ese caso porque parece que no hay acuerdo entre los sistemas de predicción. Eso es relevante”, explica Ángel.

Los casos analizados a través del algoritmo han demostrado que, con su uso, se podría mejorar sensiblemente la valoración que realiza el actual sistema VioGén. Sin embargo, hasta que no se llevase a cabo la implementación completa dentro del sistema, tan solo se trataría de una “previsión a futuro”. “Al igual que las vacunas no se inyectan hasta que no pasa una fase clínica, lo mismo pasa con este sistema, hasta que no pase por una fase clínica en producción y se analice si mejora el resultado o no, no es posible aceptar con rotundidad que es necesario transicionar o combinar ambos sistemas”, señalan.

Aunque parezca algo completamente novedoso, otros investigadores ya han utilizado previamente estas técnicas en otras áreas como es el caso de la Medicina y la Sociología. Su funcionamiento es exactamente el mismo. Se trata de dotar información al sistema con datos —en este caso sobre los diferentes tipos de enfermedades y cómo se han ido desarrollando— para que el algoritmo establezca patrones comunes y pueda hacer un diagnóstico final.

“Realmente el objetivo final es el mismo, valorar el riesgo. Si es capaz de clasificar el perfil de un tumor sólido que está creciendo y es capaz de clasificarlo, va a ser capaz de valorar el riesgo y decidir terapias”, explica Juan Carlos.

Un sistema muy presente

La inteligencia artificial y los algoritmos forman ya parte de nuestro día a día. Desde las recomendaciones de amigos que nos muestra Facebook, la ruta recomendada por Google Maps o las sugerencias de Amazon a la hora de realizar compras. Vivimos con ellos, aunque muchos todavía no sean conscientes de ello. Y a pesar de que España por el momento no ha alcanzado el nivel de otros países anglosajones como Estados Unidos o Inglaterra, lo cierto es que en estos territorios la inteligencia artificial es una herramienta básica en algunos sectores como la lucha contra la criminalidad.

Uno de los mapas que señalan lugares de alta criminalidad con una semana de antelación.

“En megaurbes como Los Ángeles o Nueva York está implementado. Lo que hace es que hay un sistema que se retroalimenta diariamente para localizar los lugares de criminalidad, donde han ocurrido cosas. Hay bastante actividad callejera, más que en España y este tipo de herramientas se utilizan diariamente. El oficial encargado, además de consultar con sus oficiales, también echa un ojo a las predicciones de maquina inteligente para tomar una decisión”, explica Juan Carlos.

Por ello, consideran completamente necesaria la implementación de estos sistemas en las Fuerzas y Cuerpos de Seguridad del Estado aunque, tal y como aseguran, en algunos casos ya se utilizan. “El uso de este tipo de técnicas de inteligencia artificial, de aprendizaje automático, en el caso de la criminalidad, debería estar extendido. España no tiene una tradición como tienen países anglosajones de aplicación de ciencia fundamentada y basada en el método científico al comportamiento humano. Al final la ciencia tiene que aliarse a las Fuerzas y Cuerpos de Seguridad del Estado y yo creo que la sociedad saldría beneficiada”, confiesa.

Los riesgos de la IA

En nuestro día a día, son cientos los sistemas de inteligencia artificial que utilizamos. Y es que, tal y como explica el propio Ángel, aunque algunas personas se resistan a aceptar su inclusión en la vida cotidiana. "Las mejoras científicas son objetivas. La ciencia es ciencia y es inapelable", añade. Por eso, no considera argumentos lógicos aquellos utilizados por el sector de la sociedad que no confía aún en la puesta en marcha de dichas técnicas.

“¿Se deberían utilizar las nuevas técnicas científicas para mejorar la vida de la gente? Es que es un deber. Nuestro deber como científicos es crear nuevas herramientas para mejorar la vida de la sociedad, ya sea gente que se dedica a cuestiones aplicadas a corto plazo o cuestiones mucho más teóricas en el medio o largo plazo. Pero es el late motiv de la investigación científica. Otra cosa es que se advierta de los peligros de la IA, que los hay y son muchos o del cuidado que hay que tener en el tratamiento de los datos”, explica.

— ¿Y cuáles son esos peligros?

— Uno de los riesgos muy obvios no tiene que ver tanto con la IA sino con las personas que la usan. Cuando tú quieres procesar los datos de Facebook para hacer recomendaciones de amigos es totalmente legítimo. Cuando coges esos datos y los utilizas para manipular las elecciones presidenciales, estás haciendo un uso fraudulento. No los estás usando para el motivo que fueron recopilados. Otro riesgo es la suplantación de la identidad. A día de hoy si tú hablas con ChatGPT es muy difícil saber si estás hablando con una persona que está detrás tecleando o realmente con IA. No son riesgo de las tecnologías, sino de los usos que quieras hacer.

Inteligencia artificial.

Negociaciones con el ministerio

Los primeros trabajos de los investigadores en el proyecto se remontan al año 2019, cuando se iniciaron las primeras investigaciones. Sin embargo, el grueso de los experimentos se lanzó justo durante los meses de cuarentena. “Me acuerdo perfectamente que estábamos encerrados en casa. Eran las tres de la mañana y revisaba si habían salido resultados o no, volvía a ponerlos en el ordenador, hacía algunos ajustes”, cuenta Ángel.

Y es que para llegar a los resultados obtenidos en la actualidad, el camino no ha sido nada fácil. “Un sistema de inteligencia artificial no aprende de la nada, no es omnisciente. Le vas enseñando patrones y eso requiere mucho tiempo y mucho esfuerzo computacional”, comenta. Un esfuerzo que, ahora, espera que pueda materializarse con la adherencia del algoritmo al sistema VioGén.

“Todos nuestros contactos con las instituciones son para llamarles la atención de lo interesante que es incluir en sus proyectos estos estudios”, explica Juan Carlos. Y a pesar de que son conscientes de la dificultad de conseguir financiación para implementar este tipo de proyectos, esperan que finalmente salga adelante y que el algoritmo se pueda seguir desarrollando dentro del sistema. “El siguiente paso sería introducirlo en el sistema, aunque no prediga. Simplemente para monitorizarlo y verlo en tiempo real y en una situación realista a ver si funciona”.