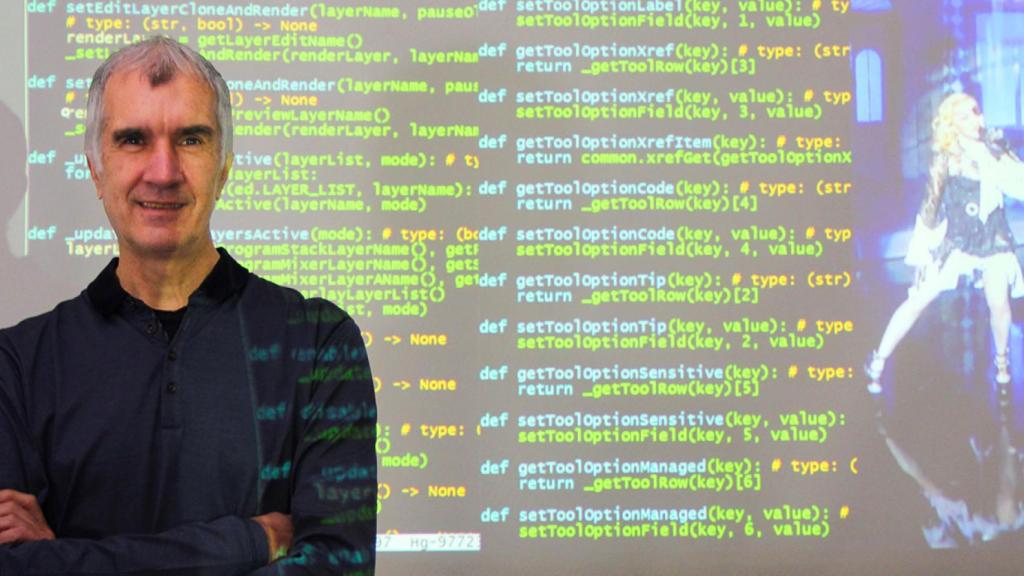

Ricardo Montesa, fundador y director de la valenciana Brainstom3D.

Realidad aumentada en vivo: ‘teletransporte’ en 5G y clones de Madonna

La tecnología de la compañía española Brainstorm crea versiones virtuales de la Reina del Pop durante su concierto en los últimos Billboard Music Awards en Las Vegasrn

30 diciembre, 2019 07:00El marco donde ocurre la realidad aumentada es una pantalla. Fuera de las pantallas no puede manifestarse, al menos hasta ahora. Así ocurrió en la Ceremonia de Apertura de los últimos Juegos Olímpicos de Invierno en Corea del Sur en cuya retransmisión los espectadores veían un espectacular y brillante cielo estrellado posado encima mismo del gran estadio. Era un espejismo digital integrado en la emisión. Se veía en las pantallas en calidad 4K gracias a la tecnología Infinity Set de realidad aumentada hiperrealista de la española Brainstorm.

Igual ha sucedido en la última y espectacular entrega de los Billboard Music Awards, cuyo plato fuerte fue la actuación de Madonna y el cantante Maluma. En una plasmación literal de la capacidad de lo digital para fabricar múltiples identidades en forma de avatars, la tecnología Infinty Set hacía surgir en las pantallas en tiempo real hasta cuatro alter ego de Madonna con distinta apariencia, vestido, movimientos y voz propia, indistinguibles de la cantante ‘física’, sobre el gigantesco escenario del MGM Garden Arena, ante 15.000 personas, en pleno corazón de Las Vegas.

Ricardo Montesa, fundador y director de Brainstom3D, está acostumbrado desde hace tiempo a cosas extraordinarias. Con su tecnología se han rodado películas tan conocidas como Inteligencia Artificial de Steven Spielberg y ha servido gráficos dinámicos en tiempo real tanto al inmenso muro digital del Nasdaq en Manhattan, como a la cadena CNBC en la noche electoral de la elección presidencial de Barack Obama. Brainstorm también ha ‘teletransportado’ a periodistas deportivos entre estadios y platós de TV, pero nunca hasta ahora había superpuesto y hecho bailar a clones digitales hiperrealistas.

En los Billboard Music Awards, Brainstorm creó una capa sobre el Unreal Engine, un potentísimo motor de gráficos y recursos digitales creado para ciberjuegos de alto nivel por una de las principales empresas de industria mundial de los videojuegos llamada Epic Games. Es tal su capacidad que la compañía, que lo creó con software libre, lo está licenciando para los nuevos campos de la realidad virtual inmersiva. La interfaz de Brainstorm, contratada para el evento por la productora Sequin AR, "es una capa conceptual: el Unreal genera eventos de gráficos en movimiento y nosotros leemos con la señal de CDI, sensores, el tracking y posicionamiento de las cámaras, el código de tiempo, controlamos y hacemos que cada cosa suceda en su momento y en su sitio".

Versiones hiperreales

Hasta ahora habíamos visto escenarios tridimensionales en los que había imágenes planas. Pero estos clones de Madonna no son vídeos planos de ella, son ‘versiones’ tridimensionales que bailan al mismo tiempo en el mismo escenario, ‘conviven’ digitalmente con ella y cantan con sus ‘otras’ voces fragmentos de la misma canción de forma superpuesta... en directo.

"Esos clones de Madonna ya están previamente calculados y renderizados. Sequin AR ya había encargado que se digitalizase tridimensionalmente a la Madonna virtual, cada una vestida diferente. Eso se hizo en un estudio de Londres, donde se la escaneó en tres dimensiones y en movimiento. Pensaron que nuestra tecnología Infinity Set que se usa para emisión broadcast (en vivo), podría conseguir que el Unreal Engine se comporte en modo broadcast, ya que era necesario que funcionara en directo y en tiempo real".

Montesa explica cuál es el salto tecnológico que se ha dado en este ámbito. "Al usar los nuevos motores gráficos de videojuegos se crean imágenes que parecen tan reales como las de una filmación de una cámara en vivo, en cuanto a colores, texturas e iluminación y sombras, sobre todo, y la gente lo ve en su televisor como si lo fueran". Con esta tecnología, ¿alguien podría en un telediario emitir como reales cosas que no lo son? "Claro", responde, "la realidad aumentada es ficticia. Son objetos 3D y con ellos puedes representar lo que quieras, personas repetidas o inventadas".Suena peligroso. "Claro que lo es. Igual que las fake news hechas para engañar". La clave es que la imagen virtual se emite en vivo, no grabada.

¿Cree Montesa que hay que dejar que los propios medios de comunicación se autorregulen en esto? "Cuando empezamos", explica, "en los primeros programas A3TV ponían un logo en la emisión diciendo que el fondo no era real, para que los espectadores lo supiesen y no se sintiesen engañados. Ahora a nadie se lo que ocurre poner un aviso así".

Podremos tener como presentadores de los telediarios a avatares virtuales hiperrealistas que no se distingan de las personas de carne y hueso. "La gente tendrá que aprender. Cuando eso llegue, que llegará, estarás interactuando a través de la pantalla con una ‘persona’ que no es real. Lo que tienes que saber es que por la pantalla te pueden estar contando mentiras".

Javier Montesa es coordinador técnico de proyectos de I+D en Brainstorm. Junto con el responsable de I+D Francisco Ibáñez y el propio Ricardo Montesa, impulsan la investigación de frontera. El proyecto PRESENT, explica el primero, "es una iniciativa a tres años, en colaboración con la UPF y empresas como Framestore, Cubic Motion y otras, y tiene que ver con la fusión de dos tecnologías que están evolucionando muy rápido: la realidad aumentada y los asistentes virtuales, como Google Assistent, Alexa o Siri. Nuestro objetivo no es solo interactuar con lenguaje natural sino corpórea y visualmente, es decir, con identidad visual. Le vas a poder hacer preguntas y él podrá atender autónomamente al público por ejemplo en un museo, un aeropuerto, o usar en un programa de TV».

Teletransportación

Otro ejemplo de I+D de vanguardia en el que está involucrado Brainstorm es TelePorter (Sistema de Teletransporte de Realidad Aumentada para un Periodismo de Noticias Inmersivo), que presentó a la sexta ronda europea de financiación del programa Google Digital News Innovation Fund (Google DNI), cuya reunión tuvo lugar, por primera vez en España, en Valencia.

"En un set virtual de TV, lo que tienes básicamente para producir noticias audiovisuales es un ciclorama (el fondo verde), una cámara o más, iluminación, un ordenador de realización, y un integrador o incrustador de la silueta del presentador, todo en un mismo recinto. Pretendemos que no sean necesarios para extraer la silueta, que funcione con un teléfono inteligente o una tablet y, así, hacerlo ubicuo".

De ese modo se consigue que el presentador del telediario y el reportero que esté en el lugar de la noticia compartan escena con ‘teletransportación’. El proyecto se llama TelePorter por ello. "Nuestra intención es ‘traernos’ virtualmente al reportero desde el lugar de la noticia, por ejemplo, en Afganistán, en donde ni siquiera tiene un fondo verde, e insertarlo dentro del set virtual o de la escena real dentro del estudio de TV".

Y hacerlo mediante la tecnología 5G. "Los nuevos smartphones ya tienen más de una cámara y controlan la profundidad el campo visual y, con ello, vamos a poder extraer la silueta del presentador sin necesidad de fondo verde. Aprovechando la baja latencia 5G que va a ser del orden de un milisegundo, las típicas esperas en las preguntas al reportero desaparecerán», explica Montesa. Con el TelePorter basta un periodista con su smartphone y un trípode para el teléfono.

"Y, además, de traernos al reportero al plató, con la misma tecnología, podré llevarme al presentador del programa de la liga de fútbol a cada estadio. Eso ya lo podemos hacer, pero es prohibitivo económicamente. El coste de producción cambia por completo simplemente usando la tecnología que estamos desarrollando. Será suficiente con que haya en el estadio un periodista con su smartphone con el TelePorter instalado".

Educación: profesores-avatar captan atención

Con Edison de Brainstorm, los profesores aparecen integrados en un entorno de realidad aumentada en la que manejan gráficos, esquemas y objetos tridimensionales que parecen corpóreos como flotando a su alrededor. "Cuando la presentamos en Japón, algunos profesores nos dijeron que preferían salir en pantalla como un personaje en 3D, o sea claramente ficticio, pero muy realista. Un profesor-avatar. En TV tienen muy claro que los gestos, gráficos, colores, influyen mucho en el mensaje. Éste es una parte, pero cómo lo das o transmites es muy importante para obtener y mantener la atención de las personas, y tiene un efecto en lo que en TV se llama ‘audiencia’. Ese mismo concepto de conseguir la atención y el interés debería ser muy importante en la educación", dice Montesa.