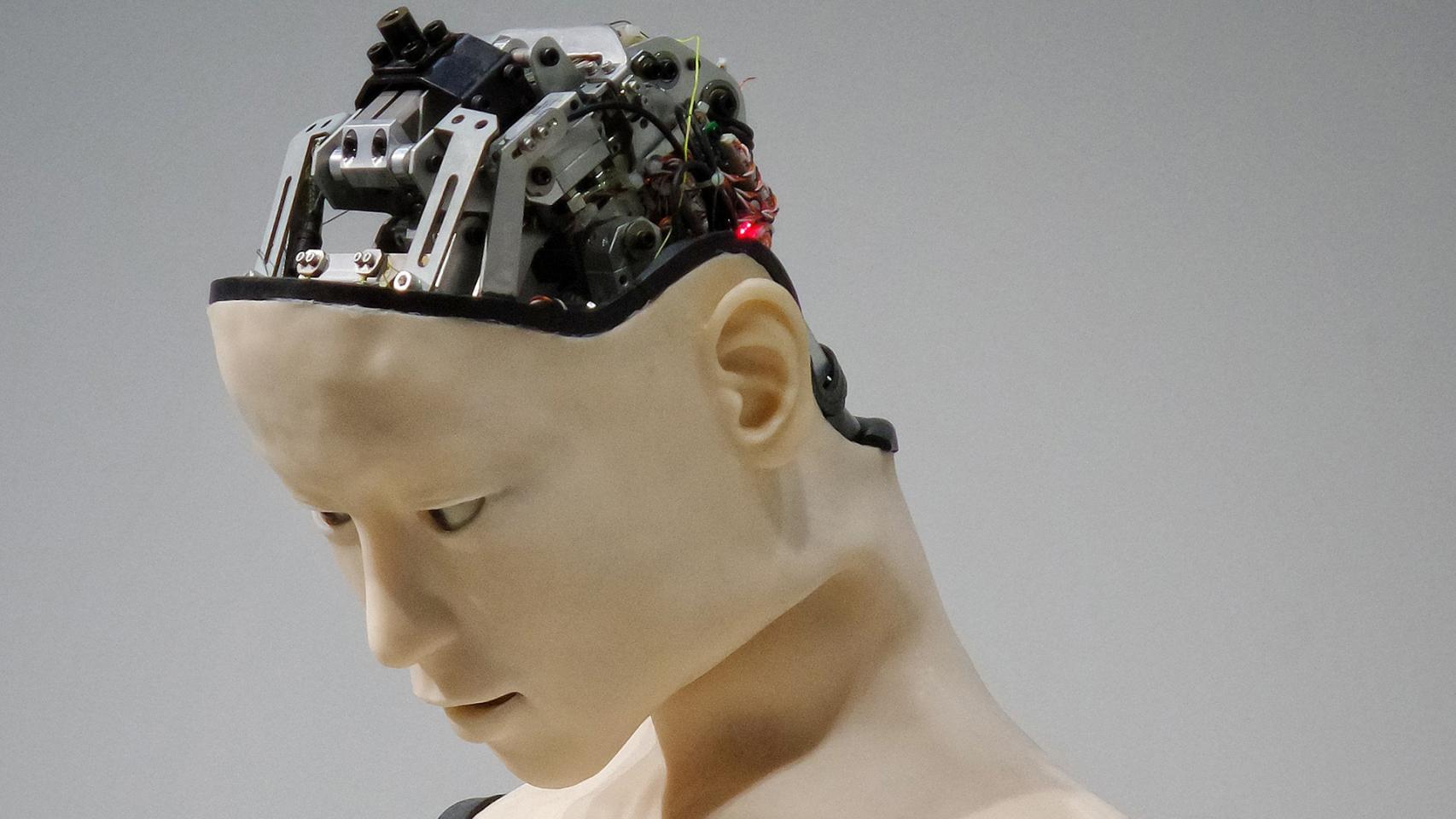

La imaginación del ser humano ha soñado en demasiadas ocasiones con un futuro post-apocalíptico repleto de robots asesinos. Puede sonar muy descabellado el pensar en un desastre de tales magnitudes, pero... ¿y por qué no? ¿Acaso es tan imposible como suena?

La advertencia la ha lanzado Laura Nolan, una ex-ingeniera de Google que trabajó en el proyecto de drones militares de la firma. En una entrevista en The Guardian la ingeniera lanza una advertencia concisa: "las armas robóticas podrían causar asesinatos en masa accidentales”.

En general, Nolan advierte que desarrollar armas robóticas o robots asesinos podría desembocar en asesinatos en masa "accidentales". Ha sido su experiencia la que la ha llevado a lanzar tal advertencia.

Robots asesinos: los causantes de asesinatos en masa "accidentales"

La ex-ingeniera de Google había estado trabajando unos 4 años para Google cuando fue reclutada para colaborar con el Departamento de Defensa de Estados Unidos en el proyecto Maven. Dicho proyecto, bastante conocido, tuvo como principal objetivo el usar la Inteligencia Artificial para mejorar drones militares.

El plan de Maven era construir sistemas de IA que fueran inteligentes y capaces de seleccionar objetivos enemigos distinguiendo entre personas y objetos. Esto causó indignación obviamente y el proyecto fue eliminado por la misma Google. Si bien su contrato expiró en marzo de este año, Nolan renunció al trabajo después de que se “preocupara cada vez más desde el punto de vista ético”.

"Aunque no participé directamente acelerando ese reconocimiento en vídeos, me di cuenta de que todavía era parte de la cadena de asesinatos, y que esto en última instancia conduciría a que más personas fueran atacadas y asesinadas por el ejército estadounidense en lugares como Afganistán. [...]".

La clave de la peligrosidad de estos proyectos reside en los factores impredecibles. Nolan asegura en The Guardian que muchos de estos factores podían interferir con los sistemas armamentísticos de forma imprevista; clima inestable, señales de radares erróneas o personas con armas que no pertenecen a la guerra, como un cazador. Nolan desliza en la entrevista que estas pruebas se tendrán que realizar en un campo de batalla.

"La otra cosa aterradora de estos sistemas de guerra autónomos es que solo se pueden probar realmente desplegándolos en una zona de combate real. Tal vez eso esté sucediendo con los rusos en Siria en este momento, ¿quién sabe? Lo que sí sabemos es que en la ONU Rusia se ha opuesto a cualquier tratado y mucho menos prohibir estas armas, por cierto”.

Lanzar la piedra y esconder la mano

Lo cierto es que no hay ninguna nación en estos momentos que haya dejado claro que está usando estas armas, y mucho menos desarrollándolas. Lo que sí está confirmado es que numerosos países están intentando mejorar sus IAs para que estas se integren en armamento bélico.

En Omicrono hemos hablado en varias ocasiones sobre armas de este estilo, y países como Israel han confirmado que tienen drones capaces de identificar y atacar a objetivos de forma totalmente autónoma. Como es esperable es en este momento en el que se necesita la intervención de un humano para confirmar el ataque, pero se sabe que el campo de batalla es incierto.

Finalmente, Nolan pide en el diario británico que tal y como se hiciera con las convenciones sobre armamentística nuclear se prohíban las armas letales autónomas con intención de matar. "Muy pocas personas están hablando de esto, pero si no tenemos cuidado con una o más de estas armas, estos robots asesinos, podrían iniciar accidentalmente una guerra repentina, destruir una estación de energía nuclear y causar atrocidades masivas".

Via | Business Insider.