iPhone 11

Apple cree que se ha malinterpretado su sistema contra la pornografía infantil

La compañía asegura que este sistema contra la pornografía infantil solo dará al año un falso positivo entre un billón y promete no vulnerar la privacidad de los usuarios.

Noticias relacionadas

Semanas después de hacerse público el nuevo sistema de Apple para luchar contra la pornografía infantil, la compañía sigue intentando aclarar cómo funciona esta tecnología, que de momento no llegará a España. Desde Apple se defienden de las críticas asegurando que se ha malinterpretado la información.

La comunidad de expertos en ciberseguridad, junto con personalidades de la industria tecnológica, ha manifestado su desacuerdo con la iniciativa de Apple. Más de 5.500 expertos han firmado una carta abierta en GitHub asegurando que esta medida supone una puerta trasera "que amenaza con socavar las protecciones de privacidad fundamentales ". Entre ellas está la firma de Edward Snowden.

Craig Federighi, vicepresidente de ingeniería de software de Apple, ha respondido a las críticas en una entrevista asegurando que la información se ha entendido mal. Un nuevo informe, además, proporciona nuevos detalles sobre el sistema para refutar las acusaciones sobre los falsos positivos que podría ocasionar la tecnología al analizar las fotos.

Buscando dentro del iPhone

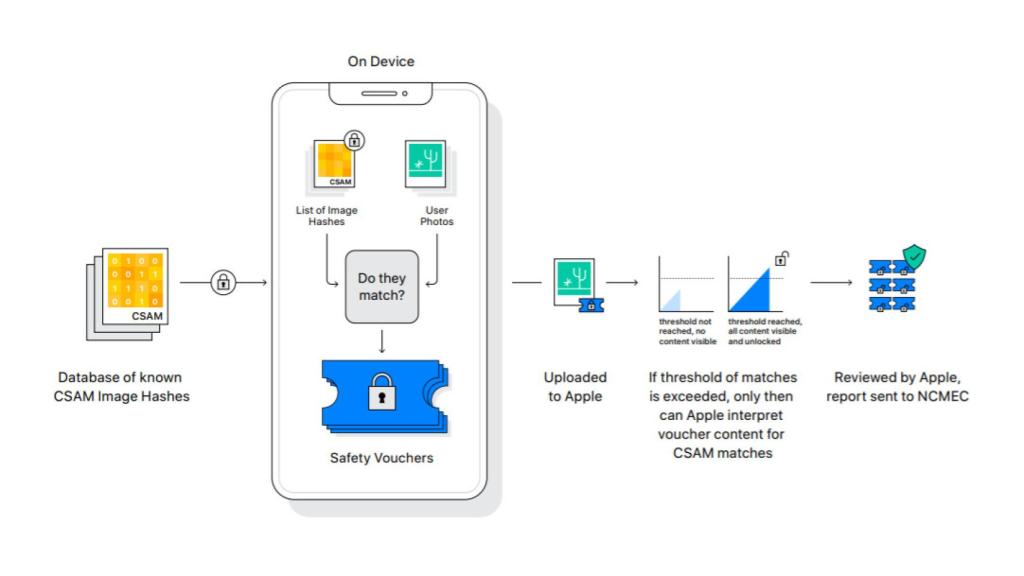

Apple quiere luchar contra la pornografía infantil en internet y para ello ha diseñado un sistema de algoritmos conocidos como Neural Hash. Estos algoritmos analizan las imágenes sin necesidad de visualizarlas o abrir el archivo. Convierten cada fotografía en un número único que describe su contenido, como una huella dactilar digital, pero que para cualquier usuario sería imposible de comprender.

Federighi señala al resto de gigantes tecnológicos al recordar que Google, Facebook y Microsoft también analizan las imágenes que los clientes suben a sus plataformas de almacenamiento en la nube en busca de pornografía infantil. Apple se había resistido hasta ahora a este escaneo, por lo que han tratado de diseñar otro método, un sistema que "sin mirar las fotos de las personas" encuentre coincidencias con las imágenes ilegales.

Apple tecnología hash Omicrono

La diferencia que ha provocado la polémica es que Apple ha trasladado ese escaneo al interior del teléfono que los usuarios consideran un espacio privado. "En su teléfono, cuando se cargan las imágenes en la biblioteca de iCloud, se realiza lo que se llama un hash neuronal en la imagen y se cruza con una base de datos que está en su dispositivo", explica Federighi.

Los códigos hash de las fotos se comparan con otros los códigos generados para las fotografías ilegales recopiladas por el Centro Nacional de Niños Desaparecidos y Explotados (NCMEC). La base de datos con esas huellas dactilares se instala en el teléfono con la actualización de este nuevo sistema en iOS para cotejar las fotos propias con las reconocidas como pornografía infantil.

"Lo que hacemos es buscar imágenes ilegales de pornografía infantil almacenadas en iCloud" explica en la entrevista a Wall Street Journal. Al intentar subir esas fotos del dispositivo a la nube, si el sistema determina que hay una coincidencia clara entre los neural hash y se trata de una imagen ilegal, la cuenta del usuario se desactivará y el contenido se entregará al NCMEC en los EEUU.

Falsos positivos

Aquí es donde entra el miedo de muchos usuarios y voces críticas con Apple, creen que el sistema podría dar falsos positivos y acusar de pornografía infantil a familias que simplemente tienen recuerdos personales en el teléfono. Un nuevo informe aclara que las pruebas realizadas por la compañía han dado un umbral de error de uno contra un billón de imágenes.

También la empresa asegura que hay bastantes niveles en el proceso para analizar mediante la tecnología y la supervisión humana, si se trata de un error o realmente se ha detectado pornografía infantil.

Por último, Federighi explica en la entrevista que han querido diseñar este sistema para que ni Apple ni instituciones puedan utilizarlo para espiar en los dispositivos en busca de información diferente. Niega que se trate de una puerta trasera. "En nuestro caso, la base de datos se envía al dispositivo, es una información única para todos los países", dice. "Si alguien viniera a Apple a pedir acceso, nos negaríamos, pero digamos que no estás seguro, no quieres tener que confiar en que Apple diga que no, ese fue el listón que nos pusimos al lanzar este sistema" afirma Craig Federighi.

El análisis de imágenes dentro de los iPhone en busca de contenido ilegal relacionado con la pornografía infantil se va a desplegar en un primer momento en los móviles de Estados Unidos. No hay fecha aún para su despliegue en el resto del mundo y habrá que esperar para conocer si este sistema es compatible con la normativa europea de protección de datos.