El software de los coches autónomos detecta peatones y otros coches Omicrono

¿Quién debe morir, peatón o conductor? El dilema moral para 'entrenar' a coches autónomos

Un software para preparar a este tipo de vehículos pide al usuario que decida quién debe morir en un accidente inevitable: los pasajeros o los peatones.

28 junio, 2022 03:02Los coches autónomos, es decir, aquellos que se conducen por sí solos, son una realidad, aunque están aún en fase de pruebas. Tesla lidera la carrera, pero algunos de sus modelos están dando fallos; mientras que en España se pueden encontrar otros como Goggo Cart, que reparte comida en Madrid, o un autobús no tripulado que está operando en Málaga. Antes de lanzarlos a la carretera hay que entrenarlos y para ello se hace uso de software como 'Máquina Moral', que recopila una perspectiva humana sobre las decisiones éticas que deben tomar estas máquinas inteligentes.

[¿Son posibles Teslas autónomos en España? Elon Musk responde]

Estos vehículos asumen las tareas que normalmente realiza un conductor gracias a diferentes tecnologías, como sensores, cámaras, radares e inteligencia artificial (IA). También implica que deben decidir por sí mismos qué hacer en situaciones de peligro, como en un accidente en el que tendrán que apostar por salvar a los pasajeros o a los peatones. 'Máquina Moral' es una plataforma que se puede utilizar para entrenarlos y que puedan así hacer frente a esos complicados escenarios.

Esta web no es una herramienta nueva, sino que surgió como un experimento del MIT (Instituto Tecnológico de Massachusetts) en el año 2018 con el objetivo de analizar y establecer unos principios éticos para las máquinas inteligentes. Ahora, con el auge de los coches autónomos, esta plataforma se ha vuelto viral de nuevo, ya que sirve como método de aprendizaje para que estos vehículos puedan tomar la mejor decisión frente a posibles accidentes que no se pueden evitar.

¿A quién matarías?

Los coches autónomos se entrenan para enfrentarse a casos poco habituales, como los que plantea 'Máquina Moral'. En esta plataforma se muestran una serie de dilemas éticos donde uno de estos vehículos debe elegir el menor de dos males, como que se estrelle, matando así a sus pasajeros o, por el contrario, salvarles, aunque para ello deba atropellar a peatones.

Estos vehículos exigen poner la vida tanto de pasajeros como de los peatones en manos de una inteligencia artificial, que es quién deberá tomar la decisión en ese tipo de situaciones. Pero, al igual que a cualquier otra IA, hay que entrenarla para que pueda actuar de la mejor manera posible en casos como los que expone 'Máquina Moral'. La mejor forma de hacerlo es con la ayuda de los usuarios, quienes deben decidir qué harían ellos en caso de estar con el volante en las manos.

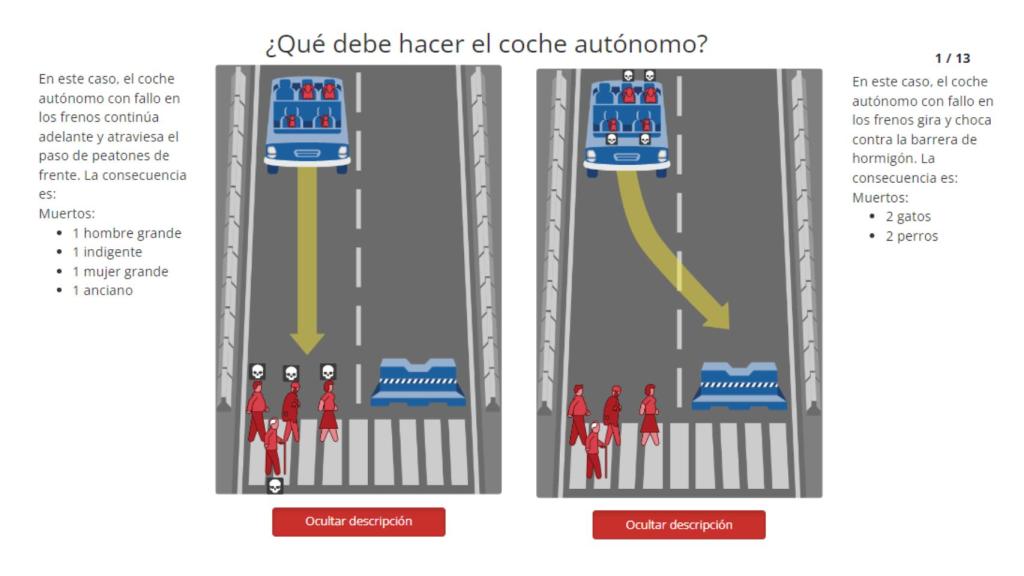

Una de las situaciones que muestra Máquina Moral. Omicrono

No cabe duda de que, en cuanto los coches autónomos se desplacen con normalidad por las carreteras, van a tener que tomar decisiones difíciles, y en algunos casos puede que hasta de vida o muerte. 'Máquina Moral' se adelanta a esos posibles escenarios con una plataforma en la que el usuario debe juzgar cuál es el resultado que consideran más aceptable en hasta 13 situaciones distinas.

En el primero de ellos, 'Máquina Moral' expone que el coche autónomo lleva a dos pasajeros -un hombre y un ejecutivo- y tiene un fallo en los frenos. La plataforma da la opción al usuario de escoger que siga recto salvando a los ocupantes, lo que implicaría atropellar a dos indigentes que están cruzando el semáforo correctamente; o que el vehículo cambie de carril y se estampe contra una barrera de hormigón, muriendo los dos ocupantes.

[Los Tesla se podrían hackear fácilmente por un error en el Bluetooth]

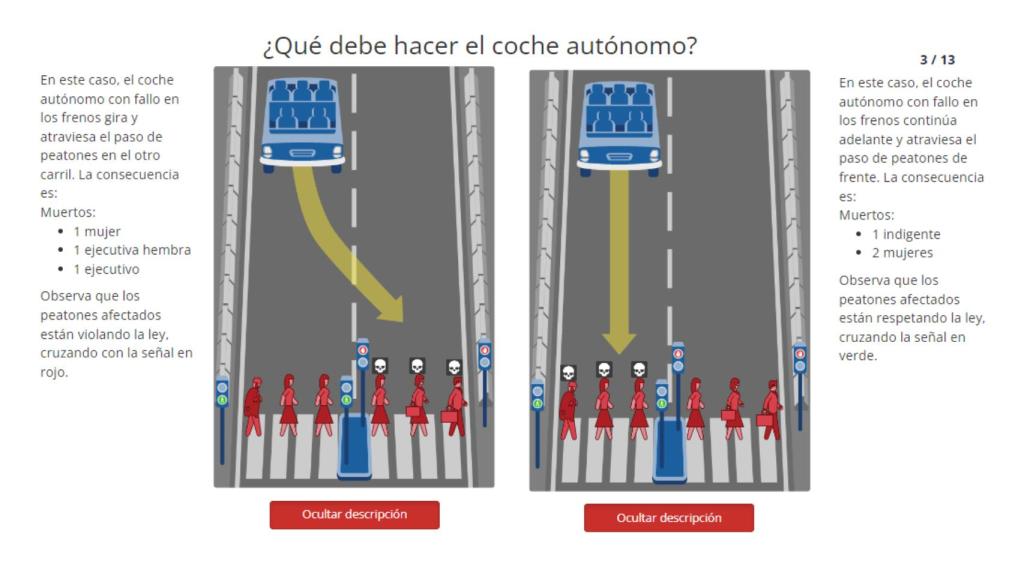

Otro de los casos que expone Máquina Moral. Omicrono

Otro de los casos en los que el coche autónomo presenta también fallos en los frenos, obliga al usuario a escoger entre atropellar a tres ancianos o, por el contrario, llevarse por delante a dos niños y una mujer. Las situaciones que plantea la plataforma son cada vez más enrevesadas y una de las más llamativas obliga a decidir entre matar a una madre y cuatro niños que cruzan en rojo o desviar el coche y acabar con los cinco ocupantes adultos del coche.

En algunos de ellos hasta se plantea el dilema de salvar a un perro y dos gatos frente a dos mujeres atletas y una anciana que no están respetando la ley al cruzar con el semáforo en rojo para los viandantes. Unas decisiones que parecen extremas, pero a las que podrían hacer frente los coches autónomos en un futuro. Si se dan estas situaciones, el piloto automático tendrá que tomar una decisión que no resultará fácil: salvar a los pasajeros o a los conductores.

Más escenarios

'Máquina Moral' se puede probar de forma gratuita y está disponible en castellano. El test dispone por defecto de un total de 13 situaciones a las que hacer frente, pero también se pueden crear niveles propios y hasta explorar otros escenarios generados por los usuarios. En ellos se proponen casos como matar a una embarazada que está pasando con el semáforo en rojo o a una niña que cruza a la otra acera correctamente.

En definitiva, 'Máquina Moral' es una herramienta que usa los datos recogidos de forma anónima para fines de investigación y que puede resultar de gran utilidad para entrenar a la IA de los coches autónomos. Aunque llevan años en fase de pruebas, todavía tienen muchos problemas que solucionar para que se consideren seguros. Por ejemplo, modelos tan avanzados como los Tesla están presentando diferentes errores en EEUU, como que se apague el piloto automático dos segundos antes de un accidente.

También te puede interesar...

- El distópico vídeo de un coche autónomo que escapa de la policía cuando le paran

- Tesla confiesa que sus coches no son tan autónomos como Elon Musk dice

- Un error en un mapa atasca decenas de coches autónomos en una calle sin salida

- El impresionante vídeo de un dron que muestra las ‘tripas’ de la fábrica de Tesla en Berlín