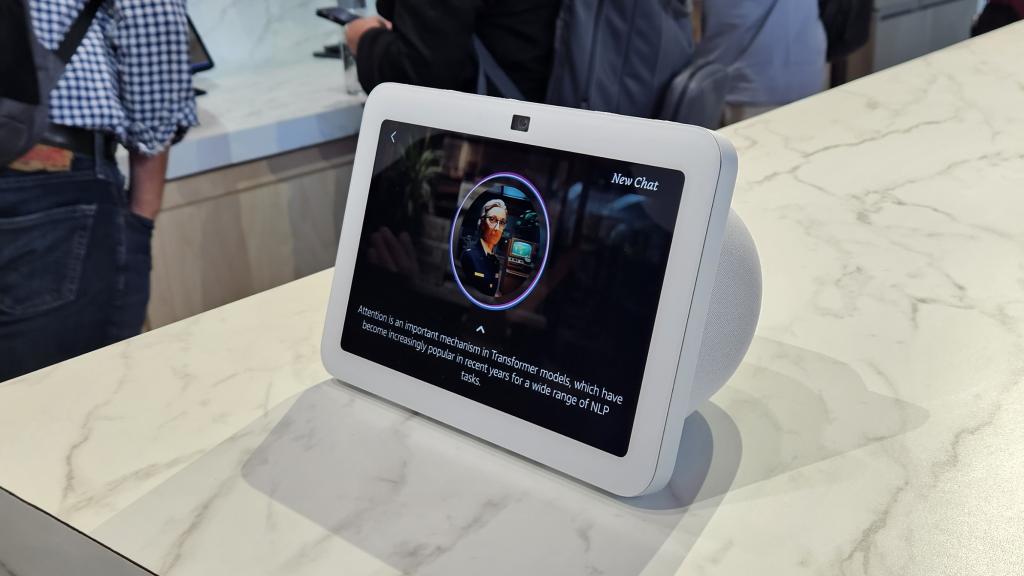

El Echo Show 8 (3.ª generación). Omicrono

Estos serían los motivos por los que Alexa aún no domina la IA conversacional, según algunos antiguos empleados

Extrabajadores de la compañía señalan sus claves por las que el asistente no lidera la carrera de la inteligencia artificial; algo que sí hace OpenAI.

13 junio, 2024 14:01No hay duda de que la inteligencia artificial (IA) es el último fenómeno del sector tecnológico y desde hace tiempo ha pasado de ser una anécdota a una herramienta cada vez más útil y omnipresente. De hecho, es una tecnología muy utilizada en España que ha evolucionado mucho desde sus inicios, pudiendo realizar cosas que van más allá de escribir un texto o crear una imagen a partir de una idea, como predecir la estructura e interacción de todas las moléculas de la vida. Una carrera que actualmente lidera OpenAI con ChatGPT, que llegará al iPhone, pero cuyo trono podría haber sido de Alexa de Amazon.

En septiembre de 2023, David Limp, por aquel entonces responsable de dispositivos y servicios de Amazon, mostró una nueva versión potenciada por inteligencia artificial generativa de Alexa, el asistente de voz de la compañía. Un acto en el que se demostró cómo el asistente podía responder con una voz más natural y conversacional que la anterior versión robótica. Una actualización que marcaba "una transformación masiva de Alexa", a la que la compañía denominó como "súper agente". Sin embargo, tras ese evento no se volvió a saber nada sobre este tema.

Y es que la voz tradicional y robótica nunca se llegó a cambiar en los millones de dispositivos que Amazon ha vendido n todo el mundo y en los meses siguientes surgieron pocas noticias sobre una nueva Alexa de IA generativa, aparte de un informe sobre su posible lanzamiento a finales de este año que podría incluir un cargo por suscripción. Una oportunidad perdida para la compañía de lograr que su asistente domine la inteligencia artificial, al menos eso es lo que indican más de una docena de antiguos trabajadores al medio Fortune.

Detrás de sus rivales

El medio ha realizado una serie de entrevistas a antiguos empleados de Amazon que trabajaron en la inteligencia artificial para Alexa; quienes señalan las que consideran las razones por las que esta tecnología no domina la IA. Por ejemplo, hablan de una organización acosada por la disfunción estructural y los desafíos tecnológicos que han retrasado repetidamente el envío de la nueva Alexa con inteligencia artificial generativa. Incluso dibujan a la compañía como una empresa que está desesperadamente detrás de sus rivales -Google, Microsoft y Meta- en la carrera para lanzar chatbos y agentes de IA.

Los empleados apuntan que la demostración de septiembre del año pasado era simplemente eso, una demo, y que la nueva Alexa no estaba lista para su lanzamiento; y sigue sin estarlo. El model de lenguaje de gran tamaño (LLM) de Alexa está todavía verde y los trabajadores afirman que Amazon no tiene suficientes datos ni acceso a los chips informáticos especializados necesarios para ejecutarla y competir con empresas como OpenAI. Incluso apuntan a las preocupaciones sobre privacidad y que la empresa de Jeff Bezos ha priorizado la creación de IA generativa para la unidad de computación en la nube de Amazon, AWS.

Charlando con el nuevo Echo Show. Omicrono

Un portavoz de Amazon dijo al mismo medio que los detalles proporcionados por los antiguos trabajadores eran "de fecha" (antiguos) y no reflejan el estado actual de la LLM Alexa. Incluso añadió que la compañía tiene acceso a miles de GPU y otros chips específicos para inteligencia artificial; y negó que Alexa haya perdido prioridad. Lo que está claro con este informe es lo difícil que es para las compañías renovar los asistentes digitales basados en tecnologías más antiguas para incorporar la inteligencia artificial generativa.

Incluso revela que Amazon no está preparada para esta batalla de los asistentes digitales, a pesar de que mucho suponían que la firma estaría perfectamente posicionada en la carrera, ya que Alexa se lanzó en 2014, mucho antes que ChatGPT, que llegó en noviembre de 2022. Aun así, el gigante tecnológico se ha visto sorprendido por el chatbot de OpenAI. Los empleados señalan que a la empresa le pilló desprevenida el auge de la IA generativa y tras ChatGPT lucharon para hacer que el asistente digital pasar de ser un bot de comandos y acciones a un agente conversacional y útil.

En el periodo navideño de 2022 los ejecutivos de Amazon pidieron a los científicos, ingenieros y jefes de producto que averiguaran cómo garantizar que la empresa tuviera productos de IA generativa que ofrecer a los clientes; aunque lo que lograron fue un ambiente de "un poco de pánico", según un antiguo jefe de proyecto de IA para Alexa de la empresa. El problema con el que se encontró la firma es que varios del equipo seguían trabajando a distancia tras la pandemia por la Covid-19, lo que llevó a que la gente estuviera "interminablemente apiñada en conferencias telefónicas debatiendo las minucias de las PRFAQ estratégicas" (la jerga de Amazon para un documento escrito utilizado cuando se propone una idea de producto en sus primeras etapas).

Y aunque no fue hasta el lanzamiento de ChatGPT cuando la empresa se puso en marcha en este campo, uno de los trabajadores de Alexa ya había tratado de hacer sonar la alarma sobre la próxima ola de IA generativa a mediados de 2022, pero no logró convencer a Amazon de que necesita cambiar su estrategia en cuanto a esta tecnología. Aunque el principal problema es que el asistente no se creó para mantener conversaciones de ida y vuelta, y nunca se han utilizado principalmente para eso; sino para responder a preguntas o para que apaguen o enciendas las luces de casa.

Amazon Echo Dot 5. El Androide Libre

Otro de los antiguos trabajadores del equipo de Alexa señala que "los líderes internos tenían claramente grandes planes, pero no sabían realmente en qué se estaban metiendo"; ya que antes no estaba claro que los LLM fueran capaces de desencadenar acciones en el mundo real a partir de una conversación natural. En su lugar, los equipos se las ingeniaban para aplicar la IA generativa sobre la marcha, como crear conjuntos de datos sintéticos -colecciones de diálogos generados por ordenador con un chatbot- que pudieran utilizar para entrenar un LLM.

Lo que implicaba "un montón de obstáculos". Otro inconveniente que encontraron es que los LLM tienen dificultades para pasar del diálogo hablado a la realización de una tarea utilizando otro software. A medida que la primavera daba paso al verano de 2023, muchos en las filas de Alexa seguían sin saber cómo el asistente digital llegaría al momento de la IA generativa. Y es que el proyecto carecía de visión, según los antiguos trabajadores.

Falta de datos

Los antiguos empleados señalan que la demo de Alexa realizada en septiembre del año pasado hizo parecer que su lanzamiento era inminente, pero "no cumplió con los criterios de go/no-go" (pruebas de aprobado/fallo). Los LLM son conocidos por producir alucinaciones y, a veces, contenido tóxico, y el de Amazon no era diferente, por lo que su lanzamiento era arriesgado. "Es muy difícil hacer que la IA sea lo suficientemente segura y probar todos los aspectos de esa caja negra para lanzarla", señala un antiguo gerente.

Además, garantizar que Alexa pudiera seguir realizando sus antiguas funciones al tiempo que permitía el diálogo conversacional que prometía el nuevo modelo del asistente inteligente no sería tarea fácil. De hecho, el antiguo gerente dijo que tenía claro que la empresa necesitaba, al menos temporalmente, dos piezas completamente diferentes: una que soportara las antiguas funciones de Alexa y otra las nuevas. Algo que no contemplaron los directivos de Amazon.

Amazon Echo Show. El Androide Libre

Otro de los problemas que señalan los antiguos trabajadores es que mientras el lanzamiento de la Alexa más inteligente, los ejecutivos de Amazon fijaban objetivos de inteligencia artificial generativa cada vez más elevados y pedían a sus empleados que trabajaran más duro. La falta de datos también fue uno de los principales obstáculos en este camino de la empresa hacia la IA generativa. Y es que mientras Llama 3 de Meta se preentrenó con 15 mil millones de tokens (la unidad de datos más pequeña -como una palabra- que procesa un LLM durante el entrenamiento), el de Alexa sólo se entrenó con 3 mil millones.

Uno de los trabajadores explica que Amazon insiste en usar sus propios anotadores de datos y que esa organización es muy lenta: "así que nunca podemos obtener datos de alta calidad de ellos después de varias rondas, incluso después de un año de desarrollo del modelo". Más allá de esto, el equipo de Alexa carece de acceso a las enormes cantidades de las últimas GPU de Nvidia, que son los chips utilizados para entrenar y ejecutar modelos de IA; y que sí tienen los equipos de OpenAI, Meta y Google. Incluso destacan que, en ocasiones, la creación de la nueva Alexa se ha visto relegada a un segundo plano frente a otras prioridades de IA generativa en Amazon.

La burocracia y los problemas de infraestructura también han ralentizado los esfuerzos de Alexa de ser más inteligente. Uno de los empleados señala que la mayoría de los trabajadores han mencionado "sentirse agotados" por la constante presión para preparar el modelo para un lanzamiento que se va posponiendo todo el rato; y frustrados porque tienen otro trabajo en espera que no pueden realizar hasta completar este. Incluso algunos han mostrado escepticismo sobre si el diseño general de Alexa basado en LLM tiene sentido.

"Una de las historias que he oído es que, al principio del proyecto, hubo un gran empuje por parte de los altos ejecutivos que se habían vuelto demasiado confiados después de experimentar con ChatGPT, y que este exceso de confianza ha persistido entre algunos altos dirigentes que siguen impulsando hacia un objetivo poco realista", afirma un empleado. Mientras que otro trabajador dice que los directivos fijaban plazos que eran inalcanzables.

Amazon Alexa

"Cada vez que los directivos nos asignaban una tarea relacionada con [el] LLM, nos pedían que la completáramos en un plazo muy breve (por ejemplo, 2 días, una semana), lo cual es imposible. Parece que la dirección no sabe nada sobre LLMs: no saben cuántas personas necesitan y cuál debería ser el tiempo esperado para completar cada tarea para construir un producto exitoso como ChatGPT", explica. Otro problema es que Alexa está organizada en grandes dominios aislados como Home, Entertainment, Música y Shopping, cada uno con cientos de empleados; y cada uno de ellos requería puntos de referencia de precisión, por lo que entraron en conflicto.

Esto terminó con resultados a veces contraproducentes, según las fuentes. Cada equipo de dominio quería ajustar el modelo de IA a sus propios objetivos -algo que haría que el modelo funcionara peor- y tuvieron que construir su propia relación con el equipo central de Alexa LLM. "Pasamos meses trabajando con esos chicos de LLM solo para entender su estructura y qué datos podíamos darles para afinar el modelo y hacerlo funcionar. A medida que mejora en Música puede volverse menos inteligente en Home. Así que encontrar el punto dulce donde estás tratando de afinar para 12 dominios es casi una lotería", explica uno de los trabajadores.

El problema estaba en que cada dominio de Alexa, con su propio liderazgo, quería proteger y ampliar su feudo. "Esta organización se ha convertido en algo parecido a una mafia. Digamos que, si trabajo para usted, sólo recibo órdenes porque lo que más me conviene es estar de acuerdo con usted. Me interesa no ser despedido en el próximo despido... es bastante despiadado. Me conviene porque me vas a ayudar a construir mi imperio", dice un antiguo jefe de producto

Amazon mantiene su compromiso

El mismo medio señala en su reportaje que Amazon insiste en que está plenamente comprometido con la entrega de una inteligencia artificial generativa de Alexa y que su visión es construir "mejor asistente personal del mundo". Un portavoz explica que la implementación de esta tecnología conlleva una "enorme responsabilidad: los detalles realmente importan" con una implementación técnica de esta escala, en un dispositivo que millones de clientes han acogido en su hogar.

Altavoz Echo Show 8. Omicrono

También explica que, aunque la función "Vamos a chatear" de Alexa LLM no se ha lanzado al público en general, se ha probado en pequeños grupos de clientes "de forma continua". Sin embargo, muchos de los empleados entrevistados por el medio dicen que se marcharon en parte porque desesperaban de que la nueva Alexa estuviera lista algún día o de que, para cuando lo estuviera, hubiera sido superada por productos lanzados por "competidores más ágiles", como puede ser OpenAI.

"Esas empresas no tienen que navegar por una pila tecnológica existente y defender un conjunto de características ya existentes", dice uno de los antiguos empleados del gigante tecnológico. Aun así, algunos de los trabajadores entrevistados, creen que es posible que Amazon lance finalmente una Alexa basado en LLM y que sea una mejora del asistente inteligente actual.