La guerra de los chips para IA ya se está fraguando desde hace unos años.

La Inteligencia Artificial ya no es cosa del futuro. A pesar de que el concepto existe desde hace muchísimos años, es ahora cuando se está dando pasos agitandados en torno a este sector. Amazon Echo, por ejemplo, un producto para uso doméstico, hace uso del machine learning (Aprendizaje Automático en términos de Inteligencia Artificial) para ofrecernos los mejores resultados.

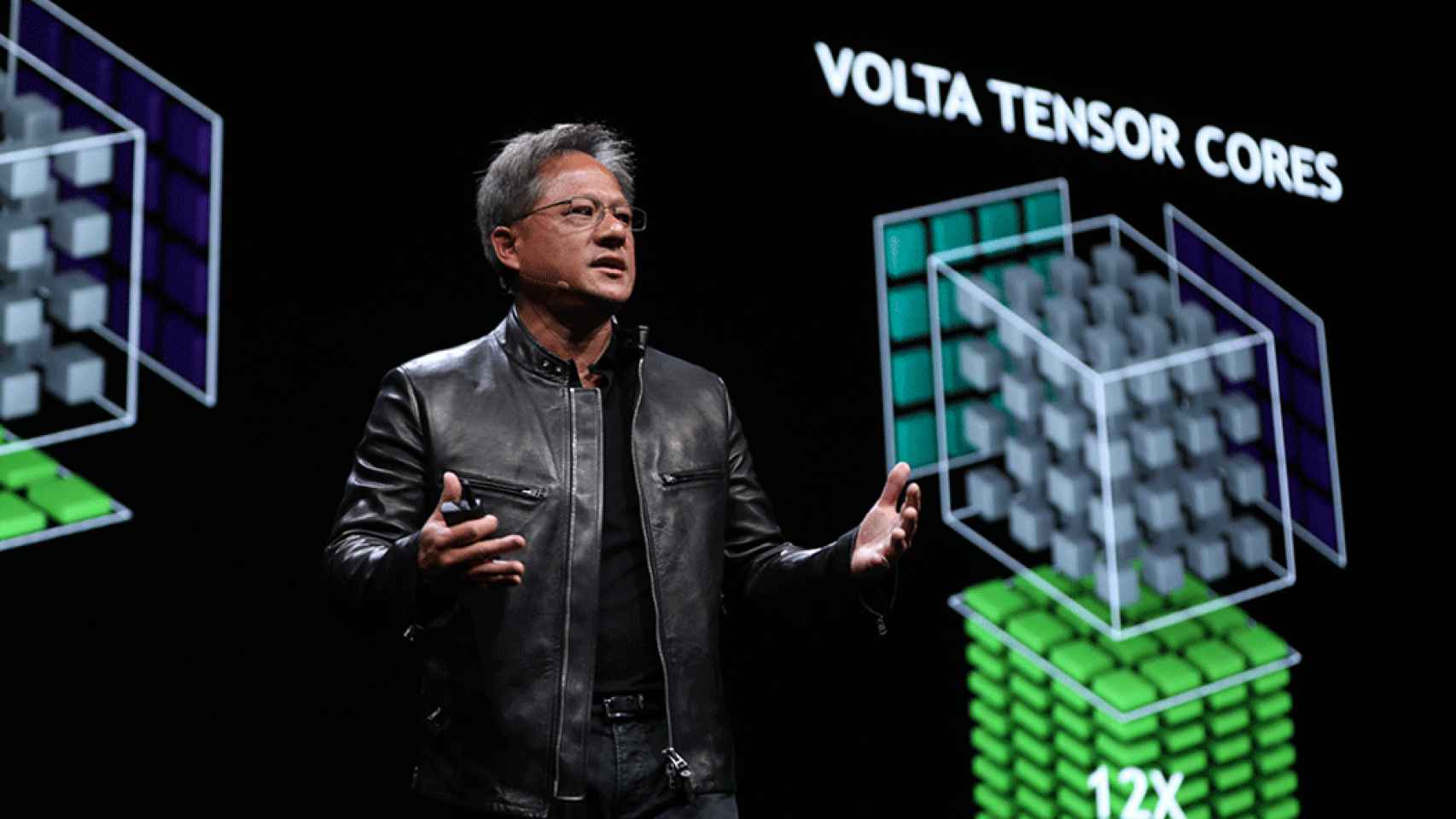

Durante el día de ayer Nvidia dio lugar a un evento donde presentó su nueva NVIDIA Tesla GPU V100 destinada a data centers. Se trata de una tarjeta de procesamiento gráfico que se puede resumir como la culminación de años de trabajo (desde 2012) y de 3 mil millones de dólares (sí, lo que costó Beats en su momento, por ejemplo).

Primero hay que entender por definir un TFLOP. Esto es el acrónimo de Teraflops, que es la unidad que se ha ido imponiendo a lo largo de los años para definir y poder comprar la capacidad de procesamiento gráfico de una máquina. 1 solo TFLOP equivale a 1 billón (1 000 000 000 000, o millón de millones; por supuesto en escala numérica larga) de operaciones por segundo. Pues bien, según Nvidia, su nueva tarjeta gráfica es capaz de alcanzar hasta 120 Tensor TFLOPs.

La inteligencia artificial está impulsando los avances tecnológicos más grandes en la historia humana

No entrar en la batalla de la Inteligencia Artificial es quedarse atrás. Todos, no solo Google y Amazon, tienen proyectos en mente en torno a él. Adobe, por ejemplo, quiere que sea una IA quien programe; una compañía de Singapour, para que no hayan más vídeos violentos en Facebook; y así un largo etcétera de firmas que están detrás de estar nueva tecnología que, sin duda alguna, está cambiando el sector.

No subirse al carro es quedarse fuera

sxm2-voltachipdetails_678x452

Se puede decir que fue la propia Nvidia la que comenzó la guerra de los chips para IA. No obstante, no es la única que está trabajando en ello: Google (ya reveló su propio chip, al que llamó Tensor Processing Unit), Intel, Groq (una empresa formada por ex-ingenieros de Google) y Wave Computing también tienen avances muy grandes.

Por supuesto no hablamos de chips que lleguen a ser para uso doméstico, sin de chips destinados a empresas que gestionen servicios en la nube. Por ejemplo, en el caso del machine learning del Amazon Echo, no es el propio asistente quien procesa todos los datos, sino que esto es tarea de los servicios en la nube de la compañía.

Esto es, la Nvidia Tesla GPU V100 y compañía van destinados a este tipo de tareas. Es más, su elevado precio descarta totalmente que su uso sea para la casa: un equipo con 8 de estas tarjetas incorporadas en una DGX-1 costará 149 mil dólares.

Noticias relacionadas

- El nuevo doodle de Google celebra el aniversario del Apolo 11 y la llegada a la Luna

- Tomar curvas peligrosas con la moto será menos peligroso con esta IA avisándonos

- Google te pagará tres veces más si encuentras fallos en sus productos

- Cuando veas porno vigila la puerta... y la privacidad: Google y Facebook saben lo que ves