Este estudio trata de poner fin a uno de los dilemas más sonados de los coches autónomos.

Decidir quién se salvaría y quién moriría en accidente de tráfico es una de las decisiones más difíciles que tendrán que tomar los coches autónomos. Desde hace unos cuantos años se lleva diciendo que los coches autónomos tendrían que ‘sacrificarnos’ para salvar a los peatones (que es un grupo más vulnerable); pero, ¿hasta qué punto sería correcto?

Dilema del tranvía

Es como el dilema del tranvía, desarrollado por Philippa Foot (una filósofa británica). Un tranvía fuera de control está a punto de atropellar a cinco personas que están atadas a las vías; pero, si queremos, podemos hacer que el tranvía cambie de vía, aunque por desgracia en ella también hay otra persona atada ¿Quién decide que esa vida vale menos que las otras cinco?

dilema tranvia filosofia

Por un lado, no somos nadie para decidir a quién salvar, pero por otro, tampoco podríamos no hacer nada ante la muerte de tantas personas. Hay otros dilemas muy parecidos, y su estudio podría ayudar a tratar de resolver este gran problema de las IA. Y es que, aunque muchos de los dilemas son escenarios muy parecidos, las respuestas, según los filósofos, serían totalmente distintas.

dilema coche autonomo vida

En otros dilemas parecidos se deja morir a las cinco personas antes que matar solo a una. Incluso a más de cinco personas. Hablamos, por ejemplo, de uno de los dilemas de Unger. En él, seríamos nosotros quién tendríamos que arrojar a alguien a las vías para salvar al resto; al tener que realzar activamente el hecho de arrojar a alguien, la gente simplemente cambia su respuesta. Incluso aunque mueran el resto de personas.

Algoritmos para resolver la situación

Está claro que la solución la tiene un algoritmo, pero, ¿qué reglas debería tomar? Un estudio impulsado por el Instituto de Ciencias Cognitivas de la Universidad de Osnabrück (Alemania) en el que se ha usado la realidad virtual inmersiva para exponer a las personas de manera ‘real’ a estos dilemas sugiere las reglas que deberían tomar estos vehículos autónomos para tomar decisiones lo más parecidas a los humanos.

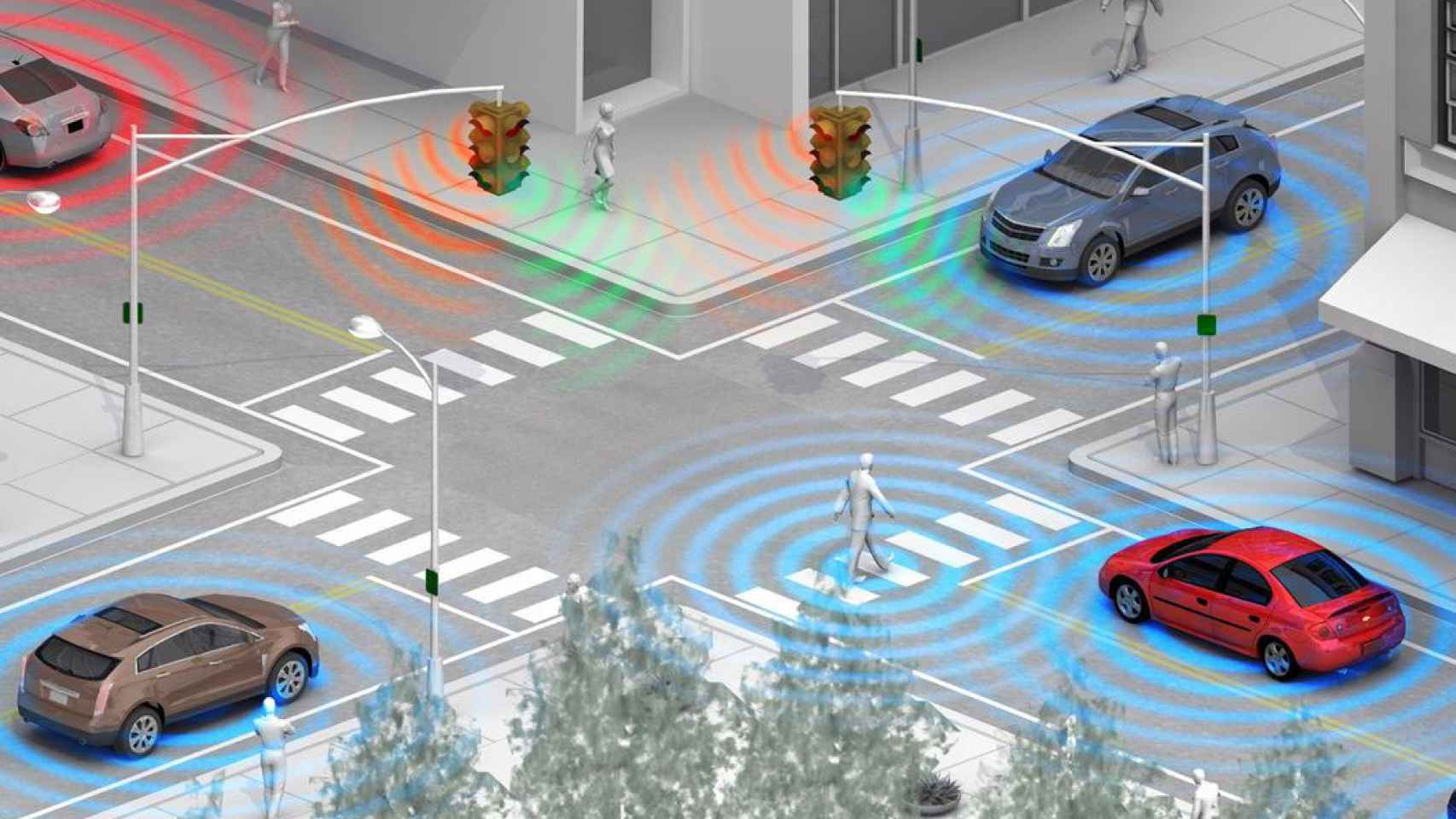

conduccion autonoma

En el estudio intervinieron tres tomas de decisiones distintas. Los individuos, quienes conducían en un entorno suburbano con niebla, experimentaron situaciones inesperadas y polémicas en la que intervenían objetos, animales o personas, decidiendo cuál se salvaba en cada caso.

En cada uno de las tres situaciones intervenían aspectos distintos, como la edad, que acabó por cambiar los resultados. También se limitó el tiempo de reacción, lo que provocó que la toma de decisiones fuera menos ética. Lo único que queda claro de este estudio es que prevalece la vida humana independientemente del contexto (algo que, a priori, no podía ser así). Y eso es lo que se debería de ver plasmado en forma de regla.

Este estudio, por lo tanto, abre un nuevo debate ético-moral. Primero, para decidir si se deberían incluir factores éticos en la toma de decisiones de los coches autónomos y, segundo, para decidir si estos valores éticos debieran ser los de los humanos. Vamos, si los sistemas autónomos deben aceptar nuestros juicios morales o no.

Noticias relacionadas

- El nuevo Cupra será un SUV deportivo español 100% eléctrico, el primero de su tipo

- Las bicicletas eléctricas son mucho mejores que los coches eléctricos para nuestras ciudades

- Nuevo Chevrolet Corvette, el espíritu americano sigue muy vivo en un deportivo de menos de 60.000 dólares

- Tesla hace realidad la estación de servicio del futuro: con energía solar y capaz de cargar 24 coches al mismo tiempo