bot-chino

China bloquea dos bots por ir en contra del régimen comunista

Noticias relacionadas

- Estos robots microscópicos son tan diminutos que se mueven a base de vibraciones

- Tomar curvas peligrosas con la moto será menos peligroso con esta IA avisándonos

- El cofundador de Siri se une al equipo de Sherpa, el asistente inteligente español

- En Japón ya tienen "consignas para redes sociales", que te bloquean la cuenta el tiempo que quieras desconectar

China ha censurado dos chatbots o bots conversacionales que no estaban por la labor de seguir al régimen comunista.

Nueva historia con bots involucrados que han aprendido demasiado hasta llegar a ponerse en una posición contraria a la deseada por todo un Estado. Esta vez ha ocurrido en China, donde dos bots diferentes usados en aplicaciones de mensajería instantánea comenzaron a responder a preguntas sobre el régimen comunista del país en contra del mismo.

Estos bots conversacionales han sido retirados de la aplicación de mensajería Tencent QQ después de que los usuarios comenzasen a compartir capturas de pantalla de sus conversaciones con ellos en las redes sociales.

Chatbots que aprenden demasiado de los humanos

Como apuntan desde The Verge, lo curioso es que los bots no tenían detrás a los mismos desarrolladores. Por un lado estaba el bot BabyQ que al ser preguntado “¿Amas al Partido Comunista?”, su respuesta era directa y seca: ”No”.

Ante mensajes de los usuarios tipo “larga vida al partido comunista”, este bot contestaba “¿Crees que un partido político tan corrupto e incompetente puede durar mucho?”.

tay 1

Por otro lado estaba el bot XiaoBing, desarrollado por la gente de Microsoft. En este caso el chatbot aseguraba que su “sueño chino era ir a América” y, al ser cuestionado por su patriotismo respondía que lo dejasen tranquilo “que estaba teniendo su período”.

Ambos bots han sido retirados de la aplicación Tencent QQ y la compañía ha echado balones fuera diciendo que estos servicios son creados por terceras compañías.

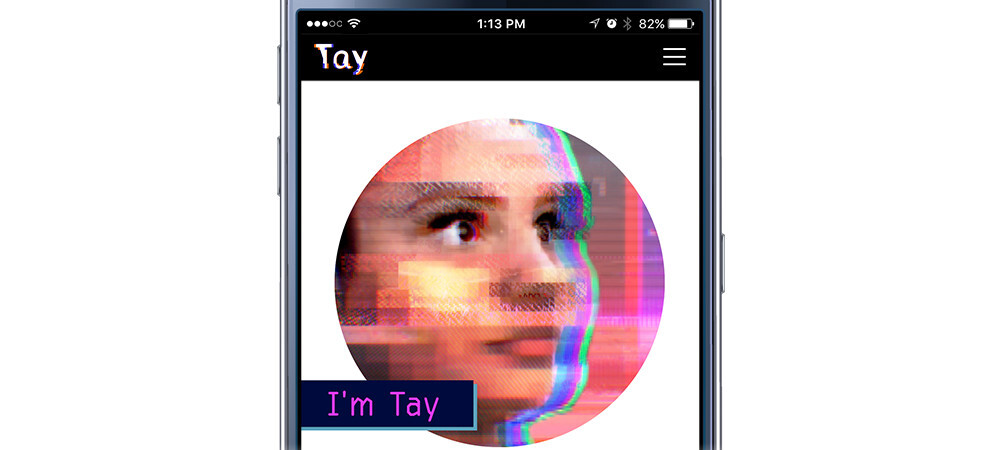

¿Qué ocurrió para que los bots diesen esas respuestas? Probablemente sus conversaciones con los usuarios. Ya ocurrió anteriormente y precisamente a Microsoft. Hace un año crearon una Inteligencia Artificial llamada Tay y la pusieron a hablar con la gente en Twitter y finalmente la tuvieron que retirar porque sus respuestas fueron degenerando.