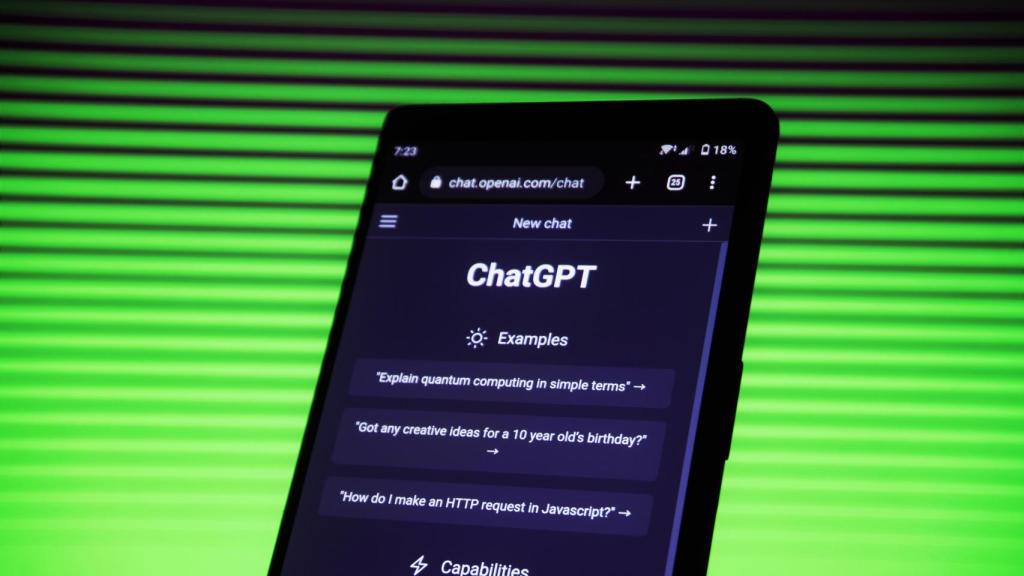

Aplicación de ChatGPT Omicrono

Fake news, manipulación y hackeos: cómo ChatGPT es un "profundo riesgo para la Humanidad"

Musk, Wozniak y Harari encabezan un manifiesto firmado por miles de expertos que piden parar su desarrollo para regular y controlarla.

1 abril, 2023 02:13La inteligencia artificial está viviendo una época de floración salvaje con novedades constantes que están en boca de todos por sus sorprendentes resultados. Con el mínimo tiempo y esfuerzo, herramientas como ChatGPT o Stable Difussion ayudan a crear textos e imágenes que parecen hechos por expertos en múltiples materias. Sin embargo, lo que para muchos es una revolución imparable que dará a la humanidad grandes ventajas, para otras voces reconocidas como Elon Musk, Steve Wozniak o académicos de España y del mundo, este torrente creativo también tiene un reverso peligroso que debe ser puesto en cuarentena, pararlo de inmediato y poder así analizarlo y controlarlo.

Italia ha sido el primer país que ha bloqueado ChatGPT "con efecto inmediato", lo hace por incumplir las leyes de protección de datos y no levantará el castigo hasta que la plataforma "no respete la disciplina de la privacidad" correspondiente, destacando por el camino la "falta de información a los usuarios y a todos los interesados de quiénes recoge datos OpenAI". El país europeo sienta así un precedente para tratar de poner coto a estos sistemas.

Pese a los logros por los que copa titulares en los últimos meses, lo cierto es que la inteligencia artificial ha crecido envuelta siempre en temores y preocupaciones, en parte, alimentadas por las obras de ciencia ficción que llevan décadas advirtiendo de las consecuencias. Esas incertidumbres están más vivas que nunca. ¿Está realmente ese mundo distópico a la vuelta de la esquina? De ser así, ¿qué medidas se deben tomar?

Un cambio disruptivo

Se pasa de "es la herramienta definitiva" a "se perderán miles de profesiones" o " ya no te puedes fiar de nada en internet", los halagos se mezclan con predicciones catastróficas en un momento en el que las IAs más avanzadas de la historia han llegado al gran público. Personas que nunca se habían interesado por ello empiezan a familiarizarse con esta tecnología promovida por grandes empresas que la están convirtiendo en un producto de masas a un ritmo frenético y para el que no se han preparado.

[Así es Bard, la respuesta de Google a ChatGPT que revolucionará su buscador]

"Se ha producido un cambio disruptivo que hacía tiempo que no veía y eso suele tener consecuencias que no tienes previstas", indica a EL ESPAÑOL - Omicrono, Cristina Urdiales, doctora en Robótica e IA de la Universidad de Málaga, que ha firmado junto con otros muchos expertos en la materia un manifiesto con una petición internacional para pausar unos meses el desarrollo de los grandes modelos de aprendizaje profundo y poder comprobar sus consecuencias y valorar sistemas de control.

Ilustración creada con inteligencia artificial. Omicrono

La explosión protagonizada por modelos como GPT-4 o Midjourney, aprovechada por corporaciones como Microsoft y Google, ha avivado un debate que lleva latente muchos años: la necesidad de establecer una serie de normas éticas que protejan a la humanidad. La discusión se aplazaba en la mayoría de las veces con un "todavía no es necesario, no es urgente", pero puede que el momento haya llegado, incluso que el toro nos haya pillado mirando cómo se acercaba.

Al menos eso es lo que parece advertir la carta firmada por más de 1.300 expertos de la industria y publicada por la organización Future of Life Institute, a pesar de que no todos están de acuerdo con el tono alarmante de la misiva que habla de "perder el control de nuestra civilización" a manos de las máquinas.

"Riesgo para la humanidad"

El pasado año 2022 fue el detonante de una bomba que ya latía años antes, pero que sólo unos pocos escuchaban. Los grandes modelos generativos de texto e imagen derivaron en chatbots o herramientas fáciles de usar para cualquiera, como ChatGPT, Dall-E 2 o Midjourney, entre otros. La alta calidad de sus redes neuronales capaces de escribir, programar o dibujar casi como un humano se ha combinado con una mayor accesibilidad dando el salto al mercado con la nueva generación de buscadores como Bing de Microsoft que posee buena parte de Open AI, empresa responsable de ChatGPT y Dall-E, la cual era antes una organización sin ánimo de lucro.

Ahora, todo el mundo con acceso a internet y un mínimo de interés puede pedirle a esta tecnología que le escriba un ensayo literario, le ayude a pasar un examen, programar una página web o crear un libro ilustrado para venderlo como propio. Artistas, escritores, programadores, cientos de profesiones se preguntan si esta novedad es un apoyo para impulsar su trabajo, como aseguran muchos ingenieros, o su sustituto. Pero la pérdida masiva de empleo no es la única preocupación que otea sobre el desarrollo de esta tecnología, su capacidad para generar rápidamente y a gran escala información falsa y fácil de creer es parte del riesgo. De hecho, el manifiesto es más rotundo: "la inteligencia humana-competitiva puede plantear profundos riesgos para la sociedad y la humanidad".

📸🎉 ¡La foto viral del Papa Francisco con su abrigo Balenciaga nos ha dejado locos! 😮🙌 Así que le pedimos a #ChatGPT que nos ayudara a crear más prompts de #MidJourney y, ¡voilà! 🌟aquí tenéis nuevo contenido!

— TechHalla (@techhalla) March 28, 2023

Los PROMPTS en los ALT 🔎

#PapaFrancisco #IA #HumorDivino 😇📲 pic.twitter.com/YEbdOkaQPP

Estos sistemas no sólo cometen errores y dan datos equivocados, sino que cualquiera puede solicitarles que inventen una historia o imagen comprometida de algún personaje conocido. Esta última semana, las redes sociales se han llenado de fotos del Papa vestido con abrigos de lo más variopintos. El pontífice parecía una estrella del rap más que un líder religioso, paseando con alegría aunque la realidad es que Francisco I se encuentra muy delicado de salud.

Aquellos familiarizados con el resultado de estas herramientas, detectaban con más facilidad la falsedad de las fotos del Papa, pero cada vez resulta más complicado reconocer su origen y poder verificarlas. No obstante, lejos de esta intención lúdica que pudieran tener estas fotos, hay otras invenciones con un objetivo más oscuro como las que también han aparecido representando a Donald Trump siendo detenido por la fuerza o las fotos de un terremoto catastrófico a principios de los 2000, que en realidad nunca pasó. La labor de comprobación de cada información y contenido multimedia que se encuentra por la red es como un ovillo de lana que se va haciendo cada vez más grande e inabarcable.

Making pictures of Trump getting arrested while waiting for Trump's arrest. pic.twitter.com/4D2QQfUpLZ

— Eliot Higgins (@EliotHiggins) March 20, 2023

Si las imágenes falsas pueden crear confusión, herramientas como ChatGPT con su destreza con la pluma parecen capaces de convecer de cualquier tema. El ejemplo perfecto lo recoge el informe escrito del periodista Tristan Greene usando Galactica (IA desarrollada por Facebook) titulada Una investigación sobre los beneficios de consumir cristales rotos, en el que se argumentan los beneficios del vidrio para corregir la acidez estomacal, una demostración del poder de la tecnología. Galactica se retiró al poco tiempo por la cantidad de información falsa y racista que elaboraba.

La reacción a estos casos suele ser la censura interna, los responsables de Midjourney que ya no permiten su uso gratuito, de igual manera otras plataformas similares no aceptan imputs o entradas con nombres de personas conocidas. La autorregulación es parte del sistema de control que se ha aplicado por ahora, las propias empresas vetan y marcan límites a sus sistemas según los usuarios van denunciando el peligro. ChatGPT ha sido acusado de aplicar una censura con tendencias políticas de izquierdas, negándose a escribir de unos temas pero no de otros.

[Cuidado con este phishing hiperrealista: calca a tu navegador y solo hay una forma de detectarlo]

Otro peligro está en la ciberseguridad en internet. La Oficina Europea de Policía, Europol, advierte esta semana que se están usando para redactar textos realistas que sirven de correos phishing donde antes los errores de estilo y ortográficos eran una de las claves para detectar estos fraudes informáticos. Incluso se usa para generar códigos maliciosos con los que infectar dispositivos.

Desarrollo de conciencias propias

Por el contrario, la carta publicada por la organización Future of Life Institute plantea miedos que los propios ingenieros llevan tiempo rechazando. "¿Deberíamos desarrollar mentes no humanas que eventualmente podrían superarnos en número, ser más inteligentes, obsoletas y reemplazarnos? ¿Deberíamos arriesgarnos a perder el control de nuestra civilización?", se preguntan. Los grandes modelos de lenguaje no tienen conciencia propia ni entendimiento del mundo como los humanos, sino que analizan patrones en millones de ejemplos para replicar la forma de escribir o dibujar de las personas.

"Estas ideas desplazan las preocupaciones de los casos reales que ya tenemos", advierte a este medio Antonio Ortiz, cocreador del pódcast Monos estocásticos especializado en esta materia. Urdiales también señala que algunas partes de la carta que ha apoyado son "demasiado tremendistas". Google despidió a un ingeniero que aseguró que el sistema que la compañía está desarrollando tenía conciencia, aunque la comunidad descartó la idea también.

"Hay mucha prisa"

Lo cierto es que la carrera por sacar soluciones de IA que están constantemente entrenándose y monetizándose deja al descubierto algo claro: "hay mucha prisa", crítica Cristina Urdiales, que añade que la ambición de la industria es "exprimirlo hasta el último minuto antes de que lo haga otro, sin pensar en si entienden la tecnología, las consecuencias o si es legal o ético". Esta investigadora trabaja desarrollando robots que tienen contacto físico con personas con discapacidad o que necesitan rehabilitación, por lo que recurre a la inteligencia artificial para que se entiendan máquina y pacientes. Ha firmado la carta preocupada por esa carrera empresarial nacida en los últimos meses.

Frente a los lanzamientos de Microsoft en colaboración con Open AI, Google se ha mostrado más reticente a lanzar su chatbot basado en sus propios grandes modelos de lenguaje natural, pero Microsoft les ha obligado a acelerar sus planes para proteger su liderazgo en internet. Otros buscadores como Baidu en China también han integrado su propia IA (Ernie) y así ha terminado de detonarse una carrera frenética y monetaria por ser los primeros en tener esta tecnología en sus productos. Incluso en el mundo de la moda, Levi's ahora quiere generar sus modelos de forma artificial para "incrementar la diversidad", dicen. Encontrar modelos de carne y hueso de distintas razas y cuerpos debe ser difícil.

Para Urdiales, que insiste en que no está en contra del desarrollo ni considera que la carta pida el cese de estos avances, hay dos consensos a los que deberían ajustarse todos los proyectos de IA —independientemente de su condición pública o privada—: explicabilidad y transparencia. Dos conceptos que la comunidad que apela a una regulación de la IA lleva pidiendo desde hace tiempo.

Representación de máquina y humano tomada por IA. Omicrono

El primero solicita una explicación sobre por qué una red neuronal generativa toma una decisión y no otra con cada tarea o pregunta, igual que se le solicita a las redes sociales o los buscadores la explicación de por qué sus algoritmos muestran al usuario un contenido u otro. Estas puertas abiertas a las tripas de los códigos son frecuente en el sector académico y de organizaciones sin ánimo de lucro, pero en las grandes compañías los portones se cierran con fuerza. OpenAI detallaba el funcionamiento de sus sistemas como GPT-3 en extensos papers, pero tras los acuerdos con Microsoft y la guerra comercial con Google, la información de GPT-4, su última versión, ha sido significativamente más escueta.

En segundo lugar, la transparencia solicita saber de dónde sacan los desarrolladores las bases de datos con los que están entrenando a sus redes neuronales. Algunos de los modelos generadores de imágenes más populares del momento como son Stable Diffusion y Midjourney han sido acusados de utilizar el trabajo de artistas sin su consentimiento para entrenar al sistema, el cual es capaz de crear nuevas obras con el estilo de estos creadores si se le pide.

¿Frenar para regular?

"Los que somos optimistas con la tecnología, en general, y la IA, en particular, pensamos que un exceso de prudencia nos impediría conseguir muchos avances positivos" afirma Ortiz. "Creo que la carta comunica más una sensación de "no control", de vértigo ante el avance espectacular de la IA en los últimos dos años, que un diagnóstico certero", añade.

Las más de 1.300 firmas en la carta, pueden parecer pocas, pero son de peso. Elon Musk, CEO de Tesla y Twitter; Steve Wozniak, cofundador de Apple; Yuval Noah Harari, historiador y autor de Sapiens; Craig Peters, CEO de Getty Images; y académicos y directivos de cientos de universidades del mundo son algunos de los firmantes. Musk lleva años advirtiendo que la IA puede ser el desencadenante de la tercera guerra mundial. El magnate pronunciaba esta frase aterradora al mismo tiempo que invertía en la fundación de Open AI y creaba empresas como Neuralink con la que propone implantar chips en el cerebro de las personas para controlar con telepatía las máquinas.

Representación realizada con IA. Omicrono

Aparte de estas personalidades, el resto de nombres son principalmente de académicos e investigadores enfocados en el estudio y creación de estas nuevas tecnologías. Algunos son investigadores de DeepMind, compañía de inteligencia artificial que pertenece a Google y es competencia de OpenAI, es decir, que estarían trabajando en los proyectos que la carta solicita pausar. Los propios creadores preocupados por el poder de su criatura. A su vez estos firmantes también son fundadores de Future of Life Institute.

La carta pide pausar durante 6 meses el desarrollo de nuevos y actuales modelos de IA para valorar sus consecuencias y posibles controles. "Los sistemas potentes de IA deben desarrollarse solo una vez que estemos seguros de que sus efectos serán positivos y sus riesgos serán manejables", esta frase tan optimista de la carta obliga a regresar a los inicios de internet cuando los miedos y suposiciones no fueron capaces de dibujar ni una pequeña parte del impacto que ha tenido para la sociedad, que ahora ya no puede funcionar sin ella.

"Esta pausa debe ser pública y verificable, e incluir a todos los actores clave" afirman. Todas las empresas y países deberían jugar limpio y no aprovechar el descanso del resto para adelantarse, un acuerdo internacional que no se ha conseguido con peligros como las armas de destrucción masiva. Sin olvidar que la IA se usa en un sin fin de sectores como la sanidad para desarrollar medicamentos, el estudio del medioambiente o la logística del transporte, detener su desarrollo puede influir en estas materias.

[España será el campo de pruebas para el futuro Reglamento Europeo de Inteligencia Artificial]

También alegan a una posible intervención gubernamental, los estados se han centrado en la protección de datos de los ciudadanos (regulación a posteriori de su aplicación en el mercado), como por ejemplo Italia. Aunque la UE trabaja desde 2021 en un reglamento para la IA, en el que prohibir los sistemas más perjudiciales como los que manipulan comportamientos u otorgan sistemas de crédito social y puntuaciones a las personas por su comportamiento.

La propia OpenAI en una declaración reciente establece que "en algún momento, puede ser importante obtener una revisión independiente antes de comenzar a entrenar sistemas futuros, y para los esfuerzos más avanzados, acordar limitar la tasa de crecimiento de la computación utilizada para crear nuevos modelos". Los firmantes apoyan esta idea que alude a la idea de transparencia y explicabilidad antes mencionadas.

La Covid-19 acelera la digitalización en la transición energética mundial

Contra las fake news, se pide trabajar en marcas de agua y sistemas que detecten la procedencia de la información, así como "un sólido ecosistema de auditoría y certificación, responsabilidad por daños causados por IA, e instituciones bien dotadas para hacer frente a las dramáticas perturbaciones económicas y políticas (especialmente en la democracia) que provocará la IA", dice la carta.

En pleno ojo del huracán, como el mismo ha tuiteado, Sam Altman, CEO de Open AI, está de acuerdo con que hace falta un marco regulatorio global y democrático para que la AGI (Inteligencia Artificial General) tenga un buen futuro, así como la coordinación entre la mayoría de agentes en la industria y capacidad técnica para "alinear una superinteligencia", es decir, que persiga los objetivos marcados por sus desarrolladores y no otros. No entra, por el contrario, en si estos objetivos se deben conseguir a la vez que evoluciona y se usa la tecnología o si es preferible hacer una pausa para recapacitar.

También te puede interesar...

- Así puedes conectar WhatsApp con ChatGPT para charlar con la IA de la que todo el mundo habla

- Ion, la inteligencia artificial que entra por primera vez como consejera en un Gobierno

- Esta inteligencia artificial te muestra cómo hubieses sido en diferentes periodos de la historia

- Esta inteligencia artificial puede leer tu mente y descifrar tus sueños con una simple resonancia