Apple Vision Pro Omicrono

Apple leerá tus labios: patenta un sistema para que Siri reconozca tus palabras sin micrófono

Una patente revela como prentende Apple leer los movimientos de la boca con los sensores en sus dispositivos como las Vision Pro o los AirPods.

4 agosto, 2023 09:40Los futuros dispositivos de Apple que lleguen a España podrían leer los labios para que Siri y otros sistemas nunca tengan dificultades a la hora de entender las órdenes de los usuarios. Una nueva patente de la compañía revela este objetivo que reúne algunas de las grandes apuestas en las que está invirtiendo Cupertino actualmente como las gafas de realidad aumentada Vision Pro y el uso de la inteligencia artificial, aunque algunos analistas aseguren que su IA aún está por detrás de la competencia.

Con la inteligencia artificial generativa en la que Apple afirma que lleva tiempo invirtiendo, se espera que mejoren las conversaciones que los usuarios tienen con Siri, su asistente virtual, entre otros usos, como su propio chatbot GPT. No obstante, faltaría mejorar la comprensión de Siri a las diferentes pronunciaciones y formas de vocalizar de cada persona.

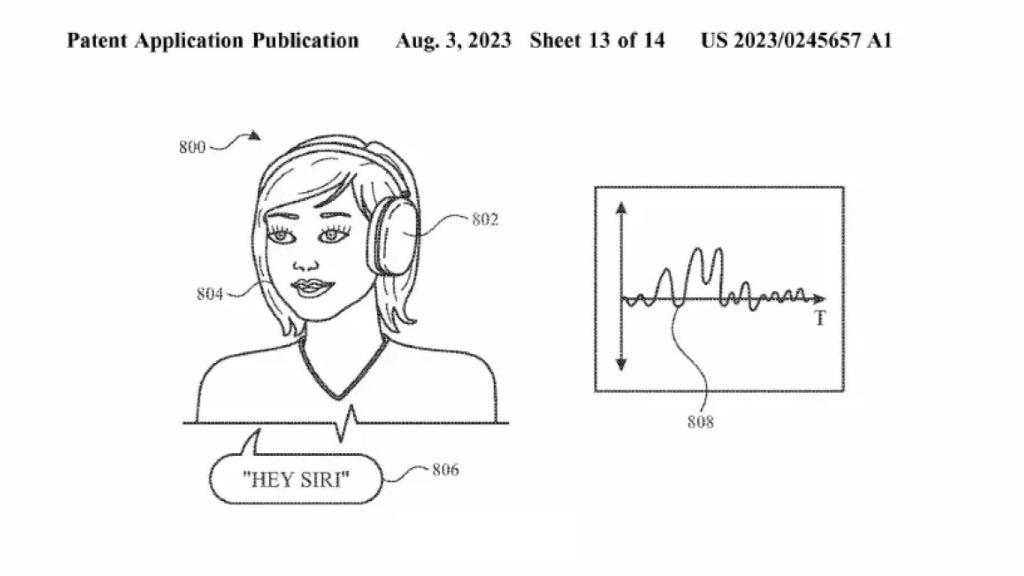

En una patente presentada recientemente, Apple describe un sistema capaz de relacionar los "datos de movimiento" con una palabra o frase. Los movimientos faciales, junto con el reconocimiento de voz, facilitarían entender mejor los comandos de voz como "Oye, Siri, siguiente canción" desde ciertos dispositivos como las gafas de realidad aumentada, e incluso, auriculares como los AirPods.

Las intenciones de Apple llegan hasta el punto de aspirar a apagar el micrófono del dispositivo, pero seguir comprendiendo ciertas palabras clave del usuario como 'Siri' para actuar en consecuencia, encendiendo el micrófono al tiempo de oír el resto de la orden. La empresa explica que este sistema consume menos energía en comparación con los micrófonos y el procesamiento del audio lleno de ruido que falla tantas veces cuando se intenta activar el asistente.

La idea, por si alguien lo está pensando, no es usar cámaras que graben la cara de la persona, sino usar sensores de movimiento. "Cuando un usuario habla, la boca, la cara, la cabeza y el cuello del usuario se mueven y vibran", se puede leer en la patente, informada por AppleInsider por primera vez. "Los sensores de movimiento, como los acelerómetros y los giroscopios, pueden detectar estos movimientos y consumen relativamente poca energía en comparación con los sensores de audio, como los micrófonos".

Patente de Apple Omicrono

De esta forma, la función parece restringida a aquellos equipos situados en la cabeza de la persona como las nuevas gafas de realidad aumentada que se han diseñado cargadas de sensores para recrear la cara del usuario en videollamadas o seguir el movimiento de las manos. También en futuros auriculares que desde las orejas descifrarían el movimiento de los músculos del cuerpo.

Para ello, Apple deberá analizar un gran conjunto de datos sobre los movimientos que las personas realizan para pronunciar cada palabra, diferenciando también la pronunciación propia de cada hablante e idioma para la misma palabra. Es posible que se trate de un sistema de aprendizaje profundo, como los que el gigante tecnológico afirma estar desarrollando intensamente de cara al próximo año y para competir con otras empresas que también están apostando fuerte por esta tecnología. Queda esperar para saber si la patente llega a materializarse o se olvida en un cajón.