Editando una fotografía tomada en un iPhone Omicrono

Apple prepara una revolución en el iPhone: una IA para editar fotos con simples descripciones

El gigante de la tecnología se está volcando con la IA: su último modelo generativo pretende competir con las herramientas de Google o Microsoft.

8 febrero, 2024 14:07Apple no ha sido hasta ahora un agente de peso en el desarrollo de la inteligencia artificial generativa, en comparación con Microsoft, Meta, Google y OpenAI. Sin embargo, en el último año se está volcando en esta tecnología en lo que promete ser una revolución para sus dispositivos y la experiencia de los usuarios en España y todo el mundo. El último movimiento de la empresa de Cupertinoen ese sentido es la presentación de un modelo que permite modificar fotografías con una simple descripción.

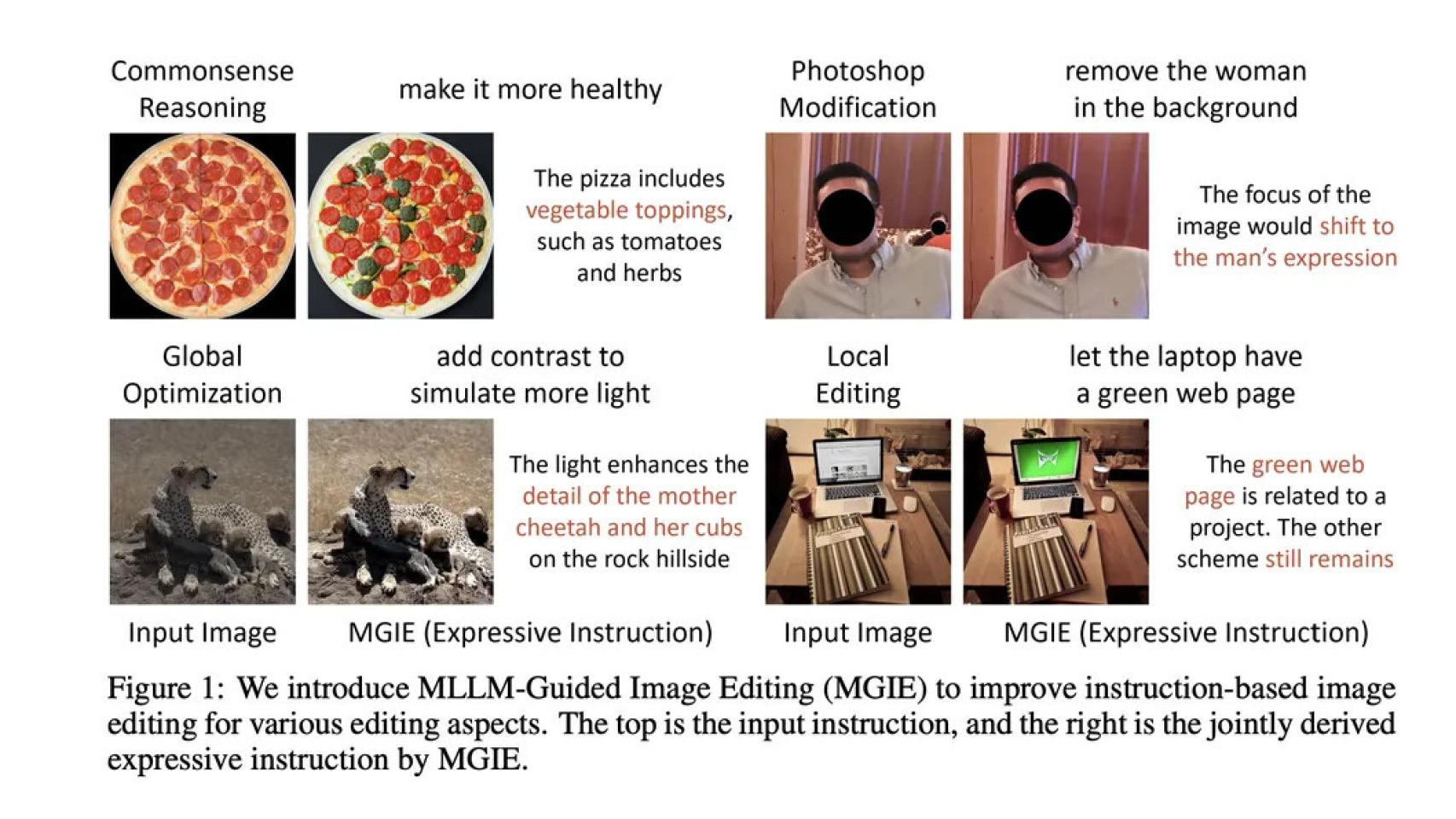

"Elimina a la mujer que aparece de fondo", "añade más luz a la imagen", "haz que este plato parezca más sano"... son sólo algunas de las peticiones que se le pueden hacer a MGIE. Apple ha trabajado en este modelo de inteligencia artificial generativa con la Universidad de California en Santa Bárbara y lo ha compartido públicamente a través de GitHub.

De momento, el fabricante de los iPhones no ha revelado que tenga otros planes para este modelo, más allá de la investigación de código abierto. No obstante, parece un modelo generativo pensado para que en el futuro los usuarios puedan editar más fácilmente las fotografías que toman con las cámaras de sus iPhones o iPads. En pocos segundos y con una sencilla descripción, la imagen puede ser muy diferente.

Ejemplos de MGIE para editar imágenes a partir de texto Omicrono

Apple estaría tratando de ponerse al día frente a otras plataformas de generación de imágenes como DALL-E 3 de OpenAI, que también pueden modificar contenido ya creado o generar uno nuevo a partir de texto. Estas funciones están llegando a los buscadores con Bing de Microsoft o Gemini de Google, también a ordenadores y móviles con aplicaciones como Photoshop de Adobe.

"En lugar de una guía breve pero ambigua, MGIE deriva una intención visual explícita y conduce a una edición de imágenes razonable", explican los investigadores en el artículo. "Creemos que el marco guiado por MLLM puede contribuir a futuras investigaciones sobre visión y lenguaje".

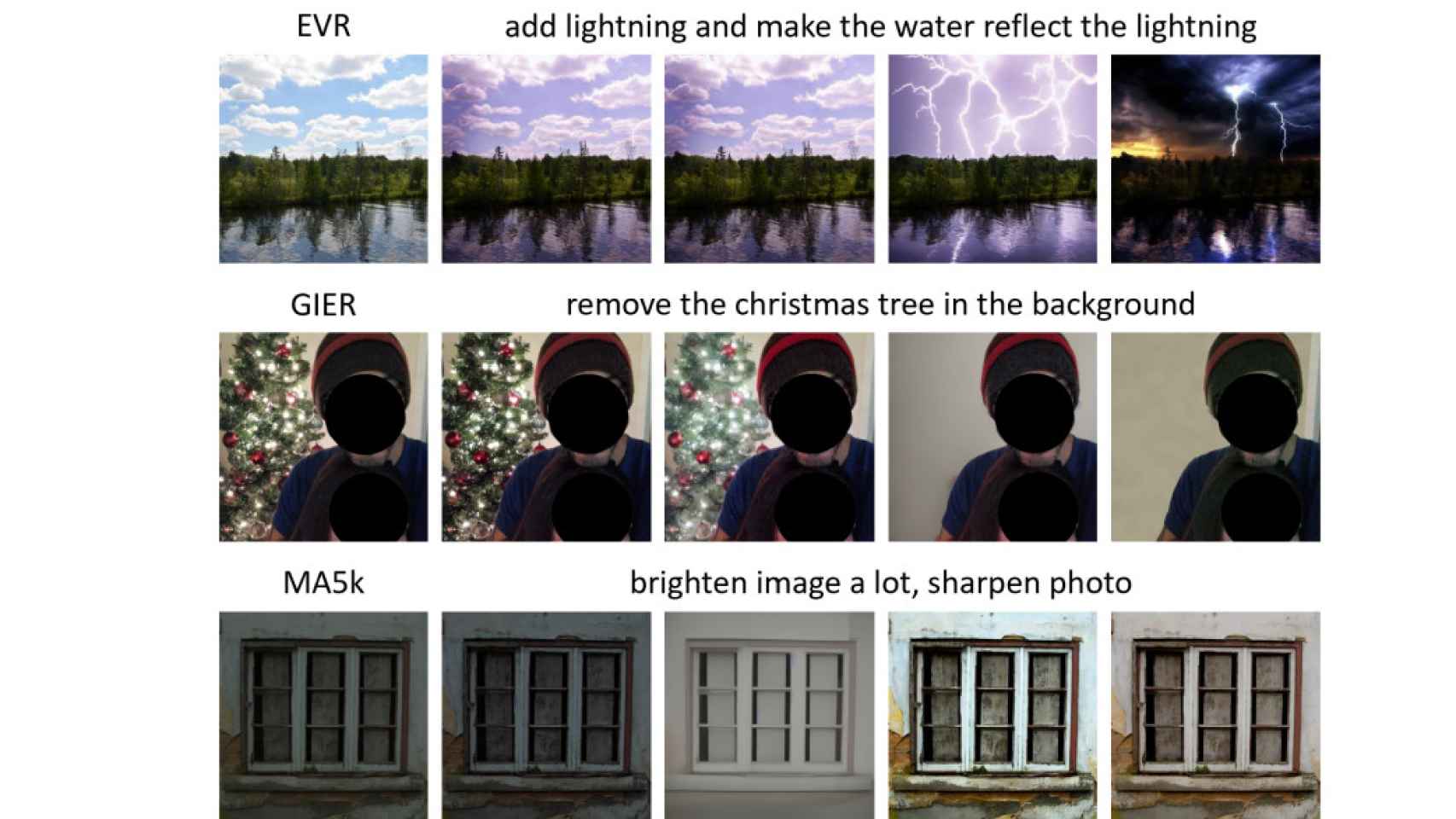

Ejemplos de lo que puede hacer MGIE Omicrono

Apple ha publicado MGIE a través de GitHub para que cualquiera pueda descargarlo, pero también ha lanzado una demostración web sobre Hugging Face Spaces, informa VentureBeat. El modelo combina dos usos diferentes de lenguaje multimodal: uno para interpretar las indicaciones del usuario y otros para "imaginar" cómo sería la edición de la imagen.

Entre los ejemplos que aporta el artículo se puede ver cómo las modificaciones van desde tareas simples, como aclarar una imagen, hasta más complejas, como cambiar el glaseado de un donut de chocolate a fresa y que resulte creíble. También consigue editar un paisaje de día soleado en una tormenta nocturna con rayos. Sólo cabe imaginar el potencial de esta herramienta en millones de móviles a los que solo hay que darles una indicación por voz o texto para cambiar toda la foto.

También te puede interesar...

- Apple quiere que Siri supere a ChatGPT: invierte 1.000 millones de dólares al año en su propia IA

- Apple estaría probando hasta cuatro modelos de IA para preparar su revolución para Siri

- El creador de ChatGPT y el exjefe de diseño de Apple planean crear un nuevo dispositivo basado en IA