Amazon Trainium2 Omicrono

La revolución de IA en la que trabaja Apple vendrá de la mano de los chips de Amazon: así son los nuevos Trainium2

- Apple utilizará los nuevos chips Trainium2 que prometen potenciar el entrenamiento de IA, más rápido y utilizando menos energía.

- Más información: Así es Amazon Nova, la familia de modelos de IA capaz de generar imágenes y vídeos con gran rapidez

En 2025 está previsto que lleguen a la Unión Europea y, por extensión, a España, las funciones de inteligencia artificial que Apple ha integrado en sus iPhone con Apple Intelligence. Estas novedades, entre ellas la nueva Siri, deberán seguir creciendo y mejorando a lo largo del tiempo. Para ello, es necesario el desarrollo y entrenamiento de la IA y los grandes modelos de lenguaje en los que se basa. Apple ha entrado así en la frenética carrera de la inteligencia artificial y para la que está utilizando los chips de Amazon.

Los procesadores de IA de Amazon Web Services son los encargados de dar vida a esos grandes modelos de lenguaje, (Large Language Models o LLM, en inglés) en los que Apple está trabajando. Así lo ha explicado, Benoit Dupin, director sénior de aprendizaje automático e inteligencia artificial de Apple a CNBC durante la conferencia re:Invent 2024 de Amazon Web Services (AWS), celebrada en Las Vegas.

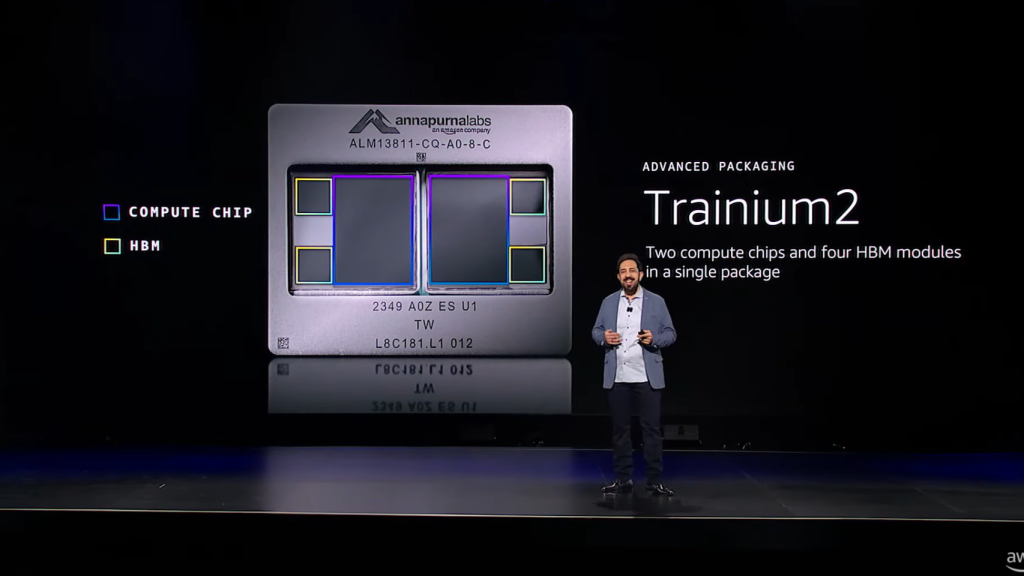

En esta congregación, AWS ha presentado Nova, su nueva familia de modelos de inteligencia artificial multimodales. Pero también ha dado a conocer su última generación de chips de IA, Graviton4 y Trainium2: los primeros enfocados a mejorar sus servicios en la nube, los segundos centrados en el entrenamiento de IA que servirán a Apple en sus propósitos.

La IA de Apple

No es habitual que Apple colabore en la promoción de alguno de los servicios que utiliza de otras empresas. En esta excepción, Dupin ha recordado que el fabricante de iPhones lleva más de una década utilizando los servicios de la nube de Amazon para su asistente virtual, Siri; Apple Maps y Apple Music. Por ejemplo, los chips Inferentia y Graviton de Amazon habrían ofrecido un incremento de la eficiencia en las funciones de búsqueda de los servicios de Apple del 40%, según Dupin.

De cara al entrenamiento de modelos de inteligencia artificial propios de Apple con los que nutrir su nueva suite de funciones, Apple Intelligence, la compañía de Cupertino sugirió que podría utilizar el chip Trainium2 de Amazon. Estos chips están ahora disponibles para alquilar.

A principios de este año, Apple dijo en un documento de investigación que había utilizado los chips TPU de Google Cloud para entrenar su servicio de inteligencia artificial del iPhone, al que llama Apple Intelligence.

La gran mayoría de la industria en torno a la IA está recurriendo a los chips de Nvidia para entrenar primero y ejecutar después sus modelos de lenguaje natural o de otra tipología. El fuerte crecimiento de la demanda de estos procesadores ha llevado el mercado de chips a una situación compleja en el que la oferta disponible no es suficiente. Los principales desarrolladores se plantean alternativas como OpenAI que valora crear su propio chip.

Chips Trainium2

Anunciados a principios de año, los recién llegados chips Trainium2 (T2) son cuatro veces más rápidos que sus predecesores. Solo 16 chips T2 proporcionarán hasta 20,8 petaflops de rendimiento computacional. Con estas cualidades, el chip se implementará en Amazon EC2 Ultra Clusters de hasta 100.000 chips, donde entrenar modelos básicos (FM) o grandes (LLM) con billones de parámetros.

Breakthrough training & inference performance—now on the menu. 🍽️🧑🍳🚀

— Amazon Web Services (@awscloud) December 3, 2024

Amazon EC2 Trn2 instances & Trn2 UltraServers are the most powerful EC2 compute options for LLM training & inference performance. Deliver results with #AWS. #AWSreInvent

👉 https://t.co/5O3nJsRD4N pic.twitter.com/SH7LxQVXL8

Amazon ha asegurado que sus clientes podrán entrenar modelos de 300.000 millones de parámetros en cuestión de semanas y no meses. El propio gigante de las compras utilizará sus instancias formadas por dieciséis chips cada una para entrenar sus modelos de la mano de la compañía Antropic que ha creado Claude, uno de los principales rivales de ChatGPT.

Por su parte, Graviton4 sería capaz de proporcionar un 30% más de rendimiento informático y un 75% más de ancho de banda de memoria que su generación anterior. Este procesador está enfocado a mejorar las cargas de trabajo de los clientes que utilizan la nube de Amazon, no para el entrenamiento de IA.

Amazon también ha aprovechado esta conferencia llena de anuncios para adelantar su próxima generación de chips, los Trainium3. AWS espera ofrecer con ellos otro aumento de rendimiento de cuatro veces superior a los nuevos T2 para sus UltraServers. Construidos sobre un proceso de 3 nanómetros, se presentarán a finales de 2025, una espera muy corta, aunque aún no se sabe cuánto tardarán en estar disponibles.