La 'robotista' colombiana María Vélez imparte una conferencia en la sede de CA Technologies en Santa Clara (EEUU).

Tecnológicas

¿Ética para robots? El reto ahora es hacerlos seguros

La 'robotista' María Vélez y el investigador en inteligencia artificial Víctor Muntés subrayan que el problema más inmediato es la comunicación en un "ambiente de ambigüedad"

28 junio, 2018 07:00En cuanto se produjo el primer accidente con víctimas de un coche autónomo (es decir, robótico) saltó el debate sobre la ética que debe gobernar las inteligencias diseñadas por el hombre. Ahora el debate se multiplica: Microsoft establece puntos éticos ineludibles para implicarse en un proyecto con inteligencia artificial (IA), la Comisión Europea se reúne para hablar de ello con grupos filosóficos no confesionales...

La ocasión de conversar a la vez con una robotista y un investigador en IA es la oportunidad de lanzar una pregunta nada ingenua: ¿hay que reescribir para el mundo real las tres leyes de la robótica que inventó literariamente Isaac Asimov?

"Para muchos de los que trabajamos en esta área, el trabajo de Asimov es lo máximo a lo que podríamos llegar: un robot al que se siente como humano, que piensa y tiene una personalidad... La realidad es que estamos muy lejos", replica María Vélez Rojas. "Asimov nos dio la visión, pero se olvidó de decirnos el cómo [se crea un cerebro positrónico]", apostilla Víctor Muntés Mulero.

"Lo más complicado es crear un sistema de inteligencia capaz de entender un ambiente tan ambiguo como el entorno en que nos movemos los seres humanos", añade Vélez. "Se crean modelos muy específicos, basados en el tipo de sensores que los robots tienen disponibles. Y ahí está el problema. No podemos pasar de un modelo a otro. Estos modelos dependen de cómo los entrenamos y cómo podemos asegurarnos de prever el tipo de situaciones que cubran todo lo que creemos que puede ocurrir en ese ambiente".

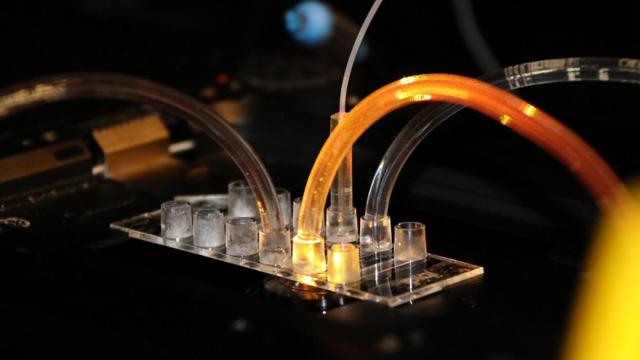

La colombiana Vélez Rojas trabaja en el desarrollo de cobots, robots colaborativos, en la sede de CA Technologies en Santa Clara, California. El español Muntés Mulero investiga IA en los laboratorios de la compañía en Barcelona. Son trabajos diferentes, pero muy interrelacionados. Ambos charlan con INNOVADORES en el Build to Change Summit de CA en Silicon Valley.

"Estos cobots son colaboradores. Nosotros [los humanos] lideramos los procesos, ellos nos ayudan. Es más un partnership que tener un robot que hace todo él solo", aclara Vélez. Su trabajo se centra en la relación entre máquinas y personas que trabajan en el mismo ambiente, cómo interactúan y se entrecruzan.

"Se puede tratar de máquinas que hacen tareas repetitivas, como brazos robóticos; otras informan, como drones y sistemas de sensores; o son semiautónomas, como las que se pueden mover por un almacén tomando decisiones parciales. Se trata de hacer robots seguros, que no se choquen con las personas. Si el robot comete un error con un humano en la habitación puede ser mortal. Tenemos que aprender cómo interactuar con sus errores, cómo nos comunicamos con ellos, qué parte de lo que hacen vale y por qué".

Vélez cita como trágico ejemplo el vuelo 447 de Air France (1 de junio de 2009) que se estrelló en el Atlántico: el piloto automático recibió información errónea de sus sensores y los pilotos humanos no supieron cómo enmendarlo. "Los humanos podemos adaptarnos a ambientes que nunca hemos visto, solucionar problemas a los que nunca nos hemos enfrentado. Es la esencia de lo que nos hace fundamentales en el sistema".

Es decir, está muy lejos el humanoide metálico inteligente con el que fantasea la ciencia ficción. "Ese es mi sueño", dice risueña Vélez. "Lo que hay ahora son muchos bots muy sencillos. En los de última generación todas las conexiones están dentro del cuerpo. Esto ayuda mucho, porque puede moverse por ambientes donde hay, por ejemplo, muchas sillas y estamos seguros de que no se va a quedar atascado. Es un aspecto muy básico, pero ahí estamos".

Otra cuestión es la comunicación y la capacidad de la máquina para "discriminar la ambigüedad" en una frase. «Hay otro tema que no es simplemente lingüístico: la interpretación de la intencionalidad", añade Muntés. "Por ejemplo, la ironía. Puedes decir cosas de manera irónica y si el robot no lo interpreta puede llegar a hacer cosas que... Hay muchos pasos antes de permitir que un robot sea controlado con algo tan ambiguo como el lenguaje humano".

"En este momento Alexa [asistente digital de Amazon] y todos estos sistemas interpretan las palabras, las reconocen, pero no interpretan la intencionalidad...", subraya Vélez. "¿Cuánta gente compró un juguete porque estaban pronunciando ciertas palabras? El sistema dijo ‘OK, vamos a comprar la casa de muñecas de mil dólares’. El lenguaje es difícil. Si Facebook no ha podido filtrar los mensajes escritos...".

El caso es que la charla empezó por plantear unos principios éticos para regir el comportamiento de los robots. "Se puede hacer inteligencia artificial que parezca humana, porque toma decisiones, pero si hablamos de emular pensamiento humano, estamos lejos. Muy lejos", concluye Muntés. "La IA de hoy en día no es una inteligencia holística completa. No son sistemas evolutivos que van creciendo. Está enfocada a resolver algún problema muy concreto".

¿Roadmap para la inteligencia?

"Hay investigadores que intentan definir cómo debería ser una estructura que emule nuestro pensamiento», dice Víctor Muntés. «Unos intentan reproducir un cerebro por sus conexiones. Otros, crear módulos de inferencia, de deducción, etc, que trabajen juntos… Pero no está claro qué mecanismos usa el cerebro para pensar".