La confluencia de la desinformación online y unos viciados sistemas de recomendación.

Tecnológicas

Ignorancia online: así se fabrica, así se combate

A medida que la tecnología se integra en cada parte de la sociedad, emergen vulnerabilidades con las que debemos lidiar. Así es como internet ha permitido la creación de un sofisticado sistema de manufactura de la ignorancia. Es la era de la agnotología de masas

29 mayo, 2019 07:00Saber que sabemos lo que sabemos y saber que no sabemos lo que no sabemos; ese es el verdadero conocimiento", dijo hace más de 400 años el astrónomo Nicolás Copérnico, padre del heliocentrismo. Su célebre frase, queriéndolo o no, no es más que otra forma de expresar lo que el filósofo chino Confucio había dicho casi 2.000 años antes: “El verdadero conocimiento es conocer el alcance de nuestra ignorancia”. La frase está más vigente que nunca en una época en la que lo digital ha dado lugar a la nueva era de la agnotología de masas.

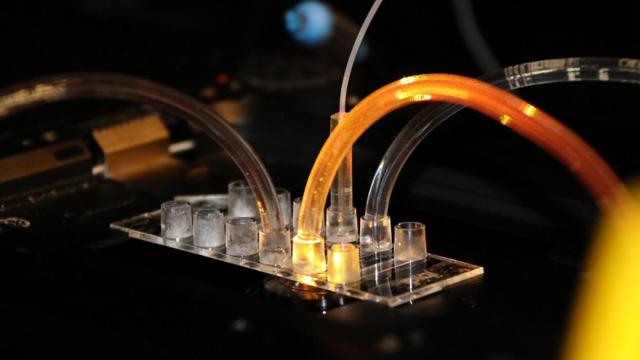

La agnotología es el estudio de cómo se fabrica la ignorancia, de lo perdido y de lo olvidado. El concepto lo acuñó el historiador social de la ciencia Iain Boal en 1992 y lo popularizaron más tarde los profesores de la Universidad de Stanford Robert Proctor y Londa Schiebinger en su libro Agnotología: La construcción y destrucción de la ignorancia (2008). En el siglo XXI, la confluencia de la desinformación online y de unos viciados sistemas de recomendación que convierten a internet en cámaras de eco personalizadas dan lugar a la manufactura y propagación exponencial de la ignorancia. ¿Cómo ha sucedido? ¿Podemos hacer algo para frenarlo o para neutralizar sus efectos?

“Poco a poco, y sistemáticamente, un virus se ha propagado, usando tecnología para desgarrar sistemáticamente el tejido social de la vida pública”, aseguraba la fundadora y presidenta Data & Society, Danah Boyd, en una charla el pasado abril. Boyd -también investigadora social en Microsoft Research- explica algunas de las tácticas para lo que define como “la fabricación estratégica de la ignorancia” mediante la perversión de las herramientas de producción de conocimiento.

El fin es lograr la fragmentación epistemológica, es decir, cómo sabemos lo que sabemos, o cómo accedemos al conocimiento. Una estrategia puede ser crear términos ex profeso. Boyd comenta cómo Frank Luntz -asesor del partido republicano en EEUU- hizo esto con términos como el ‘impuesto a la muerte’ (en lugar de impuesto de sucesiones) o ‘cambio climático’ (en lugar de calentamiento global). Para lograr que permeasen, creaba primero un mundo de contenido que acababa llegando a los medios de comunicación en el momento adecuado para que, cuando alguien buscase el término, obtuviera un resultado específico. “Al explotar la falta de información, los manipuladores mediáticos contribuyen a fragmentar el conocimiento y generar dudas”, afirma.

La luz de gas es otra táctica frecuente. Es en un tipo de manipulación que trata de provocar que otra persona (o grupo de personas) cuestione su propia realidad, memoria o percepciones. A menudo, el engaño consiste en tratar de convencer de la existencia de un hecho falso, y de la no existencia de un suceso real. Si bien este procedimiento es un clásico entre dictadores, narcisistas, líderes de culto y abusadores, su uso se extiende a todo tipo de actores en el mundo online. Muchas personas conocedoras de la historia y comprometidas con la toma de decisiones basada en la evidencia -afirma Boyd- están experimentando una sensación colectiva de ser víctimas de esta oscura maniobra.

Si bien la estrategia no es nueva ni propia de internet, este canal de distribución masiva facilita su propagación y potencia su efecto. Y basta con poco: sembrar la duda es suficiente. “Una de las mejores formas es asegurarse de que sea más fácil acceder al contenido dudoso y conspirativo que al material científico”, explica la investigadora. Lo siguiente es socavar la información científica disponible para que, de llegar hasta ella, pierda al menos en parte su credibilidad. Un método para ello es explotar los "vacíos de datos": áreas dentro de un ecosistema de búsqueda donde no hay datos relevantes.

Fragmentar la verdad

Las noticias de última hora son un ejemplo. Otro -igualmente peligroso- es cooptar un término abandonado o desgastado, como la justicia social, y darle un nuevo significado. Boyd pone un ejemplo con YouTube. Si buscamos en la plataforma de vídeo las palabras “social justice” (justicia social en inglés) el primer resultado que aparece es de PragerU, una organización conservadora cuya misión es contrarrestar las, a su juicio, “ideas izquierdistas” que se enseñan en las universidades. El video está bien producido, contiene muchos de los principios de la alfabetización mediática y plantea cuestiones difíciles para hacerlo creíble. Sin embargo, en realidad ofrece una visión parcial y ligeramente conspirativa de lo que es la justicia social. El propósito es, en realidad, denostar este término y reprimir su uso.

Si sigues viendo vídeos, llegas al activismo de los guerreros de la justicia social, antifeministas y homófobos. Lo mismo sucede al buscar vídeos de salud. Incluso aunque acudas a la página de una organización con autoridad y científicamente respaldada, casi siempre aparecerá en la rueda de recomendación un vídeo conspiranoico, ya sea antivacunas o promotor de cualquier pseudociencia. ¿Por qué? Porque las comunidades que están tratando de generar estas conexiones -explica Boyd- entienden cómo producirlas.

La asociación que hace que de un contenido ‘seguro’ se llegue a uno desinformativo o falso se puede producir de otras maneras, incluso a veces de forma involuntaria. A menudo son los medios quienes lo propician, al tratar de mostrar dos visiones contrapuestas -por ejemplo, provacunas y antivacunas- en un empeño erróneo por crear debate a partir de una falsa equivalencia. Conceder un espacio a personas que promueven información falsa y que toman posturas extremas envía una señal a YouTube de que ese contenido es relevante y será enlazado en las búsquedas de información, en este caso sobre vacunas.

De este modo, una persona que visita YouTube para obtener información razonablemente informada está expuesta a contenido marginal, extremista o conspirativo. Sus creadores afirman proporcionar una fuente de alternativa de información. Es lo que la investigadora Rebecca Lewis denomina ‘influencia alternativa’. A partir de un estudio de 81 canales de este tipo, Lewis ha comprobado que estos mezclan contenido de diferentes ideologías. Realizan una promoción cruzada de ideas que forma una posición reaccionaria más amplia, caracterizada por la oposición a la justicia social, al feminismo o al pensamiento de izquierdas.

La consecuencia -dice la investigadora- es que facilita la radicalización y la polarización, y también la banalización ideológica y la ausencia de empatía. “Es un tipo de contenido entretenido, rebelde y divertido que oscurece el impacto de las ideas que presentan en colectivos vulnerados o infrarrepresentados”, apunta Lewis, que sostiene que YouTube está diseñado para incentivar este comportamiento.

Boyd coincide con ella: “Las vulnerabilidades de la arquitectura de YouTube permiten, a quien se lo proponga, modelar conocimiento público de manera profunda”, afirma. Una red social que, para los menores de 25 años, es el pan de cada día: su MTV, su buscador, su sistema de recomendación, su red social, el lugar donde comienzan a consumir noticias. “Piénsalo. Es normal que el youtuber más visto sea un videojugador [prefiere no mencionar su nombre para no publicitarle] que comparte comentarios racistas y de odio a diario”, dice la experta.

Tejido social

¿Qué hacer? Boyd no cree que la respuesta sea eliminar el contenido extremo. Entre otras cosas, porque los creadores han aprendido a sortear los límites en zonas grises. La mayoría del contenido antivacunas no dice a la gente que no se vacune, pide que cuestionen si las vacunas son seguras o no. Ese es el proceso: sembrar la duda. Y es mucho más difícil hablar de eliminación con contenido centrado en la duda. “Las plataformas son sensibles a esto porque no quieren ser vistas como políticamente parciales o contrarias al diálogo”, comenta la investigadora.

El problema con estas rutas es que la mayoría de ellas no son ciertas ni falsas en su totalidad. Son argumentos para dudar de una línea particular de pensamiento. Y, en el proceso, llevarán a información cada vez más extremista. Más que hacer desaparecer el contenido, Boyd aboga por entender primero -y después cambiar- la dinámica que los refuerza y propaga. Que las plataformas modifiquen sus sistemas de recomendación y no premien el despliegue estratégico de la duda y el pensamiento conspirativo. Lewis va más allá. Cree que estas no solo deben evaluar el contenido sino con qué enlaza, quién comenta y cómo se mueve en otras plataformas y redes sociales, dado que el entorno de medios online es una estructura de redes en red.

Las plataformas deben pensar responsablemente sobre su papel como amplificadores, como potenciadores del vínculo entre curiosidad y extremismo. ¿Quién decide qué debe enlazarse y qué no? ¿Qué es conspirativo y cuál es la legítima diferencia de opinión? ¿Cuándo se debe evitar exponer diferentes perspectivas? ¿Cuándo es apropiado exponer a las personas a nueva información? ¿Es una forma de hacer proselitismo? ¿Es un acto de poder que hay que impugnar?

“Google no está diseñado para ser liberal o conservador. Tiene una epistemología que asume que el conocimiento está dentro de los datos. Funciona bajo el supuesto de que las personas harán clic para acceder a ese contenido, no simplemente a los titulares. Esta es una falacia contra la que luchamos”, afirma Boyd. No es solo que las personas solo lean los titulares, sino que también siguen el mundo a través de las notificaciones en su teléfono, enviadas desde Twitter, Facebook o Instagram. Eso -dice- es lo que los manipuladores saben cómo explotar.

Esto hace que sea crítico pensar cómo van a salir las cosas mal para evitarlo o para solucionarlo. Pero, sobre todo, hay que mirar más allá de las propias plataformas y sus algoritmos. La tecnología se centra en la abstracción, la generalización, la escala y el crecimiento. Sabe cómo universalizar, no cómo llegar a la raíz de las comunidades locales. Cuanto más se abstraiga y generalice todo, más dividida estará la sociedad, sostiene la fundadora de Data & Society. “Las guerras culturales de hoy no fueron creadas por la tecnología, incluso si son amplificadas por ella. Están arraigadas en la fragmentación epistemológica, que a su vez fractura el tejido social”, afirma.

Es difícil construir una sociedad con personas que comparten diferentes entendimientos del mundo que nos rodea. Unir a las personas a pesar de sus diferentes epistemologías -religiosas, ideológicas o de cualquier tipo- es un proyecto social con el que los países han luchado una y otra vez, sostiene Boyd. Pero es absolutamente crítico construir ese tejido social. Pensar en las comunidades en las que todos vivimos y en la información como un elemento que une a esas comunidades. Un elemento más junto con programas y proyectos que reúnan a las personas. Y eso -concluye- no sucederá en las redes sociales.

El estudioso de la ignorancia David Dunning, de la Universidad de Cornell (EEUU), sostiene -como Boyd- que internet está ayudando a propagar la ignorancia. “Nos hace presa de poderosos intereses que desean amplificarla deliberadamente. Mi preocupación no es que estemos perdiendo la capacidad de tomar nuestras propias decisiones, sino que se está volviendo demasiado fácil hacerlo. Algunas personas inteligentes se beneficiarán de toda la información disponible con un solo un clic, pero otras serán engañadas por un falso sentido de experiencia", advierte.

Un estudio publicado en Nature Communications constata que la capacidad de atención global se está reduciendo debido a la sobrecarga de información online. La necesidad de novedades hace que cambiemos colectivamente de un tema a otro de forma más rápida. Esto puede afectar a la capacidad de evaluar la información que consumimos o a la calidad de la información, dada la imposibilidad para los periodistas de estar al tanto de todo.