Ley de Moore

Rompiendo las barreras del diseño de procesadores: ¿Está la Ley de Moore obsoleta?

Noticias relacionadas

- Airbus presenta un avión con las alas de un ave de presa, ¿el futuro de la aviación?

- Mira cómo una estación espacial china cae a la Tierra destruyéndose en la reentrada

- Una estación espacial china va a caer a la Tierra, aquí es donde ocurrirá

- Crean una computadora dentro de un juego de construir ciudades... y funciona a base de caca

Precisamente fue un miembro de esta compañia, Gordon E.Moore cofundador de Intel, quién en 1965 formuló una ley que descibre la potencia con la que avanzan los ordenadores. En concreto la ley de Moore se refiere a la densidad de transistores que hay un circuito integrado, cuyo número se dobla al cabo de 18 meses. En realidad dijo en un principio 12 meses, luego rectificó y dijo 24, al final se ha quedado en 18, ya se sabe, problemas de que sea una ley observacional y no un verdadera ley científica.

Puede parecer chocante al principio, pues los ordenadores son más rápidos y más pequeños que nunca, pero el rendimiento del procesador simplemente no está avanzando al mismo vertiginoso ritmo con el que lo había hecho hasta ahora. De una generación para otra era común ver avances de hasta un 50 o un 60% de mejora, pero últimamente debemos conformarnos con un 10 o un 15%. La norma ha cambiado, y Moore nunca predijo que el aumento exponencial de la potencia de cálculo aumentara para siempre. ¿Ha llegado ya a su fin? Y más interesante, ¿por qué?

Es agradable poder ver como tu PC de hace unos años no tiene necesidad de actualizarse, y más si tenemos en cuenta la época en la que nos está tocando vivir, pero la tecnología debe avanzar más allá de lo que pueda interesar, el futuro necesita velocidad y mejoras.

El problema del consumo energético y posibles soluciones

La potencia necesaria para alimentar a nuestros pequeños y numerosos transistores aumenta a la par que tenemos más y más cantidad de ellos. Y siguiendo las inevitables leyes de la termodinámica nos encontramos que la temperatura llega a tal punto que se convierte en un factor limitante para seguir obteniendo mejores resultados.

La temperatura afecta al rendimiento de las siguientes dos maneras:

- El aumento de temperatura disminuye la velocidad del transistor.

- El aumento de temperatura aumenta las fugas en los transistores.

A nivel del transistor, el aumento de las fugas tiene diferentes orígenes, y por lo tanto para efectuar la reducción se requiere de una nueva integración en los procesos. Por un lado están los nuevos materiales a utilizar, otro aspecto es intentar reducir las fugas con un diseño inteligente o pensado especificamente para evitarlas como podría ser un sistema multi-Vt o las utilizadas SRAM y si te preguntas si esto tiene realmente sentido se ha comprobado que sí que existe una correlación entre el diseño de las configuraciones del transistor y la pérdida de energia por fugas.

Investigadores simularon la electricidad utilizada por más de 150 microprocesadores (lo más populares) y estimaron que para el 2024 la velocidad de computación aumentaría sólo 7.9 veces, en promedio. Por el contrario, si no tuvieramos los límites impuestos por la temperatura en la capacidad de los transistores, los resultados que podríamos obtener serían de casi 47 veces superior. Mucho trabajo por hacer en ese campo más allá que la de reducir el tamaño de los transistores.

Las soluciones pasan por como ya hemos dicho por los nuevos diseños, podría ser también la explotación del trabajo en paralelo. Esto lo vemos en los famosos núcleos de los procesadores, una manera de seguir conseguiendo una gran potencia sin tener que reducir los nanometros de los transistores aún más. En tema de materiales el dióxido de silicio se está substituyendo últimamente (y así lo vemos en muchos de chips ARM Cortex A15) por otro material menos propenso a tener fugas conocido como “high-k metal-gate”, el cual ha sido ya mejorado con la introducción de “tri-gate” o tecnología de transistores 3D en los actuales chips de Intel Ivy Bridge.

Y no solo el hardware tiene cosas por decir aquí, el software debe rendir a la altura. Herramientas como la plataforma CUDA de NVIDIA o la API de DirectX 11 para Windows y OpenCL como solución de código abierto son también opciones que los fabricantes tienen en mente para luchar contra la innovación e intentar estar a la altura que la ley de Moore requiere.

¿Qué opina Intel de todo esto?

Intel, la empresa que el propio Moore confundó sigue confiando y trabajando duramente para alcanzarla. Como los transistores están alcanzando ya tamaño casi infinitesimales, cada uno de los más de mil millones de transistores de 22nm que tiene el chip Ivy Bridge hacen que el diseño sea una cuestión que requiere grandes dotes de creatividad. Cuando trabajamos a nivel atómico no basta con apilar uno encima del otro los transistores y esperar a que funcionen todos a la vez sin fisuras.

En los más potentes procesadores comunes de Intel, existe la opción del Turbo Boost, que nos permite alcanzar frecuencias de reloj más altas justo cuando el sistema lo requiere, para volver a frecuencias más bajas (y por tanto con menos fugas por calor) cuando el sistema está en pausa. Este desarrollo lo hemos visto incluso en los modelos Atom, y una solución que Intel muestra claramente en su roadmap.

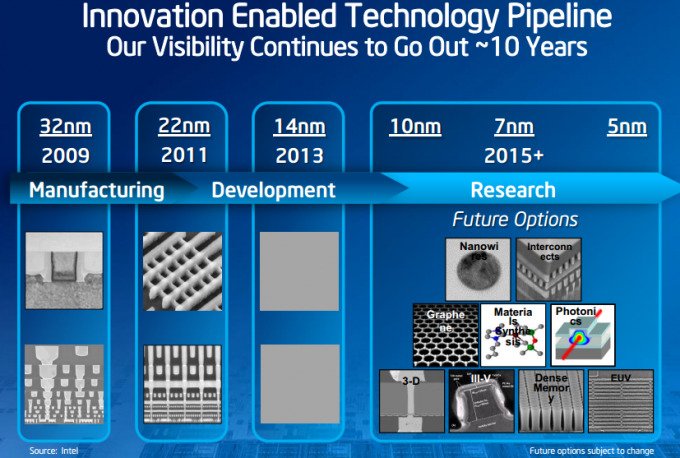

Precisamente es gracias a los roadmap (como el que tenemos justo debajo) que nos permiten hacernos una idea del estado y opciones que se plantean las compañias. Haswell (tock), el nombre de su siguiente y nueva arquitectura, nos ofrecerá un diseño realmente fino en su CPU y instrucciones mejoradas, con un tamaño de solo 14nm, pero de Skymont (10nm) aún no sabemos nada. ¿Seguiremos viendo mejoras del 10/15% al que últimamente nos acostumbra a mostrar Intel? ¿Nos tienen preparado una gran sorpresa para las siguientes generaciones?

intc101512a

En 2003, Intel predijo que el fin de la la ley de Moore llegaría entre 2013 y 2018 con un proceso de fabricación que estaría entre los 16nm y los 5nm, donde por efecto túnel y demás ingerencias cuánticas veríamos realmente dificultado el proceso, sin embargo en 2008 se revisó y aseguraron que la ley perduraría por lo menos otra década más.

Una técnica que se especula que podría utilizar Intel para la fabricación de sus nuevos transistores sería el proceso de fabricación de litografía ultravioleta extrema de nueva generación o nanolitografía. Mark Bohr, director de arquitectura de procesos aseguraba “Me gustaría tener EUV funcionado para los 10 nanómetros, pero no puedo garantizar que vaya a estar lista a tiempo”. Ojalá lo estén y podamos ver los resultados cuanto antes.

Según algunos analistas, Intel está pagando por la innovación de la industria de los chips y por intentar alcanzar la Ley de Moore, pues en algún momento habrá rendimientos decrecientes. Estos nuevos procesos y los cambios constantes de diseño son muy costosos, y tarde o temprano pasarán factura a Intel. ¿Tenemos alguna otra empresa capaz de ocupar su lugar?

El horizonte se presenta lejano

El final de la ley de Moore no es bueno para el PC, y en el intento porque no termine está buena parte de las esperanzas puestas en las expectativas de ventas durante los siguientes años. AMD tuvo grandes dificultades en la transición de 28 nanómetros de silicio a 20 nanómetros lo que demuestraba que habíamos llegado al principio del fin. Para diferenciarse AMD ha decidido apostar por el uso combinado de su CPU y GPU, las llamadas APU, que con un software que aproveche sus capacidades son una opción más a tener en cuenta, esperemos por su bien que no la ley de Wirth no sea cierta.

En abril de 2011, un equipo de investigadores de la Universidad de Pittsburgh anunció el desarrollo de un transistor de un solo electrón de 1,5 nanómetros de diámetro, hecho de materiales con base de óxido. En febrero de 2012, un equipo de investigadores de la Universidad de Nueva Gales del Sur anunció el desarrollo del primer transistor consistente en un solo átomo colocado precisamente en un cristal de silicio. Pero estos son solo dos ejemplos de que en los laboratorios de la universidades se trabaja; llevarlo a la producción a gran escala que requieren los grandes fabricantes es otra historia.

El futuro de los transistores puede basarse en una serie de tecnologías experimentales como el grafeno del que tanto se ha hablado, de la substitución del silicio por arseniuro de galio, la síntesis de nuevos materiales, la EUV que hemos hablado anteriormente, los trigates 3D de Intel o incluso soluciones más ambiciosas como los transistores moleculares o la computación cuántica.

Las arquitecturas heterogéneas son el camino del futuro. Quizás la ley de Moore pueda interpretarse de muchas maneras; “Todo lo bueno de las computadoras obtiene un orden de magnitud mejor cada cinco años. Entendiendo por orden de magnitud como un cambio tan grande que requiere nuevas maneras de pensar, nuevas conceptualizaciones: No es simplemente más, es diferente. La curva de rendimiento de hoy en día puede que se esté aplanando, pero el futuro nunca ha parecido tan bestial, tardarán en llegar, sí, pero las alternativas que se manejan son un salto cualitativo tan grande que es posible que la ley de Moore hasta se nos quede corta.