implante habla 2

Un implante y un nuevo algoritmo permiten hablar aunque no podamos mover la boca

Científicos han desarrollado un algoritmo para hablar sin mover la boca, generando palabras a partir de señales del cerebro.

Noticias relacionadas

- India lanza la misión que le puede convertir en el cuarto país en llegar a la Luna

- Tu nuevo fondo de pantalla ha sido posible gracias a una vela solar

- Duro como una piedra o blando como la gelatina: este material dinámico cambia con la iluminación

- Esta lengua electrónica puede "probar" y analizar líquidos en solo un minuto

Conforme los científicos comprenden mejor cómo funciona nuestro sistema nervioso, las posibilidades aumentan. El desarrollo de nuevas tecnologías como Inteligencia Artificial y el aprendizaje automático ha abierto la puerta a nuevos desarrollos para crear sustitutos de partes del cuerpo que dejan de funcionar.

El último ejemplo lo tenemos en el implante desarrollado por científicos de la Universidad de California San Francisco, que es capaz de devolver el habla a personas que la han perdido por problemas neurológicos; y para ello, se basa en comprender mejor la manera en la que nos comunicamos.

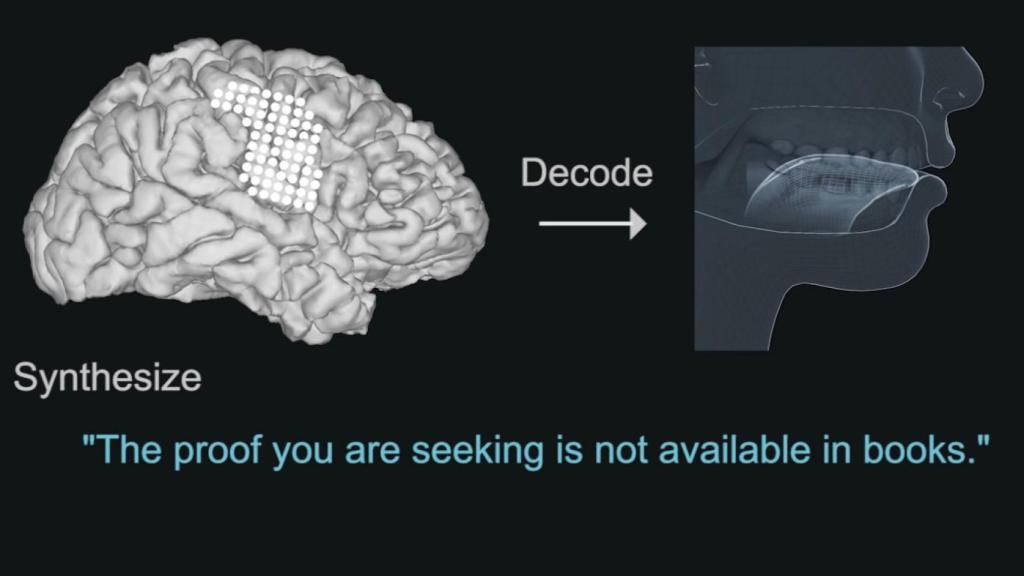

Un algoritmo permite hablar sin mover la boca

El proceso de hablar implica que el cerebro envía a los músculos faciales los movimientos exactos que deberíamos hacer para conseguir el sonido que queremos. Desde la mandíbula hasta la laringe, pasando por los labios, estamos hablando de unos 100 músculos; estos reciben las órdenes ya “descifradas”, y lo único que tienen que hacer es ejecutar los movimientos. El cerebro ya se ha encargado de “traducir” las palabras que está pensando a movimientos concretos.

A los investigadores se les ocurrió que podían aprovechar que el cerebro hace todo ese trabajo, para interpretar esas órdenes y ejecutarlas en vez de los músculos. Por ejemplo, en el caso de pacientes con trastornos neurológicos; que pierden la capacidad de hablar aunque el cerebro no la haya perdido. Siempre y cuando puedan seguir enviando las señales necesarias para mover esos músculos, es posible interpretarlas y generar palabras usando un ordenador.

implante habla 1

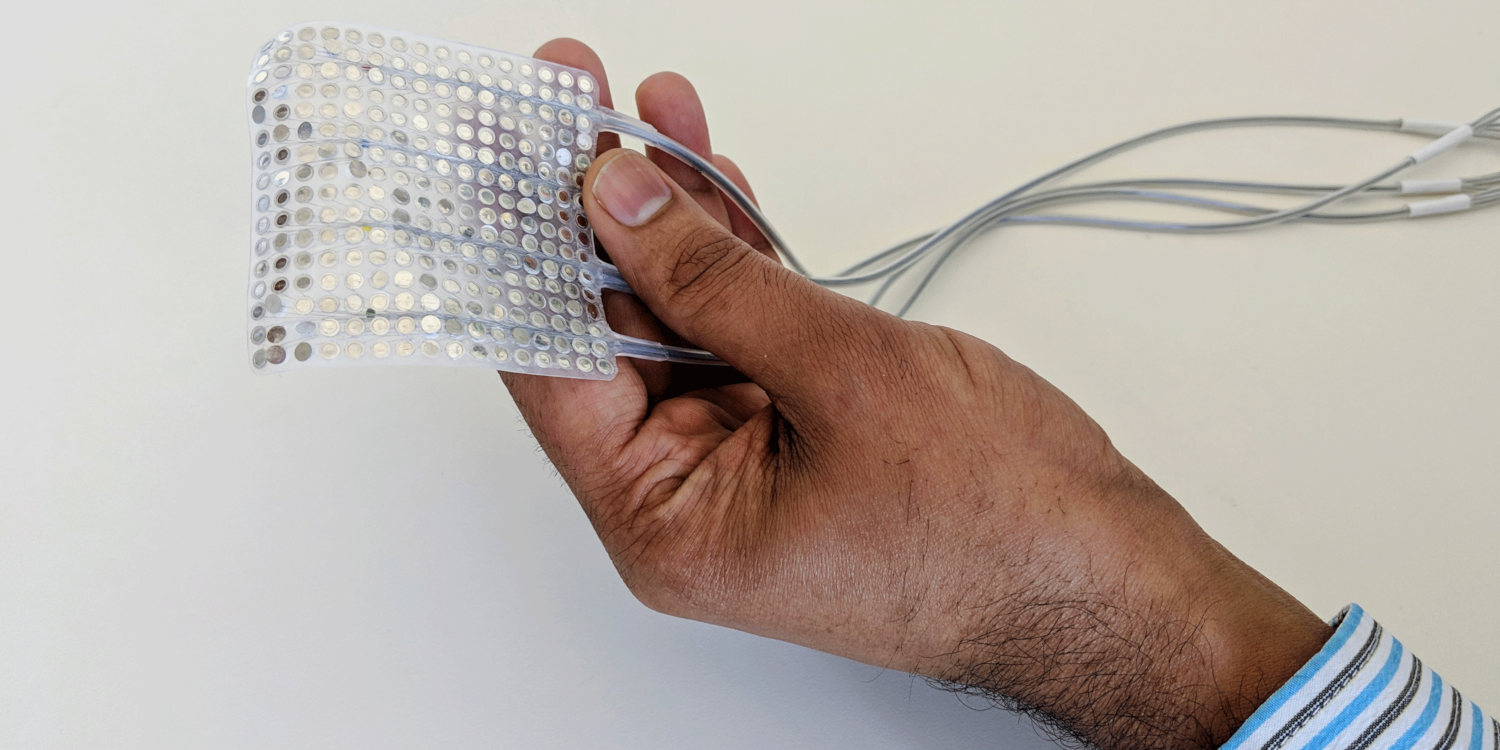

El proceso implica colocar un implante con electrodos en la superficie de la corteza motora del cerebro; en las pruebas, los voluntarios fueron pacientes que sufrían de epilepsia, a los que se les pidió que leyesen frases en voz alta que contenían todos los sonidos posibles en inglés. Los investigadores grabaron las señales que salían de la corteza motora durante este proceso.

Cuando un ordenador habla por ti

Interpretar estas señales es complicado, porque no se corresponden directamente con un músculo; es decir, no es una traducción tan simple como “si llega esta señal, mueve este músculo”. Aquí es donde entró el aprendizaje automático. Los investigadores desarrollaron un algoritmo y lo entrenaron con datos relacionados con el habla; en total, sólo 25 minutos de entrenamiento fueron necesarios, pero el algoritmo era mejor cuanto más tiempo se dejaba “estudiando”.

El algoritmo aprendió a generar palabras en base a las señales que se recibían del cerebro. El resultado fueron archivos de sonido generados automáticamente con las frases que los voluntarios habían dicho. Para comprobarlo, se hicieron pruebas con otros voluntarios, que debían identificar las palabras que decía el algoritmo de entre varias opciones. En los mejores resultados conseguidos, los voluntarios consiguieron transcribir el 43% de las palabras que escucharon.

El principal problema que se encontraron es con palabras que sonaban de manera parecida. En ese caso, el algoritmo no tenía la finura de una boca humana para los detalles, pero en muchas ocasiones la frase se entendía por el contexto. Desde luego, ya era mucho mejor de lo que una persona con Parkinson o ELA es capaz cuando su enfermedad está en estado avanzado. Por el momento, ese es el objetivo del proyecto, que personas que hasta ahora perdían el habla de manera irreversible la puedan recuperar.