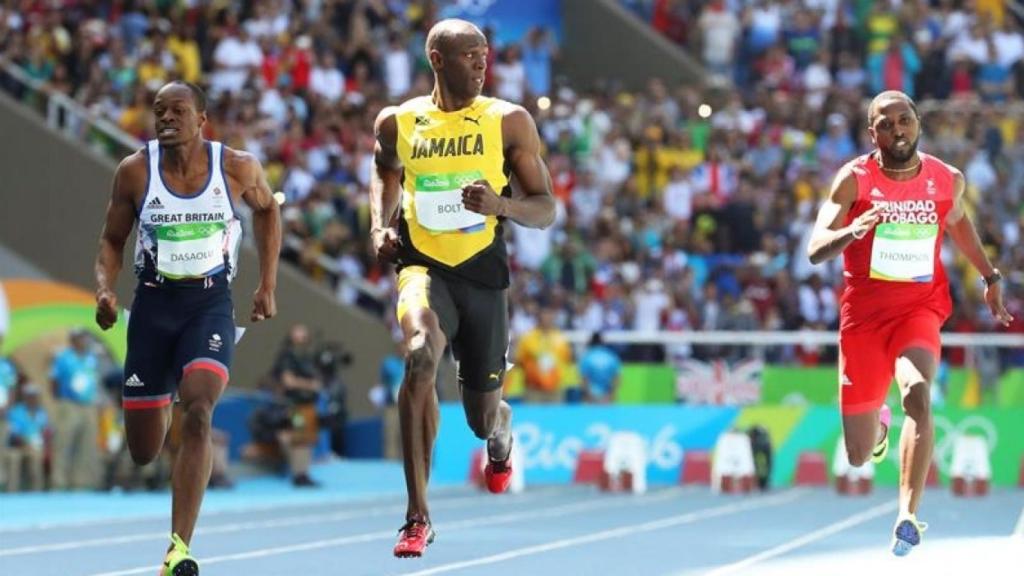

El anuncio de Pirelli en el que se hablaba de la potencia sin control.

Algoritmos sin control, un problema para todos

El autor propone controlar los algoritmos de caja negra, como el de la aplicación espía de La Liga, mediante una suerte de ITV informática.

"La potencia sin control no sirve de nada", decía un famosísimo anuncio sobre neumáticos. Y siempre me pareció un anuncio genial en lo visual y narrativo, de alto impacto e incorrecto. Como la experiencia de cualquier conductor avalaría, la potencia sin control conlleva un riesgo de multas o de accidentes, lo que es bastante peor que la nada.

Muchas de nuestras actividades digitales o con apoyo digital hacen un uso intensivo de algoritmos que emplean modelos generados mediante técnicas de aprendizaje automático, machine learning, a partir de grandes volúmenes de datos -big data-. Si los términos le resultan confusos, como al 99% de los mortales, quizá le sirva de algo la primera entrada del diccionario digital para noveles que escribí, perdón por la autocita.

Un algoritmo no es más que una secuencia de operaciones que realizan una función o resuelven un problema. Es básicamente una suerte de receta, que es lo que separa a los huevos y las patatas de la tortilla española.

Algunos problemas que surgen del uso de técnicas de aprendizaje automático son, por ejemplo, que los robots de conversación se convierten en agresivos y faltones; que las redes sociales exacerban nuestros peores defectos mediante las famosas cámaras de resonancia; que compramos compulsivamente en Amazon por su brillante motor de recomendaciones; que casi no pasamos de la primera página de los resultados del buscador…

El problema no es que sean muy eficaces, algo que nuestra experiencia avala y comparte sin problema. El problema es que no somos capaces de entenderlos ni de explicarlos. No es porque nos falte conocimientos o inteligencia, allá cada uno, sino que ni siquiera los expertos en la materia son capaces porque no se puede.

Se trata de técnicas de “caja negra”, es decir, sin posibilidad de escrutar o encontrar un racional o, para ser más precisos, un modelo causal que los explique. Esta característica de ininteligibilidad y adaptación continua, es decir irrepetibilidad, hace que, por ejemplo, los bancos no los puedan emplear para sus valoraciones de crédito. El supervisor bancario requiere que las puntuaciones de cada operación que justifican la aprobación o denegación de un crédito se basen en reglas explícitas, no discriminatorias, causales y previsibles lo que impide la aplicación de sistemas de aprendizaje automático. Esto es, en parte, una lástima, porque se mejoraría la gestión del riesgo. Pero también un alivio.

Es un alivio saber que cosas importantes que nos pasan en el ámbito institucional o empresarial se pueden justificar y están supervisadas. De ahí que, de cara a avanzar en el uso de sistemas de aprendizaje automático, debamos abundar en la máxima del famoso anuncio de neumáticos: introducir control, límites y verificaciones a los sistemas. Esto los hará menos eficientes y menos -digamos- puros, pero a la vez los hará más humanos, es decir, más justos.

Esto ya lo hemos vivido con anterioridad. En los albores de la moderna automoción se optó por limitar la velocidad de los vehículos en la vía pública, lo que enlentece los trayectos y deja de aprovechar toda la potencia de los motores, pero nos permite circular masivamente y con una seguridad creciente por las carreteras del mundo. Justicia antes que eficiencia.

En esa misma dirección deberíamos avanzar en el ámbito de los algoritmos, sobre todo en aquellos de caja negra. Algoritmos rodados, como los cantos fluviales, que comprueben que nuestros criterios básicos se cumplen.

Por ejemplo, un algoritmo de valoración del crédito de inteligencia artificial sería sin duda racista, ya que hay etnias con mayor morosidad que otras, y eso no lo podemos permitir. Hablamos de una suerte de IPA –Inspección de Principios de Algoritmos- , en reminiscencia de la ITV, donde a partir de entidades independientes se pudieran aplicar controles o test de caja negra comúnmente aceptados, donde ya hay una incipiente línea de investigación, que vayan abordando los diferentes retos o dificultades que pueden presentar, normalmente ligados a la discriminación o a la exclusión. Algoritmos rodados, menos eficientes, no óptimos, pero más humanos y más justos.