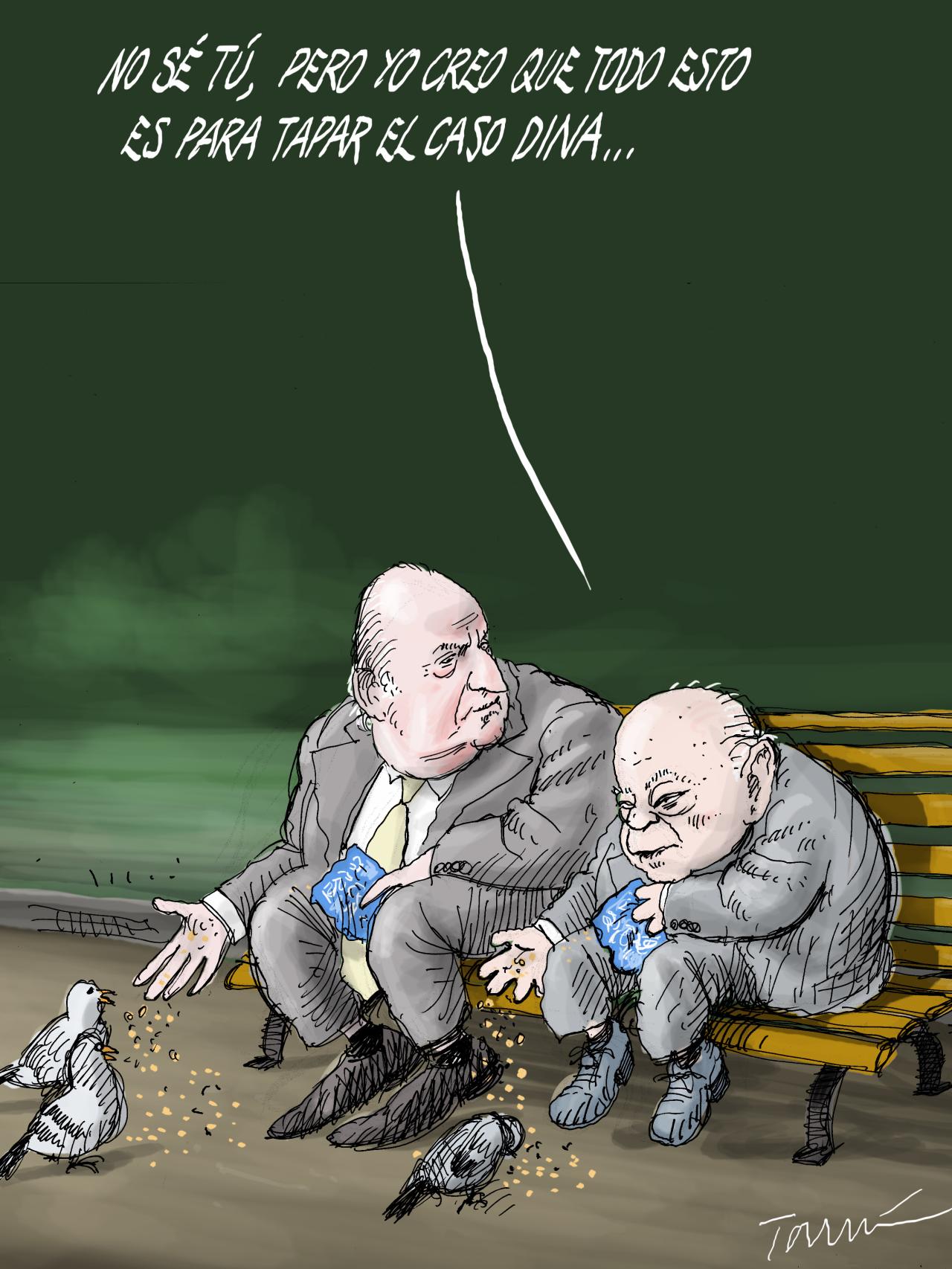

Hagan la prueba. Busquen european art (arte europeo) en Google Imágenes.

Háganlo en inglés, el idioma materno de Google. Si lo hacen en español, en francés o en cualquier otro idioma, los resultados serán diferentes.

No esperen que Google les muestre imágenes de La Gioconda, Las Meninas, La Capilla Sixtina o El retrato de Giovanni Arnolfini y su esposa.

La búsqueda arrojará un resultado muy parecido a este.

¿Observan, por casualidad, un patrón en los resultados? Eso se debe a su sesgo patriarcal, racista y machista. Google es un buscador neutral.

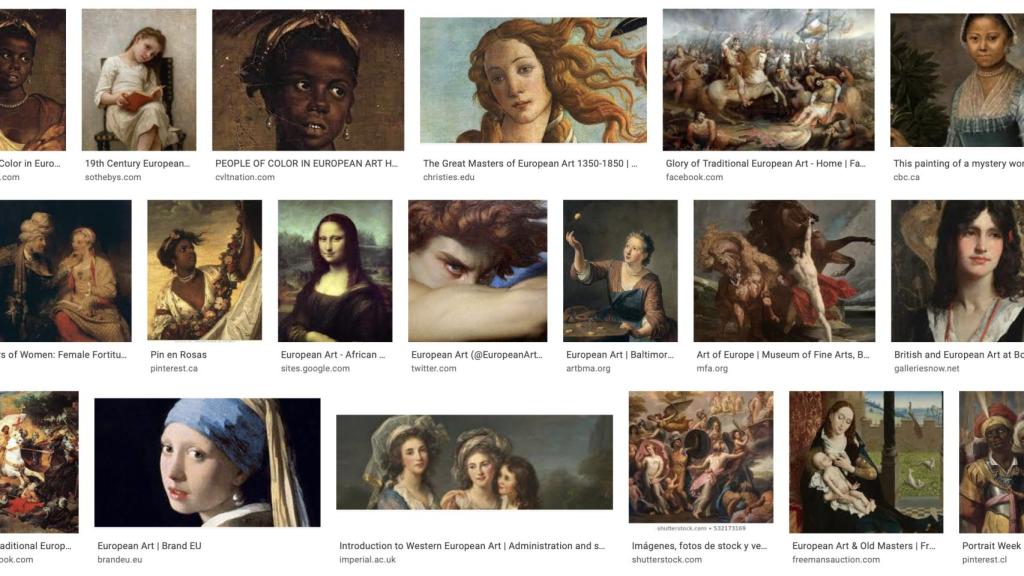

Busquen ahora white men (hombres blancos). Obtendrán unos resultados claramente mejorables.

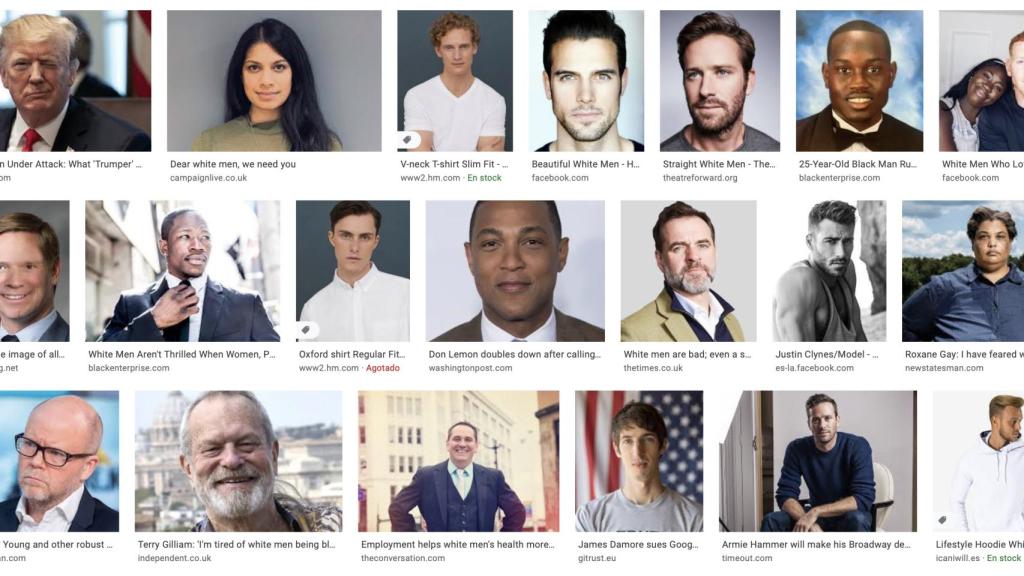

Y ahora hagan lo propio con black men (hombres negros).

Llama la atención la precisión de la búsqueda black men –ni un solo fallo– en contraste con la imprecisión de la búsqueda white men.

Investiguen ahora en los enlaces de las primeras imágenes. Se encontrarán con artículos como Los hombres blancos no saltan de alegría cuando las mujeres y los negros son nombrados CEO, de la revista Black Enterprise.

Un bienintencionado podría pensar que quizá le han dado el Pulitzer a ese artículo y de ahí su privilegiado posicionamiento en Google. Pero no. Se trata de un texto de apenas cuatro párrafos y sin mayor relevancia escrito por la activista Selena Hill.

Encontrarán también un artículo de la escritora feminista Roxane Gay titulado He tenido miedo de los hombres blancos y les he amado. "Durante la mayor parte de mi vida he vivido en lugares donde yo era la excepción, no la norma. He conocido hombres blancos. Les he visto pasar el cortacésped y jugar a softball los martes por la noche".

¡Paren rotativas! Hombres blancos pasando el cortacésped por el jardín de su casa y jugando a un deporte de niños con sus hijos. Por menos han estallado revoluciones.

De este llamativo asunto escribe el periodista británico Douglas Murray en su último libro, The Madness of Crowds. Gender, Race and Identity, todavía no traducido al español.

Murray, que por cierto es gay, hace también la prueba con straight couple (pareja heterosexual). El resultado es este.

Luego, Murray busca gay couple. Y el resultado es este.

Llama de nuevo la atención la imprecisión de los resultados de la primera búsqueda en contraste con la precisión de los segundos. Sobre todo teniendo en cuenta que gay en inglés también significa alegre o exuberante, así que la segunda búsqueda bien podría arrojar decenas de resultados de parejas heterosexuales felices.

A no ser, claro, que Google haya manipulado su algoritmo de búsqueda para que este entienda 1) que gay se refiere siempre a la orientación sexual y no al adjetivo alegre, y 2) que la heterosexualidad es intrínsecamente infeliz.

Hagamos la prueba inversa. Observen este resultado e intenten deducir cuál ha sido el término de búsqueda.

Difícil encontrar un elemento en común en todas esas imágenes, ¿verdad?

Intenten ahora deducir el de este.

No tan difícil, ¿cierto?

Los resultados de la primera imagen son los de white couple (pareja blanca). Los de la segunda, los de black couple (pareja negra). Observen un segundo detalle interesante. La diversidad sexual sólo afecta a los blancos. Cuando buscas black couple, todas las parejas que aparecen son heterosexuales.

Cuando la obvia manipulación de los resultados de Google empezó a provocar quejas, Danny Sullivan, responsable de búsquedas del buscador, dio una excusa muy mejorable:

"Cuando la gente cuelga imágenes de parejas blancas, tiene tendencia a escribir sólo 'parejas' y no especificar la raza. Pero cuando cuelga imágenes de parejas mixtas, entonces sí menciona la palabra 'blanco'. Nuestro buscador depende en buena medida de las palabras, así que cuando no hay palabras, esto puede pasar".

We don't. As it turns out, when people post images of white couples, they tend to say only "couples" & not provide a race. But when there are mixed couples, then "white" gets mentioned. Our image search depends on heavily words -- so when we don't get the words, this can happen.

— Danny Sullivan (@dannysullivan) January 3, 2019

Analicen lo que dice Sullivan. Está diciendo que la culpa no es de Google, sino de esa gente que cuando cuelga la imagen de una pareja blanca no especifica la raza. ¿Y también ocurre eso cuando el que cuelga la imagen es negro? ¿O asiático? ¿O cuando se cuelga la imagen desde la India, o desde Zimbabue, o desde Corea del Sur?

Al parecer, el error de "la gente" se repite también cuando no se habla de raza, sino de orientación sexual. Y también cuando se habla de arte europeo, que nada tiene que ver con la raza o con la orientación sexual.

Es un error muy peculiar, por lo visto.

El miércoles colgué en Twitter algunas imágenes similares a las de este artículo. Algún tuitero recordó que Google ofrece resultados personalizados en función de tus intereses personales. Digamos que si eres un fanático de la F1 y buscas arte europeo, Google debería ofrecerte cuadros de Fernando Alonso.

Sólo que no es eso lo que ocurre.

Decenas de tuiteros hicieron el miércoles la misma búsqueda que yo y se encontraron con prácticamente los mismos resultados. Algunos probaron incluso diferentes navegadores. Otros realizaron búsquedas anónimas. El resultado fue el mismo. De hecho, mis resultados son los mismos que describe Douglas Murray en su libro. ¿Todos tenemos los mismos intereses?

Más bien parece que lo que muestran los resultados de Google no son mis intereses sino los de los programadores de Google.

El libro de Murray se publicó en septiembre de 2019 y es de suponer que lo debió de escribir a principios de ese año. Los resultados no han cambiado un sólo milímetro desde entonces. Si Google ha detectado un fallo grave en su buscador, ¿por qué no lo ha arreglado todavía?

¿Quizá porque no es, en realidad, un fallo?

La explicación se derrumba también por un segundo flanco. Si los resultados son personalizados, ¿por qué a mí me aparecen obras de temáticas que no me interesan en absoluto en vez de obras de Goya, de Velázquez, de arte clásico, del Renacimiento o de las vanguardias del siglo XX, bastante más cercanas a mis intereses reales?

Si leen publicaciones especializadas encontrarán decenas de artículos sobre machine learning fairness (MLF), un término traducible como aprendizaje automático justo. MLF es el proceso de aprendizaje de los motores de búsqueda cuando se intenta que estos esquiven los sesgos humanos.

Un ejemplo clásico es el de las sillas. Si intentas enseñarle a un ordenador lo que es una silla y le enseñas imágenes de sillas con respaldo, tendrá tendencia a reconocer como sillas sólo aquellas que tengan respaldo, descartando los taburetes. Pero si le enseñas que los taburetes también son sillas, entonces pensará que las mesas de tres o cuatro patas son sillas.

Pero, ¿por qué debería Google esquivar los sesgos lógicos –esos que dicen que quien busca el término arte europeo pretende encontrar las obras más relevantes de la historia del arte europeo y no sólo las que muestran esclavos negros o mujeres– y sustituirlos por los sesgos ideológicos de la izquierda?

¿Ha manipulado Google su algoritmo para que las búsquedas de determinadas términos clave no arrojen los resultados más significativos o más precisos, sino los que encajan en la visión de la realidad de la izquierda?

El resultado ni siquiera es coherente. Los resultados son churriguerescos y casi feístas, un pandemonio de imágenes sin relación con el término buscado procedentes de oscuras páginas web escritas por activistas a los que les falta un tornillo. Si Google pretende adoctrinar a las masas, debería depurar primero su algoritmo.

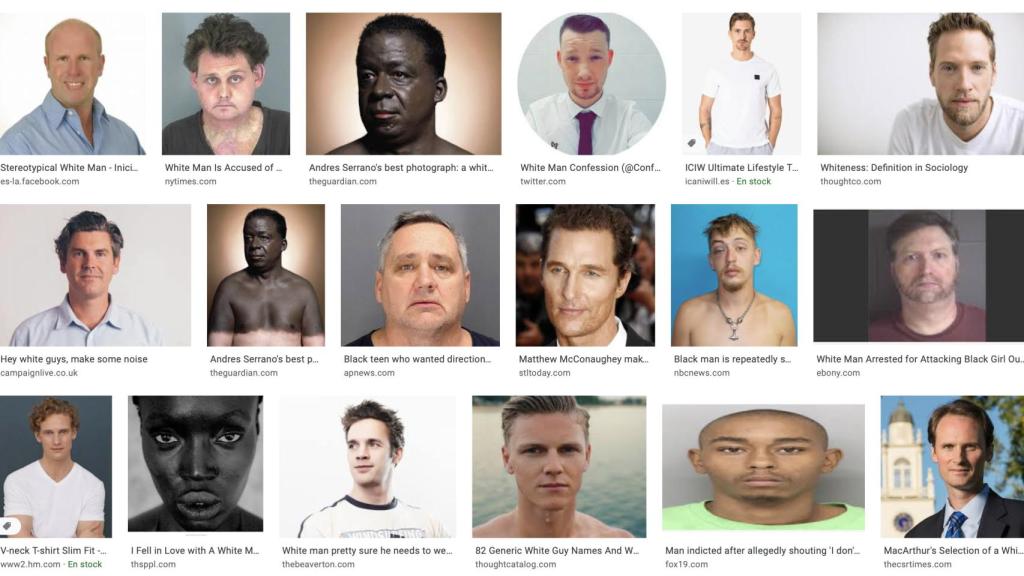

Esto aparece cuando se busca white man (hombre blanco, en singular).

Un puñado de delincuentes acusados de atacar a niñas y a negros, una fotografía de Andrés Serrano de un tipo pintado de negro, un negro, una negra, la foto de un artículo que pretende definir "la blancura" y Matthew McConaughey.

Como en el viejo chiste, acabas preguntándote "¿y Matthew McConaughey por qué?".