Un usuario probando unas gafas de realidad virtual de HTC.

Pasado, presente y futuro de la realidad extendida

Durante los últimos años se ha producido un auge en la aparición de una serie de tecnologías denominadas KETs o tecnologías facilitadoras esenciales (key enabling technologies). Se trata de tecnologías que suponen un salto hacia adelante para la sociedad. Internet fue una KET en su momento; ahora, todos los ojos están puestos en la realidad extendida.

Los estudios de realidad virtual no son nada nuevo. Ya en los 50 se experimentaba con el 3D, y la primera consola con gafas de realidad virtual fue la Virtual Boy de Nintendo, lanzada en 1995. Sin embargo, el progreso en este ámbito se detuvo casi por completo hasta 2010-2011. El cambio lleva el nombre de Palmer Luckey, el emprendedor de 28 años que, frustrado por la baja resolución de las pantallas de RV existentes en el mercado, diseñó Oculus Rift. Palmer unió su camino al de John Carnak, el conocido desarrollador de videojuegos, y junto a Mark Zuckerberg comenzaron la carrera hacia la realidad virtual.

De ello han pasado diez años, y en la actualidad nos encontramos con varios retos. El primero es que el ecosistema de gafas es enorme, tanto de realidad virtual como de realidad aumentada (mis gafas me muestran información y me permiten manos libres pero también veo el entorno en el que me encuentro) y mixta (mis gafas colocan la información sobreimpresa en el entorno). El segundo es la resolución, fundamental para el disfrute de las gafas. En los últimos seis años hemos aumentado de 15 pixeles por grado a 70, y se estima que en tres años lleguemos a 90. Se estima que será en 2030 cuando alcancemos la resolución perfecta y ya no nos sea posible distinguir un entorno virtual de la realidad.

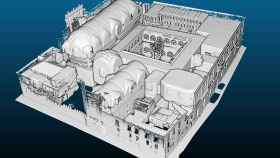

El sector apuesta también por el desafío del mapeo espacial. Los dispositivos (las gafas) deben ser capaces de analizar y entender el entorno e interactuar con él, para poder tener una sensación de realismo o poder caminar por un entorno evitando choques. El objetivo final es poder copiar y reproducir espacios existentes para movernos por ellos de forma virtual. Para ello se están haciendo avances en fotogrametría digital, y también será decisiva la inteligencia artificial.

Otro reto es la interpretación de las luces en tiempo real, algo técnicamente muy complejo al ser miles de luces las que interactúan con los objetos en un entorno real. Esto requiere una capacidad de procesamiento casi imposible… casi. Las nuevas tarjetas ya empiezan a ser capaces de generar luces que son reaccionadas por objetos en movimiento. Junto con el de las luces, está el reto de capturar el movimiento del cuerpo del usuario para reflejarlo en un avatar. Los trajes actuales son todavía un poco aparatosos, pero se desarrollan cada vez mejores dispositivos de tracking, entre los que cobra cada vez más relevancia la capacidad de sincronizar el movimiento de ojos y labios, siempre en busca del realismo extremo.

Tenemos, por lo tanto, espacios realistas, avatares que se van a mover, van a hablar y a gesticular como nosotros… ¿Qué nos falta? Nos falta sentir. Lo lograremos gracias a las tecnologías hápticas: los dispositivos más comunes son los guantes hápticos, pero también existen trajes de cuerpo completo. Estos dispositivos nos permitirán percibir textura, calor, frío, presión, peso, resistencia… todo ello en un entorno virtual.

La clave y la verdadera oportunidad de todos los retos que he enumerado anteriormente está en la teleexistencia, y es especialmente relevante en el entorno empresarial e industrial. Es el siguiente paso a la telepresencia: hasta ahora podía ver un lugar remoto a través de mis gafas, pero con la teleexistencia podré conectarme a un robot remoto y ser el robot, que se moverá como yo.

Por ejemplo, se está experimentando con la teleexistencia en proyectos como la Plataforma eXist, que nos permite ver cómo la inteligencia artificial y el edge computing podrían crear entornos colaborativos entre humanos, robots y sistemas de realidad aumentada y virtual. Nos permite interactuar, por ejemplo, con compañeros que están trabajando en remoto, en un espacio virtual reflejo de la realidad y a través de avatares que se comportan como nosotros e imitan nuestro aspecto.

Una persona en una fábrica puede recibir ayuda en remoto y gracias a sus gafas ver, en la propia fábrica, al asistente desplazándose por el espacio, indicándole qué máquinas activar o qué botones pulsar. Lo llamamos “holollamada”. Si además añadimos robots a esta ecuación, el asistente puede controlar en remoto un robot a través de gemelos digitales y ejecutar él mismo las reparaciones. El potencial a corto medio plazo es infinito.

De las gafas de realidad virtual iremos, por lo tanto, a captura de movimiento corporal, sincronización de ojos y labios, avatares reales y sensaciones. A este conjunto lo llamaremos “mi yo virtual”, será nuestra copia digital, de forma similar a como ocurre en la película Ready Player One. Si le sumamos la capacidad de procesado XR, replicamos de forma realista las luces y mejoramos los entornos virtuales con IA, tendremos a nuestro yo virtual en un entorno totalmente real. A su vez, si añadimos la latencia y calidad de servicio de las redes 5G, edge computing y dotamos a los robots de sentidos… alcanzamos un yo real, pero no en un entorno virtual, sino real. Una réplica de nosotros capaz de operar en el mundo real.

Esta revolución tecnológica tendrá un enorme impacto no solo en nuestra vida personal, sino también en la profesional. Estamos deseando ver qué nos depara el futuro.

*** Carlos Méndez es Innovation Technology Manager de Capgemini Engineering en España