Jose Manuel Mateu de Ros, fundador y CEO de Neosmart.

El desafío ético de la IA: crear organizaciones responsables

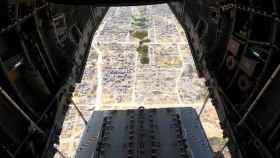

En febrero de este año, Gemini, la herramienta de Google capaz de crear imágenes con inteligencia artificial, intentó reorientar sus algoritmos hacia un enfoque más ético que evitase la discriminación racial que se venía repitiendo en sus creaciones.

Sin embargo, el resultado fue que, por ejemplo, al pedirle que representara a figuras históricas acabó generando imágenes de soldados nazis afroamericanos o ilustrando a los fundadores de EEUU con rasgos indígenas.

Estas incongruencias con la realidad obligaron a la compañía a cerrar el servicio de forma temporal. Este hecho no hace más que evidenciar las complejidades de la IA y cómo esta, de no ser comprendida e integrada de forma responsable, puede dar pie a procesos que perpetúen sesgos y acaben afectando a la reputación de las compañías.

Ante esta situación, las empresas están buscando soluciones que pongan freno a los riesgos de esta tecnología. El marco regulatorio no se lo está dando, ya que nos encontramos ante un proceso desacompasado en el que la evolución de la inteligencia artificial va por delante de la legislación.

Este desequilibrio hace que las empresas, en su búsqueda por capitalizar las ventajas de la inteligencia artificial y no quedarse atrás, estén comenzando a desarrollar políticas propias. De hecho, según un sondeo realizado por Bloomberg a finales de marzo, más del 50% de las compañías están estableciendo sus propias normativas para regular el correcto uso de la IA.

Los desafíos, que las empresas tienen que abordar de forma urgente, están relacionados con la privacidad de datos, utilizados para entrenar y operar los sistemas de IA y cuyo tratamiento influye notablemente en la confianza de los usuarios; la transparencia, a través de la que se tiene que proporcionar información clara sobre cómo funcionan los algoritmos, bajo qué condiciones se usan y cómo se toman las decisiones; y, por último, la prevención para no perpetuar sesgos, y asegurar que las aplicaciones de IA no discriminen a ningún grupo de personas.

Para ello, las empresas han creado una amalgama de normas distintas sin una comprensión profunda de cómo el diseño algorítmico y la selección de datos pueden influir en los resultados de un sistema de IA y sin un alineamiento con estándares globales que se puede traducir en riesgos que reduzcan la confianza por parte de sus usuarios y, por lo tanto, las empresas terminen creando daños y no siendo capaces de rentabilizar la inversión tecnológica.

Las investigaciones de Joy Buolamwini, reputada ingeniera informática y activista digital, han puesto de manifiesto cómo los sistemas comerciales de reconocimiento facial muestran un rendimiento dispar según el género y el color de piel, siendo el grupo más afectado el de las mujeres de piel oscura debido a la falta de representación en las bases de datos de entrenamiento.

En el ámbito financiero, los algoritmos de IA empleados para la asignación de préstamos o límites de crédito pueden también manifestar sesgos, como en el caso reportado donde, a pesar de tener ingresos, gastos y deudas similares, una mujer recibió un límite de crédito notablemente inferior al de su marido.

Otro ejemplo es el uso de sistemas de traducción automática, como Google Translate, que pueden perpetuar estereotipos de género al asignar géneros específicos a profesiones o roles en traducciones. Un caso muy relevante es la asignación del género femenino a palabras como "cleaner" mientras que a otras como “doctor” siempre se atribuía el género masculino.

Para navegar este complejo paisaje tecnológico, ético y legal, es crucial que las empresas busquen la colaboración con expertos en IA, informándose y formándose sobre los desafíos y mejores prácticas en la implementación de estas herramientas.

Sin seguridad, transparencia, inclusión y responsabilidad no habrá confianza de sus clientes y, por tanto, tampoco beneficios ni escalabilidad. Considerando la encuesta realizada por Andreessen Horowitz, el año pasado, el gasto medio de las compañías en API de modelos básicos y personalizados de IA fue de siete millones de dólares.

En lo que queda de año, estas empresas aseguran que aumentarán, entre dos y cinco veces, su inversión. Para implementar y escalar la IA generativa, uno de los requisitos fundamentales es que todos los empleados sean capaces de utilizar de forma responsable las herramientas más avanzadas de IA generativa, y estar expuestos de forma constante a diversos casos de uso para comprender lo que es posible realizar con la IA, identificar sus limitaciones, prever posibles problemas y aprender cómo gestionarlos. Una formación continua transformará a los trabajadores en los profesionales altamente cualificados que las empresas necesitan.

Además de la formación para fomentar un uso responsable de la IA, las empresas deben desarrollar un marco de gobernanza que especifique claramente las responsabilidades y establezca procedimientos de rendición de cuentas, incluyendo auditorías regulares tanto internas como externas, así como canales para que los stakeholders reporten inquietudes o irregularidades y monitoreo continuo, permitiendo ajustes ágiles ante cualquier riesgo detectado. Todo ello, con el debido asesoramiento de expertos.

Las organizaciones que lideren con el ejemplo en la implementación responsable se distinguirán en un mercado cada vez más saturado y competitivo, construyendo una marca de confianza y lealtad entre los consumidores.

Por lo que no solo ayudarán a construir un futuro más justo sino que serán capaces de multiplicar sus beneficios a la vez que mitigar riesgos legales y reputacionales. Así, la responsabilidad ética se convierte no solo en el cimiento para el éxito y la escalabilidad a largo plazo, sino también en el distintivo de las empresas que prosperarán en la era de la innovación tecnológica.

***Jose Manuel Mateu de Ros es fundador y CEO de Neosmart.